英語の文章が画像に!

背景に使うか?イラストのアイデア出しはもちろん、

与える英文を捏ね捏ねして思いがけず生成される秀逸画像ガチャで遊ぶのも楽しい

有料サブスクで商用利用まで可能なAI画像生成サービス

★★★ 注意 ★★★

ここは既存のAI画像生成サービスの”””具体的な”””技術や動向について語り合うスレです

漠然としたAI画像生成の未来や、イラストレーターの職権侵害等の一般的な話題は明確に【禁止】します

(他のスレがありますのでそちらに移動してください)

前スレ

【Midjourney】 AI画像生成 【DALLE】

http://2chb.net/r/cg/1659786388/ StableDiffusionの人の他社製品比較

https://twitter.com/EMostaque/status/1561349836980584455

・StableDiffusion、DALLE2、midjourneyは全て異なるものだ

・この分野は、去年(2021年1月)にOpenAIがCLIPを公開したことで始まった

これにより画像生成のガイドが可能になった

●DALLE2

・モデルかつサービス。インペインティングは最高の機能だが、ランダムなのでアイデア出しやより企業的な用途に最も適している。

・来年にはコストが10分の1以下になりAPIも公開されると思われる

・トレーニングデータは著作権のあるイメージなので、オープンソースにはならないと思だろう

●MidJorney

・VCの資金提供を受けたベンチャー、ではなく研究所

・非常に独特な絵画のようなスタイルを持っている

・一貫性に膨大な労力が必要。ランダム性が強いがある程度コントロールは可能

・オープンソースとそうでない部分がある。

●StableDiffusion

・アートからプロダクトまで、あらゆるタイプのイメージに対応する一般的な基礎モデルでもうすぐリリースされる

・まもなくDreamStudioプロシューマーサービスを発表する

・今まで皆さんが見ていたものベータ版のモデルテストから得られた生の出力で、前処理も後処理も行っていない

これらを使うことで格段に良くなり、きめ細かいコントロールに力を入れた

・オープンソースのモデルなので、誰でも使うことができる。コードもデータセットもすでに公開されている

そのため、誰もがこのモデルを改良し、構築することができる

https://twitter.com/5chan_nel (5ch newer account) テンプレはまぁ黎明期なんで適当で・・流動的に

スレが今後も続くなら勝手に追加or削除してください

DreamStudio垢作って入るとこまで来たけど

パラメーターの意味やコマンドの説明とかどこかにない?

Cfg Scaleはだいたいどのくらい近づけるか

Stepsはなんだろう、そのくらい拡散させるか?で高い方が消費する?

あと、無料の残り回数ってどうやったら見られるんだろう

MJと違って説明してるサイトみたいなのが皆無でわけがわからない

わかった

右上の自分の垢アイコンクリックしてmembershipに「£」って単位である

*** generationsっておおよその残りが表示される、下に購入もある

あと左のaccount settingsからsafe mode(NSFWフィルター)のオフがあったみたいだけど

今の無料verでは現状外されてる?らしく、どこにも見当たらない

cfg scaleはデフォの7(少なくとも5あたり)にしとかないと文字通りのが出てこない、MJの--sの逆みたいな感じ

stepはどれだけ精彩にするかみたいな感じ?MJの--qに近い感じか

steps 50のデフォ設定で無料の2.000が0.02減るので、無料では100回試行可能

クオリティ上げるとそれ以下になる感じ、steps 10の最低だと0.004減った、cfg 7でも凄くいい加減な抽象画みたいに

デフォのA dream of a distant galaxy・・の文字列がいちいち入るのはなんとかならないんだろうか

craiyonで練習してMJ使ってきたが俺はcraiyonの方が好きだったな

MJは俺には絵画的すぎた

craiyonって旧名Dalleminiなんだっけ

じゃあDalle2が後継なのかな?

すごいと噂のSDも次やってみたいけど

使い方ぜんぜん載ってないな

DSは正式にはDreamStudio Liteなのか、無料はliteなのかよくわからん

どのみちSDのDiscord終わったから、他人のテキストがパクれないのが辛い・・

MJはそでれかなり勉強させてもらったんだけど

redditでだいたい書いてる人いるけど、すべては明かしてない感じだし

£100で10K generationsだから、1回0.01ポンド、1.61円か

MJのFastモードの1/4くらいだけど、MJは無料のRelaxで期間中はいつまでも生成できるからなぁ

使い切った後の無料で作った枚数の方がもう多くなったよ、気楽だし

その人Midjourneyで生成したこと伏せて投稿し始めたからモヤる

>>15,17

メイドインアビスの人物は自分で書いてる気がする。

ナナチっぽいケモノ耳キャラはMidjourneyでmade in abyssとすれば出てくるけど、リコやリグは多分出す方法がないはず

その辺ちゃんと書いてくれると参考になって嬉しいけど、今後はわざわざ書かなくなる人が増えそう >>21

こいつらほんとおっぱい好きだな・・

>>22

4chanお祭り騒ぎだね

彼らにはめっちゃ期待してる Stable Diffusionはネットに繋がないローカルPCで使えるの?

見た感じ無料で何回でもローカルで使えるけど最低でもVRAM10GBは必要かな?

もし3080以上要求されるならちょっとハードル高いよな

980ti(VRAM6GB)でやったらCUDAがねぇよって止まった、対応してるGPUなのに

ドライバとかCUDA toolkitとかインストールしてたらPC立ち上がらなくなってセーフモードから復元

・・諦めた

>>29

なるほどサンクス

dreamstudioはウェブ版って感じなのね

完全にローカルで動くなら、肖像権上等、ロリ、エログロみたいなアウトも出力するAIが遠からず出るんだろうな

そしてそのAIを保有してたらアウトな法律も追って出るだろうし

アダルト特化AIが出るのを待つか‥速攻でDLして金庫に補完するか‥ 会社のPCで早速やってみた

無限に生成できるの草だわ

フィルターもないし当分楽しめそう

>>16

自己レス

> MJのFastモードの1/4くらいだけど

DSは512x512で、MJは1024x1024なんだから当たり前の話だった

とりわけMJが高いわけではない DreamStudioやろうとして、間違えてStableDiffusionのサブスクリプションの登録をしてしまった。登録解除フォームが見当たらなかったから問い合わせからサブスク解除希望送ったけどこれで大丈夫でしょうかね、、、アホですみせん。

あれは放置したままのあのサイトが悪い

当時一旦切られたDiscordのStableDiffusionの無料βの追加募集フォームだったんだけど、事態が早く動いて尻切れトンボ

もうDiscordのSDそのものが閉鎖されて普通に有料サブスクまであるDreamStudioが動いてるのに

自分も登録したままだけどなんの音沙汰もないけど、

同じメールアドレスの登録で普通にDreamの方使えたし一切気にしなくてOK

無視無視

GTX1080(VRAM8GB) Windows11 WSLで低VRAM版が動いてる

苦労したのはgit lfsインストール前にcloneした学習データでエラーが出てたことに気が付かなかった事

>>38

ありがとうちょっと安心した。

メールアドレスだけだからそもそも何も金かからんとは思うけど

サブスク=金かかるって気がするからちょと怖かった。 設定が分からんグラボの設定とかあるのかな結構時間がかかる

こんなもん?

this image was not displayed because our detecion model detected unsafe content

こんなん出たんだけど、表示するにはどうすればいいの?

今はGoogleでStable Diffusion試みてるんですけれどパイプラインの準備ってところでエラーでて進みません。

このでコマンドの書き換えとかあるのでしょうか?

>>46

どこかの実行を飛ばしてしまってるか、Hugging faceのアクセ設定ができてないかじゃないかという気がするけど

(1)使ってるノートのURL

(2)実行した各項目のスクショ

(3)エラー内容のスクショ

があればなにか分かるかも 使いたいけどプログラミングとか全然分からない

img2imgとかもどうするんだStable Diffusionをローカルに取り込んだらエロも描かせれるのかな

img2img は txt2imgよりメモリ食ってる気がする

うちは8GRAMだから高速版は448x448が限界で7.8〜7.9G消費

そのサイズでimg2imgだと落ちるから少し小さいのじゃないと回らなかったよ

>>52

> (2)実行した各項目のスクショ

> (3)エラー内容のスクショ

名に書いてあるかコピペでも手書きでもいいし

みんなエスパーじゃないんだから・・ 失礼、名に→何

実行結果がズラズラ出てるところにまさかカタカナで「エラー」とだけ出てるわけじゃないでしょ?

> パイプラインの準備ってところでエラーでて進みません

>>52

今やってみましたけど問題なく動きますね。なんだろう?トークンのコピペミス、コードのコピペミスぐらいしかないような

---------------------------------------------------

!pip install diffusers==0.2.4 transformers scipy ftfy

YOUR_TOKEN="<ここだけアクセストークンに書き換える>"

from diffusers import StableDiffusionPipeline

# StableDiffusionパイプラインの準備

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4", use_auth_token=YOUR_TOKEN)

pipe.to("cuda")

prompt = "japanese cat skipping"

image = pipe(prompt)["sample"][0]

image.save(f"japanese_cat_skipping.png")

---------------------------------------------------

また、ガイドはシンプルなので基本の勉強のため良いと思いますが、実際に使うなら>>43のリンクのノートの方が便利だと思います。 Gigazineの試したけど俺もhuggingfaceのapiアクセスで403エラーになった

>>0053

>>0054

お騒がせしてすみません!自己解決できました!

どうやらアクセストークンの入力時が原因でした。

トークン入力時にサンプルの余計な文字を残したまま実行をしていたみたいで…。

そのコードのとこだけだと実行して間違っていても緑チェックはついてしまうのですね。

結果その次のパイプラインのコードでエラーをはいても、トークンにはチェックがついてて原因はパイプラインの方にある……と思い込んでしまいました。

本当にお騒がせしました…

Midjourneyのブラウザから見られるコミュニティページの自分の名前を変更する方法はありますか?

気に入ったユーザーをフォローしたいのですが相手に名前を知られたくないので適当な名前にしたいです

>>57

解決したなら良かったですw

これやってみてちょっと気になったのが、これ>>43の2番目のノートよりかなり遅いですね。

image = pipe(prompt,height=512, width=512,num_inference_steps=50,guidance_scale=8.0,)["sample"][0]

Gigazineのガイド: 1.80 it/s

>>43の2番目のガイド: 3.8 it/s

#StableDiffusionの実行時間はプロンプトによらず大体ステップ数に比例するので 50ステップで 3.8 it/sなら 50/3.8 = 13.2秒

それぞれ2回やってみましたが結果は同じでした。2回だけなのでたまたまということもあるかもですが もしかしてStable Diffusion産のロリエロ流行りだしたらai潰される可能性もあるのかな…?

>>60

Colabはインスタンス割り当ての時にGPUガチャが発生するから

遅いGPU割り当てられただけじゃねえの ちなみに512x512で、ざっくり性能でこんな感じ

● it/s =1秒で実行できるステップ数

980 0.36 it/s (2.81 s/it)

1070Ti(8GB) 1.60 it/s

1080Ti(11GB) 2.30 it/s

Google Colab(T4) 3.2 it/s ~ 3.8 it/s

2060 4.6 it/s

2080Ti 7.3 it/s ~ 7.73 it/s

1080Tiと2080Tiは https://rentry.org/kretard

Google Colab(T4 15GB)はこれ https://colab.research.google.com/drive/1jUwJ0owjigpG-9m6AI_wEStwimisUE17#scrollTo=Ucr5_i21xSjv

プロンプトはこの条件で測定しました。プロンプトは性能に関係ない気がしますが一応

beautiful long haired anime girl, fire dress, portrait, flames everywhere, highly detailed, digital painting, artstation, concept art, smooth, sharp focus, illustration, art by artgerm and greg rutkowski and alphonse mucha

Steps: 50, Sampler: k-diffusion, CFG scale: 15, Seed: 1 >>64

かもですね。

いまいちわかってないんですが遅いT4と速いT4ってあるのかな・・・ >>64

あんまチェンジしまくると目つけられるらしいね・・デ○ヘルみたい 自宅でAIにエロ絵なんていくらでも作らせる時代に規制なんて無駄…

とはならずに普通にアップルやグーグルやMSにPCやスマホの中身まで

リアルタイム監視されて通報されるようになるだけだよな

既にグーグルもアップルもクラウドやメールは監視して自動通報してるし

それが自宅の端末にまで適用されるだけ

>>61

名前がペンネームと同じなので変えたいのです

ディスコサーバーの名前も変更しても、ブラウザ版のコミュニティページには反映されておりませんでした

画像はプライベートモード課金して全部隠しています 完全ローカルでネット遮断で動かせる、ロリ、エログロokなAIがリリースされたらすぐにDLして保存しなければならない

まあそれの単純所持も規制されそうだが

>>74

丁寧にありがとうございます

ブラウザ版というのは、ブラウザ版discordのことではなくて

Midjourney側の「Community Feed」などのページのことです

そこで自分のプロフィールを「View as visitor」モードに切り替えても名前が最初に設定したペンネームのままなんですよね

ブラウザのMidjourneyのページにプロフィールを編集できるような設定箇所が見当たらないので、名前を変える方法が無く困っています DreamStudioで頑張ってみたけどこのありさまです

Midjourneyでやってみてけど気持ち悪い物しかできません

どなたか可愛いアニメの少年少女出す呪文を教えてください

DreamStudioのほうが使いやすいですね

ディスコは疲れる >>77

インターネットホットラインセンターに連絡しておいたのでそっちに聞いてください 今更midjourney遂げた凄まじい進化に驚愕してる

こりゃ今年中に来るかもしれんな

AIが実用的なエロ画像を生成出来るようになる時が

>>80

Colabよりめっちゃ速いですねw

Advancedオプションもあるし、text2imgならこれでいいかも ①適当な指示絵で髪の色や顔の形を指示

②img2imgで変換して好みの画像を選ぶ

③破綻した部分を大雑把に直す 謎のオブジェとか余分に生えた腕を消す

④重みを弱くして再変換

画像は出力画像が再入力できるからヤバイよ

②~④を繰り返せばそこそこ好みの絵ができたよ

>>85

なかなかヒントが少ないけどw

--> 116 "You specified use_auth_token=True, but a Hugging Face token was not"

117 " found."

もしこう出てるならトークン未設定か、huggingface_usernameかhuggingface_tokenが間違ってる >>71

kretardってやつ試したけどVRAM4GBだとメモリ不足で動かなかった

basujindalフォークoptimise版ならできたけど ゲームやらないしGTX980で十分だわと思ってたけどグラボ買っちゃう勢いの技術だな

ただColabに毎月1000円課金する方が安く済むならそっちが良いけど、

課金しても無限にGPU使えるわけじゃないっぽいから悩むなぁ

>>82

わいが入力してた絵師の名前があって同じこと考えてんだなと

絵師の名前入れるの割と重要みたいね ローカルで動かすのややこしいんだね

DLインストールしてポンとは行かないのか

マイニングだけじゃなくてイラスト作業でもGPUを酷使するのか...

日本でグラボが短期的に高騰しそう

オープン技術の黎明期あるあるだね

ちょっとしたらGPUある人向けにGUI組み込んだフリーソフト作る酔狂者が現れるかもしれない

>>94

redditにgimpのプラグインっぽいスクリーンショットあげてる人いた >>87

このcolabのFor Gdriveってとこにあるuser_pathとfile_nameってなにをいれたらいいんですか? 呪文教えてくれって言ったのに全く反応がないのは

やっぱ出来が悪いのしか作れていないから?

難しいんだねぇ

自分的には力作で気に入ってるけどUP出来ないのも

けなされるのが怖いから?

プロンプトの効果ってバージョンアップごとにごっそり変わりそう

っていうか何なら日々の学習で流動的に変わってそう

人間に特化した、ちゃんと人間の顔と身体を理解してるAIモデルって作れないのかな?

現状だとちょっと精度低すぎて顔崩壊しすぎる

MJは256角4枚を俯瞰して好きなのを選んでアップスケールで1024角だから作った瞬間映えるんだよな

DreamStudioはいきなり1枚512角が最低ラインなんでゴミに金払わされる

・・あれ?逆かMJこそ無駄に作成させられてる?わからん

すいません、stable diffusionのimage to imageのやり方がよく分からないのですが、どこかやり方が載ってるところってあります?

>>97

前スレでずっと無視されてた人か

単にせっかくコツコツ試行錯誤して編み出した呪文をなんの見返りもなく教えたくないからだろう

ツイッターとかでも公表してる人あんまいないよ、しょーもない実験風のは書かれてるけど

852話とか言う人もかなり前だがキャラ設定画みたいなののレシピをさんざん上げてから公開してたし

だから>>82はありがたい

MJはDiscordでのぞき見できるから捗ったんだけど

Discordβ終わったSD(DS)はβやれなかった自分には手探り過ぎて放置してた 地味に、自分が吐き出した画像って愛着あるよね?ゴミでもなんか捨てづらい

これから動画も増えるだろうし、GPUもだがHDDも需要が増えるな

いいpromptを教えろって言ってもどの言葉がどの程度作用してるのかさっぱりわからないんだよな

4kとかunreal engine5みたいなキーワードはあっても結局運だし

俺もポーズごとやアングルの定石が分かれば嬉しいと思ってるけど、現状を見るにそういうのはなさそう

今って選択肢が多すぎてワケワカ状態だな、SD系はもうなにがなんやらi2iまで言い出したら

ちょっと置いた方がいいかもしれん

自分はbetaで活気ついたMJいじりながらボロPC買い替えにでも動くか

>>99

リアル人間のなら2桁くらい公開されてるんじゃね

最近はファッションモデル用のAI素体を提供してる所もある >>82

わお、これは素晴らしすぎる

どこからデータ拾ってるんだ >>107

オカルトみたいな呪文も結構乱発されてんだよね

効いてるかは入れる場合と入れない場合の同seedでしっかり確認してから使うべき

MJはseed指定が一般的じゃなかったのでもうほんとオカルトで3行とかなってる人がザラにいた 今は自動イラスト生成黎明期で、本格的になるのは一部修正機能がとかより細かい絵柄の指定が実現できる学習済みモデルが配布されてからかな

今後は学習済みモデルでひと悶着ありそうだ

詠唱だのプログラムだので必死になる人達は良くも悪くも凄いな

どうせ来月にはもっと簡単お手軽になってるでしょ

俺はパソコン大先生じゃないから今は見て楽しむだけだな

あんまり長く書き連ねると途中で強制カットされるはずだぞ

トークンっていう言葉の固まりに上限数がある

最後の隠し味にと最後に書いた一文が丸々効いてないなんてことも

>>107

https://rentry.org/kretard このUI限定かもしれないけど、

create prompt matrixにチェックして、プロンプトのキーワードを | でつなぐとそのキーワード有り無しが出ますね

例えば

girl | on the beach | oil painting

とすると、以下の4枚の画像が生成されます。

- girl

- girl on the beach

- girl oil painting

- girl on the beach oil painting

1ワードずつ効果を探ってられないですが、高解像度のキーワードのあり・なし、効果を見るみたいな使い方なら便利かも >>82

うまいのいっぱいあっていいね

イラストレーターの名前入れるのかなり影響あるから

いい雰囲気のプロンプトはチェックしとこ >>110

個人が公開してるわけないから、たぶんDiscord時代のログみたいなのから生成してるのかなぁ

日付がそんな感じの古さ Emad (Discord)

Q Dalleのようなプロンプトでのインペインティングか、自動インペインティングかどっちかサポートする予定ないの?

A 両方でいいじゃん

SDにimg2txtみたいなものって無い?

イメージに近い画像1枚渡すからどういう単語を求めてるのかのヒントが欲しくて

別のRecognize系API使うしかないのかな

>>119

それはGdriveに既にmodelを保存している場合に実行するもので、その上の

!gdown ・・・

か

%cd stable-diffusion/ ・・・

かどっちかを実行していれば不要だと思います。

このノートは初心者には難しい >>82で好きな絵探して呪文メモするのにはまってる

みんないろんなアーティスト知ってるな、というかDiscord時代に皆で試行錯誤した集合知なんだろうけど >>119

ついでにその下のHuggingfaceもいらないと思います。

後、Optimized SDの下のSetup、Settingなどもいるのか要らないのか私には分かりません。よく読めば分かるんだろうけど Colabでの出力だとシード数という概念はない感じ?

一回出た画像を再度出力とかは無理で保存するしかない感じ?

>>104

そうじゃないと思うよ

教えたとしても同じものは作れないんだろ?

やっぱけなされるのが怖いんじゃね? >>104

lexicaおしえてくれてありがと

DreamStudioと同じアイコンなのね >>128

ありがとう

自分で調べて構築しなくてもめっちゃ便利な定型システムが用意されてたんだね…

そっちに移ります… 佐藤航陽 著書「世界2.0 メタバースの歩き方と創り方」 @ka2aki86 (2022/08/25 02:02:11) [返信:フォロー/@のみ]

物理世界における視界は、AIにレコメンドされたYouTubeやTikTokのタイムラインのようなものだな。帰り道の解体跡地にどんなビルがあったかは覚えてないけど、自分が好きなアーティストの看板があればすぐ認識できる。物理世界も仮想空間も自分が気になってるもの以外は表示されないし認識もできない。

https://ohayua.cyou/tweet/1562485434235879424/ka2aki86 >>125

多分Settingの前に上の Set upを実行していないのではないかと思います。 >>43

これのローカル環境ってやつがんばって試してみたけど

セットアップ完了していざ試したら

Traceback (most recent call last):

File "scripts/webgui.py", line 5, in <module>

import gradio as gr

ModuleNotFoundError: No module named 'gradio'

って文字がでてダメだった……

なにかを間違えたんだろうけどさっぱりわからん

難しいなぁ >>135

gradioはこの手順でダウンロードされるのでどちらか抜けているのでは

ステップ 5:新しいenvironment.yaml をダウンロードして waifu-diffusion-main に配置し、古いものを置き換えます (すべてのファイルとして保存します)

ステップ 10: 次のコマンドを実行します: 「conda env create -f environment.yaml」を実行 後、これをやってない可能性もあるかも

ステップ 12: 次のコマンドを実行します: "conda activate ldx"

>>136

ありがとうございます。

思い返せば、このステップ5をよく理解せず、やった覚えがあって、

ステップ5で自分のやった手順を詳細に書き起こしてみます

https://pastebin.com/6gpWFLa4

↑のURLにログインする

ログインしたページの右上にあるdownloadを選択

environment.yaml.txtを取得

名前を変更して.txtを削除

それからwaifu-diffusion-main に配置

って手順でやりました……

素人なんでほぼフィーリングでやりました

このやり方が間違っていたんですね…… >>138

その手順はあってる気がします (ログインは不要、元々あったenvironment.yamlは削除したと思いますが) >>140

本当ですか……

ミラーとか元テキストとか意味がわからず無視したんですけど

これらって結局必要ないんですかね……? >>141

あれ?勘違いしてたかな

>>138の手順をやってenvironment.yamlを配置したんですよね。それでOKですという意味でした。

必要な手順です

mirrorやraw textはこちらからもダウンロードできます、ということなので、3つやる必要はありません。 >>142

mirrorやraw tex必要ないんですね

ありがとうございます >>143

srcに既存フォルダが有るとそうなると思います。

ステップ 9: /src に既存のフォルダーがある場合は、次のステップの前にそれらを削除します。

これが抜けてるのかな conda env create -f environment.yaml を2回実行した(多分、初期のファイルで実行した後、ダウンロードしたもので再実行?)と思われます。

一旦、

conda env remove -n ldx

で削除してから、再度conda env create -f environment.yaml をやればいいと思います。

>>147

できました!

ありがとうございます

またどこかでつまるかもしれないけど、これで前に進めます! うわぁああああ、また新しいエラーがでたぁああ

いつになったら、好きなエロい画像を作れるんだ……

>>149

いい出来ですね!

各パラメータそんな小さい数字で調整して行くんですね。参考になります。

この絵からこのワードを足すとこれ、みたいに画像ををツリー状で操作できるようなUIとかあると便利そう。

誰か作って欲しい >>149

--strength 0.3 --n_iter 2 --n_samples 5 --H 576 --W 768

-- ← このハイフンみたいなの2個は付けないとエラーになるの?

こういう約束事みたいなのが全然わかんないw >>154

If your output is solid green, the half precision optimization may not be working for you:

GREEN SCREEN FIX:

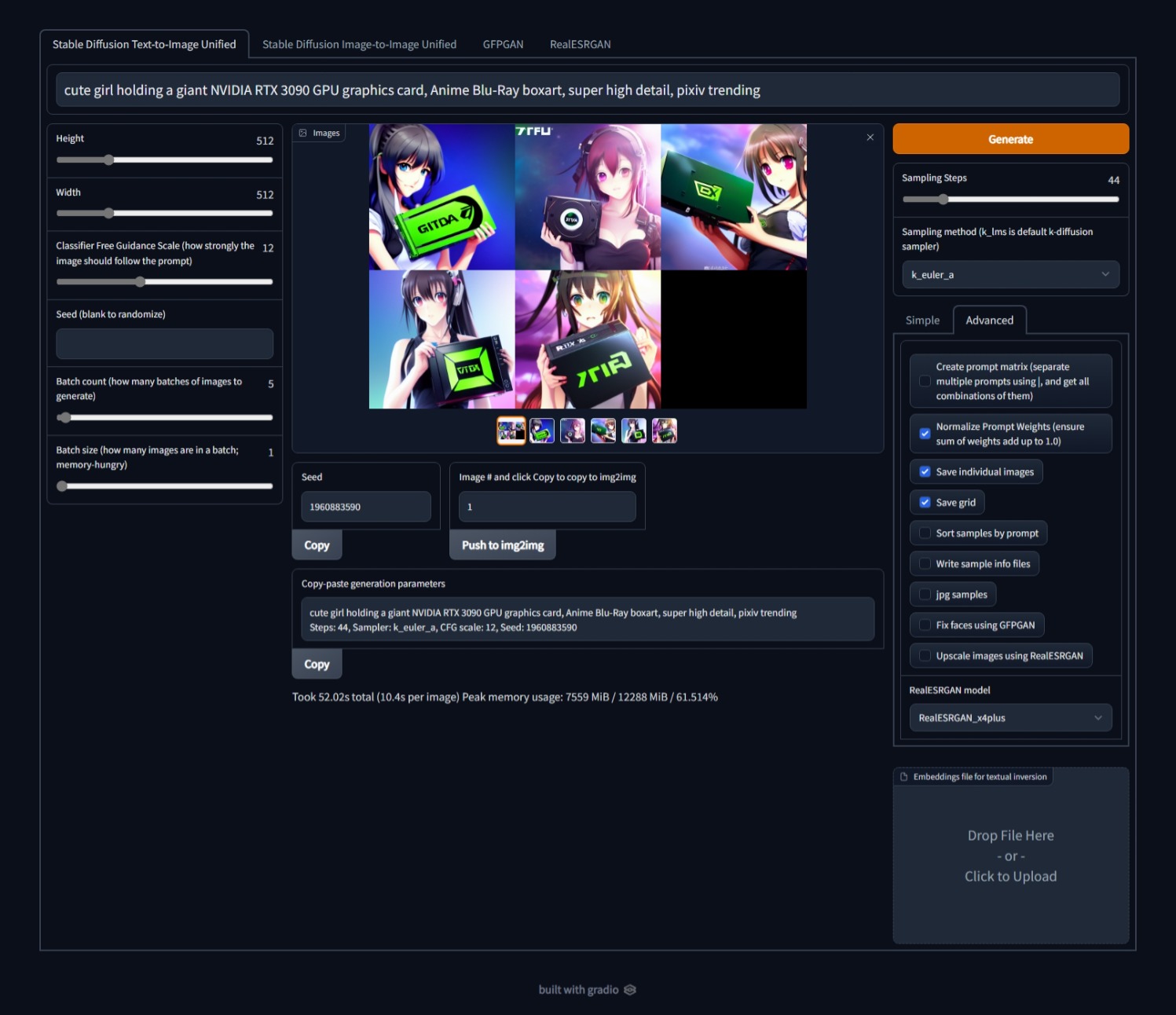

delete ".half()" in webgui.py

(Note: this will raise vram usage drastically)

キミ成人してる?

フィルター解禁版は誰が見ても一発アウトな児ポも画像ファイルとして出てくるから適当に使わんほうがいいぞ >>155

成人してます

ポルノ利用するつもりはないですけど、なんとかして使いたいです .half()ってのを削除しました

成功できるか試してみます

>>155

フィルター解禁版使ってみたいけど

ハードル高過ぎ何をどうしたらいいかわからんw

馬鹿にでもわかるような解説出ないかなぁ 普通に使っててもフィルタかかるから解除版でいいよ

>>154

グリーンはフィルタとは関係なく、GPUが16xxとかだと出るみたいですね。

>>155さんの言うようにwebgui.pyの中にある156行目の.half()を削除してみてはどうでしょうか

(元)model = (model if opt.no_half else model.half()).to(device)

(修正後) model = (model if opt.no_half else model).to(device)

#行頭スペースなど変更せず、.half()だけ削除するよう注意 >>159

ありがとうございます。

今試しています

また別のエラーがでて四苦八苦してます…… やっと生成できると思ってやっても下記のエラーがでます

わかるかたいませんか?

ローカル版で試してます

RuntimeError: CUDA out of memory. Tried to allocate 512.00 MiB (GPU 0; 6.00 GiB total capacity; 5.06 GiB already allocated; 0 bytes free; 5.18 GiB reserved in total by PyTorch) If reserved memory is >> allocated memory try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

>>161

本家はVRAM10GB要るから軽量版に変える >>162

ありがとうございます

やっぱりその問題かー 6GBでも動くはずなんだけど

https://rentry.org/kretard

Lighter on Vram: 512x512 img2img & txt2img tested working on 6gb

16xxはhalf()を止める必要があるから無理ってことぽい。

グリーンスクリーンが16xx限定か知らないけど

後、グリーンスクリーンは、起動時に以下のオプションで解消できると書いてますね。ソースコードいじらなくていいぽいけど

VRAM使用量が上がるから、解像度を低くする必要が有ると書いてる。

"python scripts/webgui.py --precision full --no-half" ゲームとかしないのに化け物みたいなグラボがないと

ダメなのか

つまんないな

多分だけど、2xxxじゃないとGoogle Colabの方が速いぽい >>65

まあ>>163さんはコラボ版のimg2imgも苦戦してるんだけおd プロンプトって単語数の上限や優先順位ってあったりする?

最初の方に置いたら強く影響するとか、数十個以上入れると後半は無視されるとか

単語を詰めまくったら、どうも影響を一切反映しなくなった気がする単語とかあって

単語1個と50個でも生成時間が同じなのも不思議で

単語入れまくったら探査深度というか、画像検索は先っぽで終わる感じなのかな?

例えば1個だと50枚調べるけど50個だと各1枚で終了とか

試行回数少ないからはっきりとは言えないが、構図や描写のクオリティは画像サイズにも依存してるっぽいな

256x256の出力結果は全く使い物にならなかったけど512x512に変えたらハイクオリティになった

単純にサイズに合わせて出力結果を変形させてるわけではないのかも

>>166

どうしてもimg2imgを使いたくて苦戦してますw

今は軽量版をどこで手に入れるのかわからずネットの海を彷徨ってます >>154

緑一色しか出力されない件に遭遇しましたが、--precision fullで回避できる模様です。 >>171

ありがとうございます

やっぱ上限あるんですね…

自分もトークンがなんなのか良くわかってないけど… >>158

HなStableDifusion増田の返信のなかに、1行も変更せず動かせるのがあるよ 複数環境共存できましたということで不親切なメモですが一応。 basjindalは昨日GUIが実装されたようでそこが変わっています。

●basjindalのインストール (waifuの共存)

【前提】 minicondaインストール済

https://github.com/basujindal/stable-diffusion から、code>download zip

miniconda で解凍した場所にcd

environment.yamlの冒頭をname: ldm-basに変更する(waifuと競合するから)

conda env create -f environment.yaml

モデルをコピーしてリネーム stable-diffusion-v1\model.ckpt

conda activate ldm-bas

pip install gradio

これでインストール完了。

python optimizedSD/txt2img_gradio.pyを起動すると、しばらくして

(img2imgなら python optimizedSD/img2img_gradio.py)

Running on local URL: http://127.0.0.1:7860/

でるので、ブラウザでアクセスすれば使えます。

次回からは、以下の2コマンドで利用可能

conda activate ldm-bas

python optimizedSD/txt2img_gradio.py

なお、basujindal、省メモリですがwaifuよりめっちゃ遅いです。basujindal 1.4 it/s、waifu 7.5 it/sぐらいで5倍ぐらい遅い なんか「SDでエロ作るのは危ない!」って騒いでる人いるけど言うほど引っかかりそうな法律とか規約あるか?

「Stable Diffusion Terms of Service」は紛らわしいけど中身読むとAI自体じゃなくてDiscordでやってたbetaの話なんだよな

ローカル環境で考えてるやつは電気代に注意しろよ~

寝る前にコマンド入れて一晩中生成とかやったら大変なことになるぞ☺

ローカル版画像サイズ小さくすればできた

>>169

この軽量版はやってみたけど、うまくいかなかった…… 顔をアニメ風に寄せるのはこれが限界かなぁ

手がもう崩壊してるから脱いだら悲惨なことになる

アニメ顔で実用に耐えるR18とかは一晩かかって出せるかどうか

絵描きだったら自分で描いたほうが早いw

個人的にそういう方向を追求するのは不毛に思うけどな

言われてみれば、>>179めっちゃ可愛く出来てるけど、よく見りゃ左腕豪快に骨折してるね

AI画像生成、人体その他構造を考慮できるようになるのかな・・・ >>175

basujindal版は省メモリに全振りでピーク使用メモリ量が最小になるように

・モデルの分割投入

・混合精度

の2つを積極的に実装してる

モデルの分割投入はメモリの出し入れが激しいので単純に速度が落ちるし

混合精度も使ってるGPUの演算器構成によっては一部極端に演算速度が落ちる型があってネックになることがある

空いたメモリ分で同時生成したり出力解像度を上げることで実質的に多少低下分を取り戻せる >>176

普段使いしているクラウド上にうっかりアップされていたら...とか、Colabで動かしてる時に生成されてGoogleアカウントごとBANとか

児ポまがいの画像が生成されて、何かの拍子に家宅捜索されたときに別件逮捕なんてこともあり得ない話ではない アニメキャラが骨折してるなんて当たり前のことだからなあ

「三次元的に破綻していないドラえもんのイラスト」なんて物理的に存在しえないんだからAIが描こうが人間が描こうが関係ない

ID:OfpVbaR2 がまさに前スレで児ポ生成をやろうとしてたキチガイなんで

一緒に捕まりたくなきゃ触れないことをお勧めする

それ今のAIだと、このキャラでいいから今度は脱がせて!みたいなことが現状できない

まあ一部で研究してるみたいだけどw顔はそのまま、みたいな指定やってるんでしょ

StableDiffusionで素朴な疑問なのですが、conda版とローカル版の明確な違いってなんなのでしょうか?どなたか教えてください…。

一応認識としては、pcスペック関係無しにネット環境必須でGoogle負担のGPUで使用可能なのがconda版。GPUガチャ。

高スペックpc推薦でローカル環境さえ整えればネット環境有り(でGoogle介さず)にpcの内部GPUだけで使用可能になるのがローカル版。ローカルなのでGPUガチャ無し。

Twitterとかでちょこちょこ目にしたのですが、ローカル版ならオフラインで使用することも可能なのですか?

>>189

ColabはGoogleのGPUクラウドサーバーの余りをブラウザ経由で使わせてもらってる

業務用GPUで走るんでそこそこ速いしメモリもある

けれどもGoogleの機嫌一つで使わせてもらえなくなるかもしれない

ローカル版は文字通りローカルで自分が組んだ環境以上のことはできないが好きに使える

モデルデータも落としてくる場合であればインターネットが無くても使える RTX4070でいいかーと思ってたけど勢いで90買うまであるかもしれん

>>186

> アニメキャラが骨折してるなんて当たり前

昔はともかく最近はイラストもアニメも骨折してるようなのはあんまりないと思うw

表現のための3次元的な嘘はあるけど、流石に骨折はぼんやりみてても違和感があるからねえ >>185

別件逮捕ってそれもうSD関係なくないか…

そんなんで特定のサービスに対して「逮捕される可能性が~」とか言われるとそれこそ大丈夫なのかって思っちゃう 顔だけアニメ風が出来ないんだよな

アーティスト名とかアズレン/グラブルみたいな作品名を入れると体にも影響して全体が崩れる

それにヌードとか入れるとやっぱりポルノサイトとかヌーディスト系の画像学習してるらしく

そっちの低品質なデータに引っ張られて顔も残念になりやすい

>>192ありがとうございます。

え、本当にネット環境無しで使えるんですか…うわぁ…

一応ローカル版する為に必要なスペックのpcが最低で20万くらいの額と以前おそわったのですが、img2imgも同様のパソコンで使えるのでしょうか? >>189

conda → Google Colab?

#condaというとローカルPCでPython環境を使うときのcondaとごっちゃになってるのか、Google Colabのそういう呼び方があるのか・・・

起動時間: PC=比較的速い、 Colab=数分以上はかかる

性能: 30x0 , 20x0 > Colab T4 > 1xxxx >>65

VRAM: Colab(15GB)は大抵のコンシューマGPUより多い

ネット: PC=利用時不要、 Colab=必須

使用可能時間: PC=無制限、 Colab=制限あり しばらく使ってないと勝手に切れてまた起動数分待ちがダルい

複数環境お試し: PC=手順面倒かも?、 Colab=簡単

まあローカルGPUが20x0あるならローカル環境を使う、それ以下ならColabを使う

性能はColabを何回か使ってるけど、経験的には特に速くなったり遅くなったりはしてない。

遅いT4、速いT4なんてあるの?って気もする >>187

そういう事を言うやつに限ってガチペド変態野郎

だったりするんだよなぁw もう少し用途に特化したAIが複数あるといいのかな?

人間+背景のみという前提で人間を部位ごとに丁寧にカスタマイズするというのは技術的にはできそうで精度も上がると思うんだけど

M1最適化されたらMacBook Air辺り買うのがコスパはいいんじゃない

>>0198ありがとうございます、こちらも分かりやすいです。

Colabは、Google Colaboratoryのことです。紛らわしくなってしまったみたいで申し訳ないです。

Googleの機嫌で使えなくなるのは痛いので近いうちにローカル版使いたい…

省メモリ版もGUI化で使い易くなったな

お約束のように最初は動かすの面倒くさかったけど

>>202

M1は遅い3060よりも更に3~4倍ぐらい遅いような

まあ消費電力は少ないんだろうし、StableDiffudionとかでまた違ってくるだろうけど

4070を買う理由がまた一つ増えてしまったという事か…

これでまたGPU不足になりそうかね

創作用途だからマイニングと違ってヘイト対象にはならないかもしれないが

省メモリのGUI版に更新したけど表示されたWebページに飛んでも真っ白のまま変わらない

ブラウザ変えてみても同じだった

3.1.7の最新版gradioもインストールしてるんだけどなぁ

>>208

金がもらえるわけじゃないから新作の人気ゲームが出た程度の影響でしょ Chromeで日本語翻訳がONになってるとかない?

省メモリ版はしらんけど、waifu版は、日本語翻訳ONだとimg2imgが真っ白になるし、txt2imgもパラメータ変更不可能になる

>>206 >>208

google colabで無料でできること知れ渡れば

にわかがいちいち何万もするグラボ買うなんてしないだろうし

デスクトップすら持ってない人にはもっと大きな出費になるし杞憂なのでは?

マイニングバブルでのファームが買っていた量って数十万数百万個レベルだぞ こっちではGUI版ちゃんと動いてはいるけどブラウザを開いてると

GPUリソースが大量に消費される謎バグがあって普段使いとは別ブラウザで起動して

すぐにタスクバーにしまわないと駄目だな

>>213

4chanだと、Gradioの動作中アニメーションとプログレスバーのせいでブラウザの表示動作が常時GPUを食うようになって生成速度が落ちると言われてて

対策としてK-lms最新版のwebguiではアニメーション切られた

民間療法としてはその通り最小化するか別のタブに切り替えてアニメーション動作を止めるか

ブラウザのGPUアクセラレーションを切るか

別のマシンから遠隔操作するかだとさ >>211

ブラウザのプライベートモードで実行してもダメだった

原因はわからんけどブラウザからgradioのスクリプトを読み込む時にエラーが起こってたみたい

gradioのissueを参考にして少し修正加えたら一応は動くようにはできた

optimizedSD/txt2img_gradio.py の最後にある

demo.launch() を

demo.launch(share=True) に変更 >>214

あのアニメーション怪しいなとは思っていたけど

何であんなのでリソース食うのか意味不明なバグだなw >>215

share=Trueはまずくないか?

そのオプションはxxxxxx(ランダム数字).gradio.appっていうURLで誰でも外からアクセスできるようにするヤツだぞ >>217

確かにそのリスクはあるね

URLもシンプルだから総当たりすれば余裕で悪用できるし別の方法探したほうがよさげだね すごい周回遅れの質問でごめんなんだけど

ローカル版って公式の設定ファイルいじれば制限解除できるわけじゃなくて

有志のカスタマイズ版をインストールしなきゃいけないって認識でok?

解説とか見ながら普通にローカル環境作っちゃったからローカル版の制限解除にどうしたら移行できるのかわからん

情報量の多い背景の場合は人間の絵師を完全に超えているな

これで人間やアニメ絵がちゃんと描けるようになったら一部の有名人以外は

マジで終わりだね、さっさとそうなって欲しいわ

>>219

自分のやり方合ってるか分からんけどSafecheck回避するだけだから

txt2img.py 1行変えるだけでいけるよ promptに絵描きの名前を入れると破綻が少なくイメージが近い絵が出るんだけど

これは果たして本当にAIオリジナルと言えるのか

>>222

txt2img.pyってファイルがローカル環境内のどこかにあるってこと? >>225

その環境が分からないけど、どこかにはあるのでは。

一応stable-diffusion-mainのscriptsの中にあるよ >>224

作家名や作品名を入れるのが著作権違反になるだろうね 何だかんだでみんな上手くいったプロンプトは隠すから例のサイトもあんま上手くいかないって言う

>>227

環境構築は公開直後の今だけ難しいだけで

そのうちアホでも馬鹿でも使えるようになると思う バズってる整った画像見るとフォトショのゆがみツールとかで直してるんじゃね?とか思ってしまう

>>232

同じ呪文で大量に生成していいやつ選んどるだけやろ 今の段階だとそのまま使うんじゃなくて手直しするほうが効率いいだろうね

イメージ通りの服や道具みたいな構造物を破綻なく生成が難しいから

作品作りに実用するとしたら線画で細部を書いてそれを補助線として活用して

AI塗りを乗っけるみたいな方向だろう

細部の調整は加筆して誘導すればimg2imgでなんとかなりそうではある

ただ、うまくいかない原因がワードにあることも。

illustrationとか入れると全身画の時に顔潰れやすいとか

ワードの組み合わせで解消できるかもしれんけど

人物はだいたいガチャみたいな感じ。たまに元の絵そのものみたいのが出るし

こういうのはアイディアに使えそうだけど

ツィでみたのはもうちょっとデッサンよかった気がするんだが、、難しいな >>199

この話題に限らずお前みたいに痛いところを突かれたからって相手はこういう奴に違いない!みたいな無理矢理な返しをする奴はキモイよ

頭の悪さが露呈してるよ しばらくの間は画像生成+手直し+img2imgでクオリティの高い絵が量産されると思う

エロ微妙じゃね

単に綺麗な高画質裸見せられても抜けないしな

自分の性癖にマッチした絵柄作れんと..

>>243

ここでワーワーやってる人たちはみんな知ってるというか、まさにその話をしてるスレだぞ >>243

CLIP InterrogatorっていうColabのnotebookでしょ

StableDiffusionで使われてるCLIPだけ抜き出して画像から認識されたトークンの固まりを見せてくれる >>43の上から三番目の奴を進めていって最後までガイド通りに勧めたつもりです

IPアドレスみたいなのからブラウザでインターフェースを開けたまでは良かったんですが

仮出力でtext2imgでcatだけ打ち込んでも下の画像のエラーが吐き出されて困ってます。

誰か助けてください。

もしかしてGPUが貧弱だってエラーが出てるんでしょうか? 私のPCのグラボはRTX2060

あとgoogle colaboの時に入力したトークンを このやり方だと入力してないのでそこも怪しいと思ってます。

”ERROR” ?ee; 4.07GiB reserved in total by pyTorch) if reserved memory is >> allocated memory

https://imgur.com/a/Ii4R0jq こういうので二次創作したり作家名入れて生成してるやつ盗作やってるのに近いな

自分で楽しむだけならいいが公開したら盗作と認定して問題ない

>>134

これのやり方全然わからん

pythonなんたら入れるだけいうから、コピペで入れたがエラー

input.jpgをcontentフォルダにstable~フォルダ作ってもダメ syntax errorだから何が悪いかも手がかりないわ

syntax errorって書き間違いとかだから一番簡単では・・

自分で書き換えた部分がおかしいしかありえない

>>252

もしかして私に言ってますか?手がかりがないなら最初からやり直しかなあ >>253

ワードにaaaaとかhappy new yearとか入れただけ

>>254

自分はcolab環境で試してるので colabでのやり方見つけたと(やり方書いてないが)かいうのはググると出てくるからそもそもできないんのかな

>>255

エラーの場所まで<-------みたいなので出るでしょ? >>257

それが出なくてどこでダメか足がかりもない状態 Pythonというかプログラミングが何もわからないまま書いてある通りにcolabで始めて適当に書いてあるコード繋げ合わせて10枚出力できるようになったんだけど、毎回11枚分動いてて最初の1枚は見れない…

>>258

間違った

「^」で直接の場所が出てるはず、例えば

prompt = "A fantasy landscape, trending on artstation"

^

SyntaxError: invalid character in identifier

Pゴシックだからズレてるだろうけど、これは

prompt(半角スペース)=(全角スペース)"A fantasy ...

になってる、(""内はokでも、構文中で全角なんて認められない) 何言ってるのか分からない人いるなとずっと思ってたけど

事前に用意してあるnote bookじゃなくてcolabに手動でインストールしてる人がいるのね

まあWindowPCに入れるよりは大分楽だろうけど手動セットアップは多少は苦労するわな

img2imgも結局は呪文次第なんか。なかなか難しい。

>>248

そうだそうだTips忘れてたわ

GFPGANの300MBぐらいのpthファイルをダウンロードしてきたと思うんだが

これを指定された場所に入れると顔の補正処理が有効になって余計にVRAM食って512x512の画像はVRAM6GBでは出力が無理になるんだわ

削除して立ち上げ直すと通ると思うよ

それでも足りないと言われるならHeightとWidthを512から減らすしかない >>260

どうも入力したワードでなくoptimized_img2img.pyを実行させる構文の表記自体が受け付けられてない

できたできた言っているしよくわからないなこれ もしかして既存のnotebookとかじゃなく自分でcolab上に一から環境作ってるの?

それはさすがにわかんないわ、自分よりはるかに高等

予想しない凄い画像出てくるときと全然駄目なときの落差が激しいな

youngって1単語追加するだけで絵がガタガタになったりしおる

一般的なワードは雑多すぎてだめっぽい

高品質な絵と紐付けられてるワードは安定してる

>>266

若いって一言に言われても色々ある

それこそこれこそが自分が思う若さだ!っていう画像をCLIP Interrogatorに入れてその結果からキーワードを拾うといいのでは >>265

そっちのほうが楽かなあでやってみたけど難しいわこれw 広い意味がある単語だと安定しないぽいね

Hayao Miyazaki new movie poster とかいれたら

ボブネミミッミみたいのが出て笑ったわ

初心者→colabにセットアップ済のnote bookを使用

マニア→colabに手動でセットアップ

PG経験者→自宅PCに環境構築

出来なくはないけど完全初心者が自宅PCに構築するのは面倒だから

まずはnote bookを使おう、リソース制限されても月額1000円でpro使えるし

>>263

ありがとうございます!削除してサイズを256まで落としたらなんとか出力しました。 PCまぁまぁ詳しいけど、絵は練習したが人にお出しできるレベルは描けずタブレットが埃かぶってる

・・・というあるある層が殺到してる気がする、まぁ俺なんだが

CG板とは思えない賑わい

>>272

256はサイズが小さ過ぎて出力が破綻しやすくなると思う

タスクマネージャのGPUのVRAM使用量とにらめっこして、他にVRAM使ってるソフトがあれば終了させた方がいい

0.2GBぐらいがデスクトップだけの状態の標準 公式のreadmeの説明通りにまんまやれば出来た…

騒がせちゃってごめん

>>149 を参考にStable Diffusionを使ってみたけど、「うんまぁこんなもんかな」と言うのが第一印象

作画補助とかモブとか背景には使えるかも知れないけど、引き続き絵の練習はしようと思った >>275

patreonって書いてあるけど有料? 目を引くアニメ塗り+エフェクトみたいなことはできなそうだね

どれも厚塗りっぽくなる

>>275

昭和の火星人くらいはAIの中にいるって感じだなw めちゃくちゃ楽しいな。無限にやっちゃう

絵描けないけど自分だけの作品作れるの最高

ところで解像度もっと高くできないの?生成された画像が小さすぎる

>>281

みんなどういう環境でやってるか知らないけど私はここで指定してるね

image = pipe(prompt, height=512, width=512)["sample"][0] >>278

そのうち正式版はpatreonでパトロンに対してのみ配布すると思う colabだとサイズ大きくするとメモリ足りなくてエラーにならない?

背景として使いたいんだけど吐き出してくるもの全てが情報量多過ぎてこまる。

不細工な顔のついた肉塊ばっかしかできない

ぐぐるたびたび切れるけど何でだろというか今朝作った垢のパスがわかんなくなってログインできなくなったw

>>286

そこらは単語でいくらでも制御できるでしょ

例えばMJだとflat designとか入れたら紙みたいな背景になるよ、SDも似たのあるはず

そこらの単語を調べて順次細かさを上げて行けばいい

・・って言うのは建前で、現状のAIって単純明快な線はめっちゃ下手糞なんだよねぇ

みんなimg2imgで修正してまで回してるのがその証拠

ごちゃごちゃ色つけて装飾するから粗が目立たないって誤魔化しが今の精いっぱい 矛盾の無いように出来るだけ詳細に説明する必要があるな

girlだけだと滅茶苦茶になる

髪の色、年齢、表情、姿勢、背景、動作、服装を整合性の取れるように付けないといけない

それでもイラスト系の単語は体を壊すけど

某氏すげー勢いでフォロワー増えてんな

気持ち良くてやめらんないだろうな

得手不得手はあると思う。こういうデザインは精細で結構カッコイイ

アニメ風になると一気にへぼくなる >>290

それな

もう「自分の絵」上げられなくなりそう なんか粘土ペタペタ貼ってるような作画だし、手直しするにしても線画からやらないと辻褄あわないんが難しい。

カラーラフくらいにはなるけど、色は自分で決めたくなっちゃう。

絵描きの雑感。

>>286

MJなら「--no (非表示させたいもの)」で出したくない要素を制御できるよ 表面質感はほんと凄いよね

ゲームから学習しまくった結果なんだろうけど

特にアメリカ人はリアル系ゴテゴテ大好きだし

MJの--noは優秀

デフォだと、すぐピンクとか青蛍光とか入れてくるので、いろいろぶっこんでるわ

ちな複数は

--no pink,blue,fire

みたいな指定じゃないと動かない

>>297

コメント欄にもあるけど、一部グラフィックカードだと黒い画像しか出ないバグがあるみたい

(Stable Diffusion自体の問題で、本来は実行コマンドを調整して直すところがGUI側にその機能がない) >>275

試してみました。 お手軽!だけどイマイチなので今後に期待

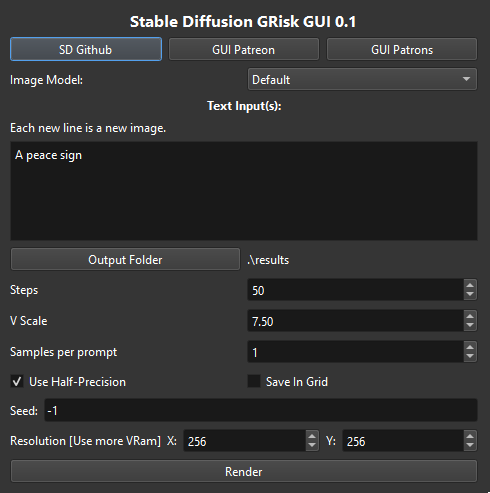

Stable Diffusion GRisk GUI 0.1 https://grisk.itch.io/stable-diffusion-gui

・rarファイルをダウンロードして、展開、Stable Diffusion GRisk GUI.exeを実行するだけで動く

・他のローカル環境と競合しない

・出力は画面上ではなく、フォルダ出力で自動的にプレビューできないので(今のところ)使い勝手はかなりいまいち

・HPに書いているようにSEEDは機能しない。Save In Gridもチェックできない、など開発中

・デフォルトが64x64になっているのでとりあえず動く人は多そう。普通は512x512で使うと思うけど

・私の環境(2080Ti)では、若干遅い。

https://rentry.org/kretard 7.3 it/s

GRisk 5.0 it/s

basujindal 1.4 it/s >>297,298

黒い画像というか、(デフォルトでは)resultsフォルダにPNGが出力されて、そもそも画面に画像プレビュー欄がないような

後txt2imgのみでimg2imgもいまのところない GRiskって人はGitHubに転がってるキーボードポチポチしないと動かない便利そうなソフトを

GUIつけてWindowsで動くようにしたものをPatreonで配って稼いでる人

基本機能装備できたら配布版は更新止まって後はPatreon版に全部乗るようになるからそのつもりで使った方がいい

SDはドラレコに弱すぎる

版権にも弱い

Craiyonだと簡単に出せるものがSDで出せなかったりする

進化の余地があることはわかるんだけどね

>>298

>>300

297だけど1650SUPERで黒画像しか出なくてダメだったわ

このクラスじゃへっぽこなのかレゾ512にしたら止まって動かなかった これは全部AI出力なの?

なんか疑り深くなっていかんな

980tiのCUDA駄目だった人間だけど、微妙~にNVIDIAのドライバver上げたら動いたよ

5日遅れでやっと追いついた

ローカルSDやったけどやっぱ遅いね、さすがVRAMが6GB

512x512のstep50が、1枚で3分半かかる、4枚で7分、5枚で8分

ローカルimg2imgはnonetypeエラーで止まったけど、--Wと--Hしてなかったのが原因だった

デフォでインプットの512x512のままにしてくれるみたいな親切な設計ではなかった

ツイッターの人のコマンド参考にすると文字制限で端折ってるので駄目ね・・

本文に書いてあるけど修正と変換を繰り返してる

修正って言ってもキメラ的な合成に近い

>>305

面白いですね

1点ものイラストならポーズ指定で結構できそう 手でちょこちょこ修正して感じたけど、人物の絵の歪みが定量化されたら簡単にクオリティの高い人物イラストが生成される

生成された絵のうち「歪んだ絵」と「正しい絵」の数値化をすればいいだけだし、時間の問題かも

4000番代でグラボ買い替えようかなとは思ってたけど欲求がさらに高まってきた

メモリ12GB以上のものにせねばならぬ

3090でローカル環境構築してぶん回してるけどだいたい1回の生成が15秒くらいですとりとり

>>311

そのタイプのAIは何年も前からあってあんまり話題にならなかった

今回の拡散モデルは絵のクオリティが全然違うから盛り上がってる 「AIがこれ描いたの!?」系の話題は最初だけだろうし変にこだわらずにガンガン手を入れちゃって良い気もしてきた

AIのべりすともそうだけどだんだんAIに書かせてるのか書かされてるのか分からなくなってくる感じが逆に楽しい

拡散モデルは原理的に実写や細かいディテールのある画像に強くて平坦なアニメ絵に弱いから

それがアニメ用の学習モデルでどれくらい改善するのか気になる

個人的にはもう一段のブレークスルーが必要だと予想してるんだけど

AIの存在はクリエーターの活動に溶けて何がAIで何がAIじゃないのか分からなくなると同時に、既視感のあるデザインやイラストが増えるんじゃないかな

イラストの数が少なくかつ学習の難しい特徴を持つ絵柄だけが個性として生き残っていきそう

凄く単純に言えばノイズを加えた画像から元画像を復元するよう学習させたのがMJやSDの拡散モデル

実写画像はノイズ加えても元の情報が残っているからこの学習が上手くいくけど

殆どが平坦で同じピクセルが並んでるアニメ絵にノイズを加えるとそこにはただのノイズしかなくて情報を持っていない

4chanでの下手な絵を学習してるのが原因では?という説は誤りでアニメ絵を学習出来ないのは原理的な限界

そこを改善できるのか?が注目だよね

>>283

一日2日前くらいに配布されたStableDiffusionが正式版じゃないんですか? 陰影も一種の塗りのパターン化だからそこを詰めてパターン認識の蓄積で行けるんじゃないかなあ

すでにイラストに陰影込みで彩色するのあるけどそのまま転用は無理にしても

拡散モデルと切り離してそれ用に作る方が良さそう

Emadさんのツイート。「生成」じゃなくて、「生成的検索」というのが面白いね。

「分散型&動的な次世代プロトコル」ってのがある程度具体的な話になってるのか、ただのビジョンなのか

@EMostaque

The intelligent internet.

Personalised generative search models for everyone that compress knowledge.

Image, audio, text & more.Distributed & dynamic - a protocol for the next generation.

This is how we build the foundation to activate human potential @StabilityAI

---

知的なインターネット。

知識を圧縮する、すべての人のためのパーソナライズされた生成的検索モデル。

画像、音声、テキスト、その他。分散型&動的な次世代プロトコル。

人間の潜在能力を活性化させる基盤はこうして作られる @StabilityAI

>>319

「Stable Diffusion GRisk GUI 0.1」の正式版ってことですね

ベース(ソースコード、モデル)は公式の正式版そのものだけど、

GUIを付けて簡単に実行できるようにしたGRiskの正式版、ってことね >>318

なるほど、だからアニメ用モデルを別にリリースしますみたいな話になるのね

勉強になる

それはそれとしてデッサンが崩れてるヘタクソな絵が出てくると元データのせいでは?って思いたくなるw 写実的なイラストを描いてるタイプのイラストレーターをpromptに入れると絵柄が安定するけど、平面的な絵のイラストレーターだと不安定なのはそのせいか

>>326

公式のcolab前からあったような?と思ったらこれ、新しいAPIのデモですね。

DreamStudioのメンバーシップないとAPI KEYがなくて使えない アニメ用モデルならwaifulabやmakegirlsの例があるし頑張れば出来るんじゃないか

頑張ってSDをローカルに入れたけど500×250ぐらいの出力が限界で全然綺麗じゃないわ

うーん流石にPC買い替えしたくなる

>>330

自分も同じ

軽量版でないかとずっと待っている waifulabやmakegirlsは本物/偽物を見破るAIとこの判定を突破するAIの対決による

相互学習でそれらしい絵を出す学習モデルでアニメ絵には向いてるんだよね

顔潰れないようにワード詰め込むと、なかなか立ち絵になってくれない

ただ、有名人入れなくてもキレイな顔出るようになってきた

ワード選びのバランスが難しい

アニメ解説

windowsが古くて260文字以上に未対応(レジストリもポリシーも不可)

img2imgで呪文入れまくるとフォルダが作れないという情けない状態

pythonわからないのでどう変更したらいいものか・・

os.makedirs(opt.outdir, exist_ok=True)

outpath = opt.outdir

sample_path = os.path.join(outpath, "_".join(opt.prompt.split())[:255])

このあたりだとは思うんだが、255減らしても駄目だった

つかそんなフォルダ名にするなよ・・

>>334

色ピックアップしながら自分で描いた方が早いような・・(爆弾発言) >>335

sample_path = os.path.join(outpath, "sample")

こんなんでOK 当たり前だけど自分の好きな女優の画像を元に描かせるのが一番自分の好みに近い

プロンプトをフォルダ名にするのって後からでもプロンプト分かるから結構便利なんだよな

windowsのフォルダ名制限が厳し過ぎるのがいかんわ

どうせ物理的なアドレスと何も関係ないラベルなのに何で制限あるねんっていう

imagetoimageをgoogleのcolabで使いたいんだがやり方まとめられた日本語のサイトってある?

翻訳かけながら色々やったけどうまく行かなかった…

>>43 の最初の方のcolab (img2imgできる方)は今は動かない気がする

なんか特殊な手順とかあるのかもしれないけど

どっかに動くimg2imgのColabないかな >>329

遅い上に高い

月千円プランでAIに食わせるのに使われるのがせいぜいだろこんなん Crypkoみたいに没個性過ぎると沢山いる絵描きにAIさんという1人の新人絵師が加わりました

って感じになるだけだから特に何もインパクトはなく数年が経過しちゃったんだよね

MJやSDはあらゆる画風を出せるってのがこれまでになくてこりゃやばいってなった

既に実写系なら特定のアーティストの画風パクれるもんな、、、Wlopとか人気過ぎだろみたいな

エロ絵作りたいんだけど現状だと何をやればいいんでしょうか?

エロ絵作りたいんだけど現状だと何をやればいいんでしょうか?

>>350

昨日時点は、だけどpytorch undefinedとかになって動かないはず

https://boards.4channel.org/g/thread/88284357#p88285430

female pope, big tits, highly detailed, intricate, magic the gathering, d&d, award winning, top rated, skinny, fantasy, oil on canvas

以下も入れたかな

dark, gloomy, desaturated, greg rutkowski

https://boards.4channel.org/g/thread/88284357#p88285554

beautiful handsって入れろよ

https://boards.4channel.org/g/thread/88284357#p88285665 >>331

同士いた~ 風呂入って考えたけど、PC買い替えるよりGOOGLE COLABOの月1000円コース申し込んだ方が

なんかあったとき融通効きそうでこっちを前向きに考えてます。 >>242

ID:OfpVbaR2

ちゃんと文章見えてるか?まさに俺が指摘した通りの返しになってんじゃん?

自己紹介して自滅してループして死ぬだけの虚しい人生お疲れ >>343も一理あるので

def left(text, n):

return text[:n]

・・・

sample_path = left(os.path.join(outpath, "_".join(opt.prompt.split())[:255]),150)

にしたよ、頭から150文字取る

たぶん本来は255の方でなんかするんだろうけど、動いてるからいいや >>355

ガチペド変態野郎

図星だったねwwww

わかりやすっ これも他のAI系ソフトみたいにTensorコアが使えるGPUの方が速かったりするんだろうか

なんだろう、I2IはMJと違って苦痛しかない

MJの--betaで遊びたい・・はよ復活して

basujindal版って最初からcheck_safetyが消されてるんだな。

grepして無いなあと思ってたがCompVisのtxt2img.pyとdiff取ったらcheck_safetyの部分がスパッと削除されてたわ。

>>359

サンクス

まさか2060が1080Tiの2倍も速いとは GOOGLE COLABO で実在なら一発BANの裸の幼女画像とか生成されたらと思うと怖くない?

一日ごとにエロ絵のクオリティが上がってるのはいいが、正気に戻ったときが辛そうで辛い。

>>65

何気にこのプロンプトかっちょいいな・・

>>366

これすげえよな

img2imgに完全に残す部分のマスク自由選択機能と

弱いimg2imgを段階的にかけていくフローが搭載されてる

世界最強に近いフロントエンド >>366

このスピード感よ…乗るしかないこのビッグウェーブに >>366

もうステップ3は飛ばして大丈夫だわ

レポのほうで対応してる >>366

インストール中

>>371

> 綺麗な出力が欲しいってだけならgreg rutkowskiほぼ一択

みんな入れてるよね

検索してもD&Dのドラゴンみたいな画像しか出ないからなんでかなぁって思ってた 呪文の単語数や文字数の上限があるらしいのですが具体的な文字数単語数ってわかりますでしょうか

>>379

証明書とか入れてないしhttpでしょ

あとこのガイド

conda env create -f environment.yaml

を飛ばしちゃってない? >>370

google で見れば自動で翻訳してくれるからだいたいわかるよ >>381

Cromeで見ればgoogleが自動翻訳してくれると言ったほうがいいかな > If your conda installation is somewhere that isn't \Programdata\miniconda3, adjust the path in webui.cmd accordingly

おま環だった

>>380

ありがとう、httpだった・・キター!

> あとこのガイド

> conda env create -f environment.yaml

> を飛ばしちゃってない?

webui.cmdでバッチ化した模様 しかしやりたいのは向こうにとってはペドの日本人的若い女の子のえろだけどメモリ2GBではどうしようもないから数年後かなあ

というか基本の部分蓄積できてからのほうがよさそうだ

数十年後

「AI国際連盟はAI創作の発展に図らずも寄与したとして

Greg Rutkowski氏に貢献賞とゲーミングPC「ガレリア」(提供ドスパラ)を贈呈しました」

Greg Rutkowski氏「びっくりです。勝手に名前を使われ創作という名のパクリに利用されていたら賞を貰えました」

自分で作り上げたロリショタデータでハードコアポルノ動画とか

作れるようになったらAI 規制法とか出来るんだろうなぁ

Greg RutkowskiのGreg RutkowskiによるGreg Rutkowskiのための絵

[]でワード強くできるのか

他のワードでも強調できるといいことあるかも

>>392

さっき俺も試してたんだけど全然別のイラストが出てくることもあるから

記号いれるなり繰り返すなりでPromptが変わる=出力結果が変わる中で

たまたま好みのが出てきただけでしかないと思う >>397

prompt

actress, teen, blue eyes, dark hair, pale skin, intricate, top rated, highly detailed, illustrated by Greg Rutkowski | by Greg Rutkowski | by Greg Rutkowski, by Greg Rutkowski

Steps: 250, Sampler: k_lms, CFG scale: 4.5, Seed: 1540371425, Prompt Matrix Mode.

デフォ:actress, teen, blue eyes, dark hair, pale skin, intricate, top rated, highly detailed, illustrated by Greg Rutkowski

V1:actress, teen, blue eyes, dark hair, pale skin, intricate, top rated, highly detailed, illustrated by Greg Rutkowski , by Greg Rutkowski

V2:actress, teen, blue eyes, dark hair, pale skin, intricate, top rated, highly detailed, illustrated by Greg Rutkowski , by Greg Rutkowski, by Greg Rutkowski

V3:actress, teen, blue eyes, dark hair, pale skin, intricate, top rated, highly detailed, illustrated by Greg Rutkowski , by Greg Rutkowski , by Greg Rutkowski, by Greg Rutkowski 街歩いてたら看板の字がバグってて異世界に行ってしまった系の都市伝説みたいな写真描けるので楽しい。

>>366

GUItardの新機能抜粋 https://rentry.org/GUItard

・設定が手順が楽になった

★マスクペインティング: 画像の変更したい特定の部分のみを再生成するための強力なツール

・ループバック: 最後に生成されたサンプルを自動的にimg2imgにフィードバックする。

・Prompt Weighting (NEW):プロンプトの重み付け。プロンプト内の異なる用語の強さを調整

・サンプラーが増えた

・k_euler_aとk_dpm_2_aサンプラーは、同じシードとプロンプトから、非常に異なる、より複雑な結果をもたらします

・他のサンプラーとは異なり、k_euler_aは低いステップから高品質の結果を生成できます。50 ではなく 10 で試してみてください

---

マスクペインティングのやり方分かる人いますか?

アルファ消去するとそこ補完してくれるのかな?とか思ったけどうまくいかない(消した部分がそのまま黒くなる)

beautiful short bob haired anime girl, water dress, portrait, water splash everywhere,

highly detailed, digital painting, artstation, concept art, smooth, sharp focus, illustration, art by Shunya Yamashita. beautifulが効果ないってなんとなく思ってたよ

kawaiiを入れると露骨に目が大きくなるね

美しいポートレートはちょいちょい生成できるようになってきたが

シチュエーションころうと思い始めると途端に難しくなるな

海外ではおばさんとかにもbeautiful ladyとか普通に言うから

もうただの挨拶みたいになってるんだよな

512x512生成のざっくり性能。少し更新

it/s = 1秒で何ステップ実行できるか。(例) 50 stepで1080Tiの場合、50step / 2.3 it/s = 21.7秒かかる

16xx(6GB) --- 512x512では動作しない ※

980ti(6GB) 0.36 it/s (2.81 s/it)

1070Ti(8GB) 1.60 it/s

1080Ti(11GB) 2.30 it/s

Google Colab(T4) 3.2 it/s ~ 3.8 it/s

3060 3.5 it/s

2060 4.6 it/s

3070 6.3 it/s

2080Ti 7.3 it/s ~ 7.73 it/s

3090 10.8 it/s

注 16xxは6GBメモリだが、出力がグリーンスクリーンになる問題があり、full精度にしないと動かない。

そのためVRAM消費量が増え、512x512では動作しない。解像度を下げる必要あり。

>>412

Colabは選定が大変そうだがWebサービスのまとめはちょっと試したい人用に便利そうだな もうすぐこれらの3D生成版が出来るってマジ?!

objやFBXを一瞬で作ってくれるの?!

greg rutkowski凄すぎワロタw

イメージボードこれでいいと思えちゃうくらいスゲーな

>>414

3D用のA学習Iモデルをリリースする予定ってツイートがあったのは確かだけど、

(1) 画像・テキストペアデータは50億のデータデータセット(LAION)があったけど、3Dモデルが何十億もころがってるわけない

(2) CLIP(画像と言語の対応関係をWEB学習)+DDIM(ノイズ付与+復元学習による高精度化)は使えないので全く別のAIになるはず

なので、何がどの程度できるものなのかは全然分からないね

画像よりははるかにハードルが高いのは確かでどうなることやら stablediffusion のFigmaプラグインが準備中

パスとプロンプトやキーワードを入力後それに合わせた画像を生成

進化してるね

音声の生成がすごい気になる

声優の声学習させてリアルタイムで変換できたりするんかな

スクリーントーンが最初出てきた時も「人間のかけ網と比べたら月とスッポン」って言われたけど結局普及したよね

AIもそうなるよ

>>416

めっちゃ素人考えだけど、今のMidjourneyもStableDiffusionも、学習時点で

「これは笑ってこちらを見ているエマ・ワトソン(美人)(緑の服)のイメージ」と画像をテキスト情報に判別してから学習している

(ファイル名とか画像についてるタグだけ見てるわけじゃない)

ならポーズ判別して学習してもいいはずで、ポーズが確定するならそこから3Dモデル+テクスチャにすることもできそう?

いや服はかなり難しいか・・・。ポーズだけじゃなく服の形状理解しないといけないからそれは流石に無理っぽい

まあ妄想の域を出ないから今の技術の使い方を考えつつ待つしか無い

ちょっと調べた感じ、MidjourneyやStableDiffusionの技術は最新ではないのでもっとスゲーのがMicrosoftあたりから出そうな気もする

>>418

来月リリースされる"audio"モデルってなんだろうね

雨、衝撃音、みたいなサウンド、音楽、人の声とか色々あるけど 動画作ってると効果音がすごく困る。フリーサイトでは全然思ったものがないし

そういうことが減るといいけどなぁ

>>416

フリーデータ収集タイプだと時間かかりそうだなぁ…

著作権的にもクリアなAIが一から生成するタイプになってくれたらありがたい…

ある物体の各方向の画像から3Dデータを作って、それを原本的に使うとか…

よくわからんけど… AIが学習の為にASMR音声を収集し始めるのか…出来上がりが楽しみだな!

基本的な事を聞くようで申し訳ないけどAIの画像生成ってプロシージャルとは違うの?

自分の手元に出てきた画像が既存の絵や他人の画像生成と同じになる可能性はほぼゼロ?

グレッグさんおなしゃしやす、って感じでぶん回してるが

なかなかぐっとくるのは出にくい

でも本人に描いてもらってる感じに近いな >>426

めっちゃ完成度高くていいな

greg rutkowski でググるともっと激しいタッチの絵がいっぱいでこの絵とは似てないけどなんでこうなるんだろうw >>429

自然言語じゃなくて、決められたタグで生成するのね

使用感としては生成するというより、単に画像検索してるだけな感じであまり面白くはない

いくつか見た感じ、顔も体の構造も壊れたものが少ない

(足が割れてたり、顔半分が潰れてたり、乳首が3つあったりするものが稀にあるけど)

人体が破綻しないようなAIを使ってるのか、人力で画像選別してるのかどうなんだろう >>425

言葉のイメージとしてプロシージャル生成は、髪型はパターン2、目はパターン4、口元はパターン3で顔を組立てる、みたいな感じがある 君らどうせエロいデータセットたくさんもってるんだからソレ集めてマネタイズしなよ

Greg Rutkowski に lolita 入れると結構かわいくなるかも

もろおっぱいなんてヤボですよ >>426

サムライとかニンジャが活躍するアメコミに出てきそう。可愛い。 検索するとセーラー服おじさんもDALLに熱中してるみたい

AIでもなかなかあの姿は生成できないだろうに

>>436

自分なりに呪文を覚えていけばグニャらなくなる程度はすぐだよ。 人物の手足グニャグニャは現時点では以下のように

指定画像から画像を生成するのが一番かなーと思う

でも手の指はむずかしい

#stablediffusion の #Img2Img (指定画像から画像を生成する)機能を使ってみました。

3分で描いた指示用雑絵(2枚目)に絵の要素のプロンプトを指示し1枚目を生成しました。

2枚とも生成時・指示時のもので、無編集。

>>305の人がそこらは詳しくレポしてくれてたんだけど、消されちゃってる

手修正交えてi2iで回してたけど、とにかく上手くいってない感じだった 来月リリースする"audio"ってなんだろうと思ってたけど、githubに作業中の項目書いてるね

1つ目は声を高くしたり低くしたいみたいな音声変換?(よくわからん)

2つ目はtxt2imgに、既存のGLIDEも使えるようにするってこと? >>427の絵を見るとtext encoderがclipからtransformerになる?

3つ目はテキストから音声読み上げ(TTS)、文字から音を生成?

https://github.com/huggingface/diffusers

A few pipeline components are already being worked on, namely:

1. BDDMPipeline for spectrogram-to-sound vocoding

2. GLIDEPipeline to support OpenAI's GLIDE model

3. Grad-TTS for text to audio generation / conditional audio generation

個人的に結構当たりっぽいやつ

キャラデザインとしては優秀だなぁ Colabに構築したシステムに書き込んでるプロンプト情報や出力情報も、やっぱ本家に収集されてる?…

それならちょっと恥ずかしくなってきた(´-`)……

>>443

そんな器用な機能はないから欲望のまま好きなワード書けばいいよw >>445

そうだったの?!!!!

「エロい絵っぽいから黒塗りしとく」って言われたんで完全に監視されてるんだと思って一時間前から一切作るのやめてた!

海の向こうの人間たちに「こいつさっきからキモい絵ばっか作ってんな」「こいつの個人情報全世界に公開してやろうぜ」

って流れになってんじゃないかと思ってビクビクしてた…

収集されてないなら胸を張って作れる(´-`)! >>441

BDDMPipeline スペクトログラム(周波数と時間軸で音の成分を表現した画像)から実際に音を作る仕組み

→前段に「欲しい音のスペクトログラム画像を作るAI」が居れば音が作れるという下ごしらえ

GLIDEPipeline プロンプトへの忠実性としては世界最高峰と言える画像生成手法GLIDEをオープン実装する

Grad-TTS まだGANが主流で前時代的となったText To Speech(文章を読ませる音声合成)にdiffusionを導入する AI画像コミュニティで #stablediffusionの #Img2Imgに3Dモデルを指示画像使用している人がいたのでクリスタの3Dでポーズ取り、目だけ描き込み→生成

設定補正小(2枚目) 補正中(3枚目) 補正大(4枚目)

指示文に髪・服・装飾などの情報は入れてない

指示絵が描けなくても3D人形使えれば絵になる

参考で >>447

ありがと!

なるほど1番目はエンドユーザーが直接使うものではなさそうですね

来月でる"audio"モデルというのは、BDDMPipelineなのか、Grad-TTSなのか。 後者なら遊べそうなので期待 pixiv kawaii digital artでかわいい絵の命中率上がってた気がしたけど、もっといい呪文あったんだ…感動的

某所ではミュシャと水木しげるを同時召喚することで絵柄の癖を相殺して安定した顔を生み出す呪文が開発されたと聞く

いよいよもって黒魔術あるいは一周回ってサイバーパンクじみてきて面白い

後ろの方にKyoto Animationを入れると少しだけ絵が柔らかくなる

後ろの方にtrending on artstationでさらにイラストっぽくなるがこっちは壊れやすさも増す

anime.pixivは破壊力が強すぎて使っちゃダメ

>>440

モザイク処理を追加して先程再公開しました 普通に25yo girl in akihabara, sweet lolita fashion とかで可愛い女の子出るよね

変な呪文唱える必要ないよ

人の頭が上下に二つ串団子状態になりがちなのはなんなん

えっちなかんじするやつ

>>460

ごめんフォークってどういう意味なん?

煽りとかじゃなくてホンマに知らない 気が向いたら教えて 学習元のデータセットのLION-5Bの58億5千万枚の画像には世界中から無差別に収集したアウトなのが大量に含まれてるのに

それをネットで公開して世界中にバラ撒いても許されるってのが規制の厳しい日本じゃ考えられんな

法律無視して単純所持で逮捕されるような画像を勝手に大量収集しても許されるグーグルみたいな特権的巨大企業しか

AIって無理じゃね?って想定が一気に崩されて世界が変わった

>>467

それは真逆で機械学習のデータについては日本は無法地帯ってレベルで緩いよ

まあアレクサとか盗聴器を家庭に設置するようなことはできてないけど、法律規制の問題じゃない こういうのを何か柔らかい雰囲気で作りたいけどなんかいい案ある?

>>434

メモリ少なすぎるだけでは

手元のMacメモリ64GBで1分ちょいだった

とはいえCPUで無理くり動かしてるだけだからMetal最適化待ちだな およそこの世界のありとあらゆる画像データ公開されちゃったから

AIの技術革新が進めばおよそ何でもできるようになっていくんだろうな

パンドラの箱が開かれた感じ

元々の仕組みからすればもっと分割してレンダリングするとか

少メモリで高解像度いけるようになるよねぇ

そうなったらもっと遊べると思うんだよなー

解像度上がるだけで細部潰れるのとか解決しそうなんだよね

img2imgは現状だと落書きをマシにするにはいいけど元データの品質がある程度高いと劣化にしかならないね

クリスタの3D人形レベルならいいけどMMDで出力したキャラですら劣化するから3Dでいいなと

逆に背景は3Dでは処理が重くて厳しい高層ビルから見下ろした風景とかを上手くやれば出せるから有用度高いね

>>366

質問です

これ手順通りにやったんだけど

6GMあるのにグリーンスクリーンになります

それで下記の通り説明されてたんだけど……

グリーンスクリーンの修正:

次のパラメーターを使用して webui.cmd を編集します:

" python "%CD%"\scripts\webui.py --precision full --no-half"

(注: これにより vram の使用率が大幅に上昇します)、解像度を下げる必要がある場合があります。

このパラメーターの使用方法がわかりません……

わかる方教えてください こういうAIでエロ画像作って公開したら、日本だとタイーホ?

現状でもストーリーや文脈のないキレイなだけのイラストはAIガチャだけで生成されるからこれから様々なメディアに大量に投稿されるかも。それも今の数十、数百倍

AIを用いたイラストを使ってるってだけで毛嫌いされる時期が訪れるかもしれん

正直今のレベルならキャラは3Dソフトのほうが全然いいけど権利問題を誤魔化せるって利点があるんだよね

イリュージョンの3Dを下絵にして大ヒットして億単位の売り上げ出した某同人ゲームが著作権で叩かれて

販売停止された事件があったみたいにずっと絵の省力化には著作権問題が付きまとってきた

メーカー側が著作権フリー宣言してるソフトでも今度はユーザー製のMOD使ってるとやっぱり袋叩きでみんな委縮

AIは世間が理解できなくて許される雰囲気あるから一度誰かが先行して商業OKな実績出来たら雪崩を打って使われ出すと思う

>>480

一部AIを使ったゲームとかCG集ってハッキリとAIが書いたって証拠なくない?

権利がそもそも主張できない >>477

「scripts」フォルダのなかの「relauncher.py」ってファイルの

os.system("python scripts/webui.py")

って行を

os.system("python scripts/webui.py --precision full --no-half")

にすればいい >>482

これまでは法律も証拠も関係なく似ているというだけで叩かれてアウトだった

髪型が似ているとか似たような構図が特定の作品との間で多いというだけで差し替えや販売停止

それに比べてAIだと多分画風丸パクリでも許される流れになってきてる >>477

書いている通りですが、

webui.cmd というファイルがあると思うので、それを編集して以下の行を書き換えればいいと思います。

python "%CD%"\scripts\webui.py

↓

python "%CD%"\scripts\webui.py --precision full --no-half

多分Geforce 16xxだと思いますが、解像度を下げる必要があり正直実用的じゃない気がします。

Google Colabを使ったほうが良さそう colabは導入簡単で良いね

ただこれで触ると楽しいからもっと良い環境で使いたくなる

>>486 は無視してください。何も考えず英文のままレスしましたが、多分>>483の方が正しいです。 >>475

ノートをこんな素から書く人いなくないw

勉強したいならいいけど img2imgに写真食わせて背景作ると初心者が写真トレスしたときにありがちな

間違いとか誤魔化し多発するから絵を描く人にはやっぱり一発で分かるね

描かない人はそこまで気にならないだろうけど有名絵師の写真トレスとかも

同業者は叩かないだけで全然バレバレだからね

叩く叩かないとかイラレ業界のキモい常識押し付けてくんなよ...

GUI版で重くなるのあのアニメーションが原因じゃないな

別ブラウザでもとにかくjavascriptでアニメするようなページ開いてると同じことになるわ

前スレから沸いてるペドガイジ↓一応自分が馬鹿という自覚はあるらしいね

158名無しさん@お腹いっぱい。2022/08/25(木) 05:53:26.27ID:OfpVbaR2

>>155

フィルター解禁版使ってみたいけど

ハードル高過ぎ何をどうしたらいいかわからんw

馬鹿にでもわかるような解説出ないかなぁ >>496

GPUカツカツ + ハードウェアアクセラレーションが有効になっててグラボが対応できないとか いったんアニメ絵は忘れてまず基準になるようなフォトリアルな

現実そのものの服装出せるプロンプトってどんなんなんだろ

例えば学生服とかで

>>488

>>483

お礼言うの忘れてたんでありがとうございます。

できはしたんですけど

重たすぎてすぐ固まってしまい

自分の環境じゃ厳しかったです >>500

最終手段はそうします……

すでに昨日別件で4chで聞きました…… >>499

そこはインストール先決めてるだけだから

マウントされた/content/drive以下の好きなフォルダを指定するだけだよ

あとこの設定だとグーグルドライブに出力した画像が保存されるから

アウト画像生成すると通報されるぞ 元画像の人物に髪を消してとか服を脱がせてとか出来たらエロが捗るんだがな

>>499

これはモデルを既に自分のGDriveに保存している場合、それを使うという設定で、他の方法でダウンロードしているなら実行不要です。

上にある以下の2つのどちらかを実行すればOK。その下のHuggingfaceも不要です。

!gdown

%cd stable-diffusion >>510

モデルがないってエラーだから>>507のモデルをダウンロードしてないか、ノートのバグかどっちかでは

ただモデルダウンロードしても、俺はそのノートブックが動かせたこと無い(他のノートは問題なく動く)ので詳しいことは動かせた人に聞くしか・・・

後動かしてるのがOptimizedSDだけど、それめっちゃ遅いから止めた方がいい

みたいなこともあってそのノート俺は嫌い >>511

そうなんですね……

なんとか自分のPCでもImage 2 Imageを動かしたくて調べてます……

ただ素人なんで苦戦してますが……

おすすめのノートあれば教え欲しいです 4chanのcolabでimg2imgできるらしいけど

3DCGのtエクスチャ用途にバリバリハマってるわ…

これ2048+2048とかできんのか??

512じゃ解像度たらんのよー

>>515

>>342

テクスチャといえばこのシームレステクスチャも便利そうね。試してないけど

解像度は3090(24GB)でも896x896が限界らしい

メモリ最適化版なら多分もっと行けると思うけど 偉い人に期待して待つわw

adobeかどっかが買収しちゃう気もするけどw

キャラがへなちょこと不気味の谷を超えて可愛くなり、おっぱいも見飽きた今、いったい何をするべきか。

ひたすら無駄な詠唱を削るためにwebuiのマトリックス機能でテストするといい

その分他の属性にリソースを割くことができる

>>512

これはキャラも背景も一定してないから、ベースのアニメをimg2imgでインプットして同じプロンプトで画像生成してるだけな気がする。

一定しないのを演出風に見せてるだけで >>521

おもろい

実写か手描き?の連番をimg2imgて感じやな

やっぱ道具は使いようってことか 生成できた絵で上手くいったやつ上げてほしい

手直しなしの状態で

k_euler_aサンプラーすごいな

説明書き通り20stepぐらいで収束する

けどk_lmsと違う絵になるのが玉に瑕

破綻するわけじゃないからプロンプトとの相性次第か

サンプラーの違いは、 https://rentry.org/GUItard の一番下に分かり易いのあるけど

k_euler_a、k_dpm_2_aが独自の進化するような感じ

k_euler_aは、サンプル数増やすと正常進化じゃなくて、変異が大きく見える

この例が一般的な傾向になってるか分からないけど つーかこれが限界

あのAIアートの人はどうやってるのかね

あんなにアニメ顔安定しないのよ

>>534

固定すると毎回同じ画像が生成される

値を変えれば新しい画像が生成される >>533

すげえなこれ

ある程度複雑なポーズとかはi2iじゃないと難しいかな >>535

852なら目は手描きでしょ

かなり前から自分で言ってる、最近はなぜかツイート省いてるが >>535

ただ数出して当たったやつをだしてるだけだよ

多少安定はするけどあのレベルがいっぱい出てくるのは無理 Colab構築版img2imgはjpg保存の選択とか出来ないのかな

リアル系画像だとデフォルトpngよりデータサイズが数倍大きくなっちゃって大量作成すると一日で合計1GB超えちゃう…

>>538

質問がわかりにくいねw

GUItardならランダムシードの結果のシードがいくつか出る

ファイル名がシード値になってたりするけど、どのツール使ってるかで違うね >>541

img2imgできるColabぜひ教えてほしいです >>538

なんちゅうか「そういうAIだから」と言われればそれまでだが

画風の振れ幅がすごいな

>>539

あいつの場合絵師だから、ほぼ全部自分で描いて

「AIが一発で描きました!ヤバイヤバイ!」ってやろうと思えばできるんだよな >>539

あれ加筆してるの過去のだけじゃないのか…

ええ、なんじゃそりゃ…詐欺られた気分だ… AI絵を自分の絵って詐欺、の逆かw

教えてもらったほうが参考になるっちゃなるけど、まあいいんじゃないの

>>537

テキストだとポーズは諦めた方が早いと思う

腕とか足制御してそこから顔が当たるのお祈りするよりportrait paintingで胸から下バッサリ捨てた方がまだ当たりやすい気がする

手を出すと数とか形もぐにゃぐにゃのままだしね >>548

そこはやっぱりそうなのか

なんかAIの得手不得手が人間のそれとあまりに違いすぎて混乱するな >>539

やっぱりそうだよね

というか目の描き方が本人のイラストと同じだもん pixivの古い絵辿ればわかるけど

もともと写真加工背景によくある萌えキャラ絵を色合わせして描いてた人なんで水を得た魚状態

AI背景生成とは運命的な出会いだろう

本人にしてみれば、昔からやってたからここまでできるんだ=バズったしもう断り要らなくね?

みたいな、よくわからない増長があるんだろうな

980tiだが、>>366がなぜか512x448以下じゃないと動かない、直打ちのOptimizedSDは問題なかったのに

全然動かないよりはマシだけどモヤモヤする、ほんのちょっとどこかから持ってこれんものか・・ >>555

GFPGANは使う気がないなら入れてはいけない

入れると読み込まれてVRAMを余計に消費する >>556

ありがとう、でもまだ入れてない

あとimg2imgでできた画像が微妙に拡大されてるのが嫌だ、なぜ100%で表示しないのか

くわえてCopy selected image to inputが滅茶苦茶時間かかるのが謎

元にコピーするだけなのになぜ「drawing」?生成したのをD&Dしたら一瞬 これって作成した画像を商用で使う時もMITライセンスの規定通り

Copyright (c)2022〇〇

Released under the MIT license

リンクアドレス

みたいにする必要あるの?

それともソフトウェアを再配布や販売した時だけ?

craiyon元にimg2imgで変なのしか出なくてつまらんと思ってたけど、自分で描いた>>439下みたいな単色付き雑絵元に

新海とかgreg rutkowski とか入った呪文で、strength0.5、step50の5つくらいバッチで回したらいきなり面白くなってきた

これほんと革命だわ・・

craiyon出力のごちゃついた絵じゃなく、ほんと単純な線こそいい Pythonコマンドから実行がなんとなくゴテゴテしてなくて最速だと思ってたけど

WebUI版の方が読み込み済みプロセス流用で1回生成あたりは早くなるのね

本家 35秒

basujindal版(CUI) 64秒

hlky版(GUItard) 13秒

あからさまに誰かのtwitterアカウントの痕跡が出て笑った

>>559

「マイドライブに入れてる」というかそのエラーのパスにないんでしょ これ複数GPUに対応してるのかな?対応してるなら2枚差しでやってみたい

>>562

たまに有料写真らしき斜線も出る時あるよ プロンプトの区切り方に決まりや強調方法はあるのでしょうか?

小文字のカンマ「,」が基本だと思うのですが、ピリオド「.」でも問題なしですか?

[] () のカッコ類でも強調されたり逆に弱くなったりという話がありましたが、結局あれは効果変わらずでしょうか?

他者のプロンプトを見ると!!!A!!!というビックリマークで区切っている人を見かけたのですが、強調効果があったりするのでしょうか?

SDの背景絵見慣れ過ぎて人間の絵描きが描く背景がヘタクソに見えるようになってしまった

キャラもいずれはそうなるんだろうな

>>570

実験した人が居て

「影響はあるがどれが良いかは分からない」というのが結果

カンマとピリオドでは違うし、他の区切りに使うような文字を使っても違う

けれどもどれがベストかは分かってない

他の単語とかと同じくそのまま解析に突っ込まれてニューラルネットに入るので、カンマを入れると特定の動きを毎回するのではなく、ただの文中の1文字でしかない >>572

影響自体はあるんですね!

プロンプトでの記号使用も奥が深い…

今まで文章の終わりもカンマにしていましたが、プロンプトでもピリオドの方が適切っぽいですね もうイラストレーター名の前にbyも要らんだろってやったら、オッサンになったりして笑う

メインの詠唱はしっかりした文章の方が理解されやすい気はしてる

セレブ顔混ぜたり、おまじない系は羅列でも割と効果ある感じ。

オープンソースのおかげで世界中で研究されてどんどん進歩していくな

>>82で見かけたヤケクソな呪文

Watercolor painting in style of krenz cushart ilya kuvshinov kyoani, makoto shinkai, hideaki anno, mochiduki key, studio ghibli, madhouse, white fox, studio trigger, gainax, violet evergarden, granblue fantasy, fate grand order, kinmoza!, kanamemo, hanayamata, shirobako, yuyushiki, k-on!, nichijou, lucky star, a-channel, umaru-chan, nyaruko-san, devilman, claymore, kiseijuu, code geass, guilty crown, umamusume, idolmaster, kancolle, touhou project, nier automata, k-on, yuruyuri, cygames, production i.g, wit studio, p.a.works, ufotable, mappa, toei animation. cute girls doing cute things trending on artstation pixiv makoto shinkai smiling super detailed eyes eyebrowless symmetry face visual novel ゔぁぁああ服が出ねぇぇぇ

「一枚の服だけ」が欲しいのに出ねぇぇ

一枚の服って指定してるだろうがあぁぁ

4chan.org/g/sdg

見てるんだけどなんかみんなイライラし始めてて笑えなくなった

>>578

無茶苦茶になるんじゃねーのw

と思ったら意外と悪くない出力になるね >>580

イライラ?なんで?

思ったように作れないとか? >>582

えっちな画像貼るなって一人でわめき散らかしてる奴がいるせいかな 平均的にいい部分だけ残るみたいな場合もあるよな

カレー粉みたいにめちゃくちゃになる言葉もあるけど…

>>583

なるほどw

まあ情報共有系、プロンプト・作品発表(R18/一般)は分けたほうがスムーズな気もする

こっちはまだそんな流れ早くないからいいけど Emma Watsonって混ぜるとどんな状況からだろうと全部エマワトソンになるから笑うわ

人物におけるカレー粉的存在

>>577

萌え絵とかエロ絵っていう低俗な世界だからイナゴ共が大挙して研究して発展するのよね

これが例えば医療用AIだったら、いくらオープンソースにしても誰も見向きもせずに進化しない

仕方ないことではあるが何とも情けない話だな エマワトソン頼んでもないのに出てくる時あるよな

開発側がファンなのか

エマ・ワトソンはちゃんと美人だからいいわ

海外で美人とされる女ゴリラが出てくるのはちょっと勘弁だな

画像処理の論文で必ずと言っていいほど出てくる例の謎の女性のポートレートも

元をたどると研究者がその辺に置いておいたポルノ雑誌から適当にスキャンしたエロ写真だしなぁ

デジタル化が進んで便利になり3Dも写真加工も使えるようになり

昔は絵を描くのが簡単になってコストが下がると思われていたんだけど

現実には逆にイラストの作画コストはインフレし続けゲームに使われるCG枚数は減少の一途を辿った

最近のゲームのイベントCG枚数は昔に比べて1/10くらいに減ってしまっている

宮崎駿は写真やCG使う風潮に「そんなもん時間かかり過ぎだろ、手で描けよ!」ってキレてた話は一部で有名

せっかくAIが出来てもみんな下絵を自分で描いて〜修正用やリサイズは別AIで〜ループバックで〜って

たった数日で既に工数のインフレが進んでるの超速で歴史の繰り返しをしているの笑ってまうわ

エマ単体だと大抵そっくりかちょいイケメンになる

自分の場合

Ana de Armas (目でかくなる・鼻細くなる美人

miss universe (ポーズ綺麗・遠くても顔潰れにくい・たまにブス

こういうのも混ぜてみてる

良い感じに似なくて美人になる有名人だれか見つけてー

very detailedとかは最初のほうの文章に入れたほうが効果ある気がする

今見たらアンチスレ結構賑わってるじゃん、古塔抜いてイラ板トップだ・・すごい

是非そっちでやって盛り上げてあげてくださいな

>>588

まさに規模の経済って奴やな

実用性や自分達への見返りを鑑みても100%医療AIへの発展に全力ベットすべきなんだがそこがまた人間故の性 幻覚が見える系の統合失調症の人のアウトサイダーアートにも通じる気がする

興味が仮にあっても自分で使えない物のOSSに貢献するのは難しい。動作がOKなのかどうか医者にヒアリングしないとわからないしね

医療AIやるならお金もらえるわけで、OSSに市場を破壊されにくい医療AIの方がいい面もあるね

>>598

めっちゃかっこいい

けど革命ってほどではないかな。 >>599

自閉系サヴァンの視覚世界に近いんじゃないかな >>600

思いついたものをポンポン画像化できるのはかなり便利じゃない? >>602

あ、そういう意味ね。

そう思います

用途がどんな感じになるのか想像もできなくて期待と怖さがある pixivデイリー1位のイラストに似せるというプロンプトの練習をしてみた

日替わりでお題が出るので楽しいかもしれない

死んだ後に自分そっくりの絵柄で自分の名前を冠してエロ絵生成されまくっとるとか俺なら泣きたいww

無料のStable Diffusionで4つとも全部黒塗り画像が続くと悲しくなる

表現の自由をください

>>615

ESRGANの公開モデルとかは写真向けだから緻密な絵画風のを入れるとノイズ扱いされると思う

モデルがチューンされてれば別だけれども >>608

だからワードは多い方がいいって言われてんだ

ちなみにグレッグ・シコルスキーさんも強いぞ AIの絵にはエロさは全くないな、学習データの問題もあるっぽい

アウトな画像からも学習してるけど圧倒的に多いのは表の健全な画像だからな

そっちにかなり引きずられてる

>>599

現代アートって正にそんなのばっかだからw >>618

まあそもそもサービス提供元がエロとグロを規制してるから仕方ない エロ系はlaionのデータ眺めてみると動画サイトのサムネとタイトルみたいのばっかりでそういうのも良くない気がする

キャプションと画像がちゃんと結びついてない

虹だけ学習させたhentai AIとか日本人ならやりそう…

そういうのできねーの?

danbooruあたりでtransfer learningしてる人いるっしょ。いないわけない頼む

>>623

しようと思えばAI開発者なら出来るけど大きな社会的責任負ってまでやろうとは思わんだろ

エロとかはアングラ系がやってくれるだろうからそれまで待つしか無い 画像処理で有名な女の人の写真ってエッチなやつなんだっけ?

>>631,632

ありがとう!githubなんて慣れてないからほんと苦手だ outputsのsamplesにちゃんとプロンプトをテキストで残せるようになったのか、嬉しい

しかしまたフォルダにプロンプト名・・と思って>>578入れたらちゃんと切り捨ててくれてた

やっぱ多すぎるとほとんど無駄なんだな

> Watercolor painting in style of krenz cushart ilya kuvshinov kyoani, makoto shinkai, hideaki anno, mochiduki key, studio ghibli, madhouse, white fox, studio trigger, gainax, violet evergarden, granblue fantasy, fate grand order, kinmoza!, kanamemo, hanayamata, shirob

ここまでしか効いてない、思ったより少なかった

以下切り捨て

> Warning: too many input tokens; some (133) have been truncated:

> ako , yuyushiki , k - on !, nichijou , lucky star , a - channel , umaru - chan , nyaruko - san , devilman , claymore , kiseijuu , code geass , guilty crown , umamusume , idolmaster , kancolle , touhou project , nier automata , k - on , yuruyuri , cygames , production i . g , wit studio , p . a . works , ufotable , mappa , toei animation . cute girls doing cute things trending on artstation pixiv makoto shinkai smiling super detailed eyes eyebrowless symmetry face visual novel

shirobakoのshirobまで認識されてるからノイズになりそう? え、ファイル名に入ってないと切り捨てられてるって意味なの

アジア系やアニメ、ゲーム系が上手くいかないのは画像認識AI側の問題もあるっぽい

LAIONで日本の著名タレントで検索かけると無関係な日本人女性の写真が大量に混同されてる

アニメやイラストでもこの手の認識ミスが大量にあって画像認識段階でこけてる

>>637

いやOSのファイル名の長さは関係ない

上で書いてる人いたけど、トークンに制限がある>>114

ちなパスが255文字意識してるらしく、SDのある場所によってはかなり短くなるので

同シードでプロンプトがあまり長いとケツの方が違ってもパスとファイル名同じになって上書きされちゃう模様

(自分の環境ではフォルダがghibliで終わってる)

stable-diffusion-mainはドライブのルートに置くべきか

なお、>>578のカンマなくしたらそれだけ多く認識されて当然画像も変わった

詰め込みたい場合は区切りなしがいいみたい

>>638

>>594 学習データの内容は流石に画像生成技術で良くないか?

PC弱者、英語弱者すぎていつ使えるようになるやら、、

今のAI「一般」の画像収集が難でアニメ顔上手くいかない話とかアンチ賛美スレでワイワイみんなやってるから、そっちでやればいいと思う

つかみんな結構面白そうな会話してて読みこんでしまったw

ここはMJでどうやったらアニメ顔だせるかな?とかの具体的な話するスレでは?

技術評価じゃなく技術交換なんだし

VRAM4GBでimg2img動かせるようになりましたか?

anaconda入れる意味あったかとかcdnnの入れる場所はcudaの場所でよかったのかとかよくわからん右往左往しつつようやっとStableDiffusion動かせたけど1枚2分かかる

うん、>>43のgoogle colabでいいや… >>642

Stable DiffusionはLAION-5B使ってるって分かってるんだから別に一般でもないだろ

なぜ普通にやったらできないかって話はどうやればできるかにも繋がるだろうし Nendoroid

StableDiffusionフォーク先の話題から拾ったがやけにうまく学習されてるな

アニメ絵の顔面崩壊具合を見てると奇跡に近い安定性

>>649

redditのほうでやってる人は見たが、hlkyで対応してくれるのええな

ただESRGANの何が良いって顔修正してくれる所だから、一部だけ適用みたいなの出来れば最高なんだけどな gigapixel art:0/0 gamma 2x

>>650

色々とごっちゃになってない?

GFPGAN 顔を認識して歪み等々を修正してくれる 解像度は上がらない

ESRGAN 画像全体にノイズ除去をかけて超解像してくれる 顔が歪んでてもほぼそのまま GFPGANとESRGANどっちもかけていけ。なおメモリは死ぬ。

詠唱が上手い人、特に既存のアーティストのミックス、パロディ、再構築で個性出せるような人は、今後音楽で例えるならDJみたいな価値を持つようになるんかね

ミュシャとかゴッホ等々の名だたる巨匠の画風を統合したアートが生まれるのかな

詠唱が上手い、と言ってもモデルがアップデートすると変わるんだよね

>>499のnotebook、

・pytorch-lightningのinstallをURLで

・Load modelのckptをフルパスで指定

でやったら(少なくとも自分の環境では)動きましたね

ただLoad modelでなぜかやたらRAMを使ったのでColab Proじゃないと厳しいとかあるかもしれない どうせ駄目だろうって試してなかったGFPGAN

>>652で存在思い出したのでやったら980tiで動いたわ・・こりゃ捗る

512x448が448x448までになっちゃったけど、歪なサイズなんて意味ないし、丁度よかったw >>660

GFPGANをCPUで動かしてVRAMを節約する起動オプションがあるらしい

使ったことないから詳しくは知らない 3DCGメインで普通のゲフォを使ってたけど

この流れで次はちゃんとQuadro買わないとダメなんかなと思い始めてる

>>664

今この瞬間はゲフォで戦えてるけど

もっと高解像度な画像を吐くAIが主流になったら

普通に要求GPUメモリが20~30GBとかになっちゃうんじゃないかと危惧してます 画像AIの普及を妨げるのってグラボの性能と価格かもな

グラボの値段下がったと思ったけど跳ね上がっちゃう?

Midjourney Discordの登録者数が95万人(ピーク100万人だったけど無料枚数終わった&StableDiffusionでちょい下がった)

Geforceグラボが四半期で1000万枚(平均単価15万円)

少しだけ人気のゲームが販売された、程度の影響じゃないかな

騒いでるのはクリエーターでまだまだニッチ。一般にブレイクはしてない気がする。今後分からないけど

後企業のAIサービス用GPUとかがめっちゃ売れたりするかも

直に金にできるものじゃないからマイニングほどのパワーはないかと

それこそ必要スペックの高いゲームが流行るかどうかくらい?

しかし使い方が悪いのか、世界変革させられないぜ

>>667 >>669

RTX3080未満のグラボ持ちなら

Colabの方が電気代すらかからない無料でしかも速いからいいと思うんだが

ヤバイ画像作りたいってのなら話は別だが 無料colabはストレスが・・ちょっとフォーカス外したらcaptcha出てきたり

離籍して戻ったら途中まで起動したのが全部終わって生成部が動かなくなってたり

あと100枚行かないうちに上限出て12時間だっけ?置かないといけなかったので

ガンガン画像作るとなると実用性が

ローカルPCだと翌日スリープから復帰したらそのままいきなりブラウザ上のgenerateボタンだけで生成が動く上、無制限

コマンドカタカタのはやたら遅かったけど、GUIのやつは最適化されてるのか全然遅くないので驚いてる

絵を描く人もやってると思うが物の名前や画家を調べるのも楽しい

遊ぶにも知識は大切だわ

存命の大物女優でやるとどうしても顔が長くなる

1970sとか1980sとか入れても

>>673

youngとか、若いとか15才の頃とか入れてはどうか 解像度上げたいならハードウェア面では何をよくすればいいんだろ?

>>675

VRAM more VRAM

もしくはCPUで長時間かけて焼く >>675

GPUのVRAMを増やす

でも3090TI(24GB)でも960x640、もしくは896x896が限界、らしい

マルチGPUだと、512x512を2枚同時実行はできるけど、現時点では多分解像度を増やすのは無理な気がする

A6000(48GB) 66万円でも単純計算で1920x1080は無理で1920x640とか? 個人じゃきついね >>678

>>679

やっぱVRAMかあ

2年前の3080の12Gで古いし現行の12Gにして改善するかなと思ったけどダメかあ

24Gでも辛い StableDiffusionのデモで動かしてた時はA100の80GBを大量に入れたGPUクラスターで動かしてたんだとさ

そりゃ1024x1024の画像がバカスカできる訳だわ

Midjourney、StableDiffusionの前からGoogleのImagenとかがあって同じことが出来た。

しかし計算量・必要メモリ量が膨大でコンシューマGPUでは512x512なんて全然無理だった

Difffusionの何が凄いかというと、必要メモリ量を64分の1に削減してコンシューマ向けGPUでも計算可能にしたこと

内部的には512x512どころか64x64解像度で計算して、計算結果を512x512に戻してる

それでやっと6GBメモリとかなんだよね

>>676

midjourneyでは"15 years old "を頭につけて女優さんの名前で、顔が短くはならないけど年輪が刻まれていない雰囲気にはなった。

別人かどうかは見立て次第だけれど プログラム作成者の人達、プロンプトの具体的限度文字数とか教えてくれないのかな

絶対俺無駄に入れまくってるから具体的に「256バイト以内です~」とか言ってくれると大変ありがたいんだけど

プログラム作成者ですら文字数上限を理解してないとかありえるのかな

>>684

トークン数は75

けど俺は”トークン”が何かがよく分かってない。CLIP(テキスト解析)の説明を読めば書いてるはずだけど難しいw

swiming, girl は2トークンだと思うけど、swiming girl は2トークンなのか、1トークンなのかどっちか分からん >>686

最初公開された時は75だったはずだけど77になってますね。失礼

”トークン”=”単語”なのかな でも>>578のカンマスペースハイフン全部なくした

Watercolorpaintinginstyleofkrenzcushartilyakuvshinovkyoanimakotoshinkaihideakiannomochidukikeystudioghiblimadhousewhitefoxstudiotriggergainaxvioletevergardengranbluefantasyfategrandorderkinmoza!kanamemohanayamatashirobakoyuyushikikon!nichijouluckystarachannelumaruchannyarukosandevilmanclaymorekiseijuucodegeassguiltycrownumamusumeidolmasterkancolletouhouprojectnierautomatakonyuruyuricygamesproductioni.gwitstudiop.a.worksufotablemappatoeianimation.cutegirlsdoingcutethingstrendingonartstationpixivmakotoshinkaismilingsuperdetailedeyeseyebrowlesssymmetryfacevisualnovel

トークン数1?も最後まで警告なくちゃんと読み込んで萌え風になるんだよね・・どうなってんだろ >>685

そこ謎だよなぁw…

「1単語ごとなら75個までです!」とか優しく言ってくれるとわかりやすいけど、絶対そこまで適用されてないし

>>686

って、本当に77単語までOKなの?…

実感として77単語も入れたら後ろ半分くらい効果を全く感じないんだが、本当に本当なのかな?……

77単語入れず30単語くらいでも明らかに最前と最後で適用されてる感違うし…

う~ん…むらむらする… トークンっていうのは、AIが言葉に振ってるIDみたいなもの

入れられた言葉をトークン表と照らし合わせながら拾っていく

例えば、helloであればhelloという固まりのトークンがあるのでこれで一つ

hello allだとhelloとスペースとallで3つ

hjfj ftjb(意味のない羅列)だとh j f j スペース f t j bで9つ

翻訳みたいなことをされて実際の処理に投入される

日本語は2バイト文字だからただでさえ2倍のサイズな上に

ほとんどトークン表に登録されていないのでほぼそのまま文字数x2=トークン数でバカスカ食う

トークン表は言語を学習するときに勝手にAIが選ぶので追加とか削除はできない

はえ〜、なるほど

ちょっと目先を変えて日本語試してみてたけど、やはりそういう不利があるのか

トークンオーバーフローしたらワーニング出すように修正しようかな、と思ってソースみたら

既に、GUItardは対応してた。以下のメッセージで何が無視されたかが出るはず

"Warning: too many input tokens; some ({len(overflowing_words)}) have been truncated:\n{overflowing_text}\n"

>>692

勉強になります!

意味のわかる英単語(多くの画像検索結果が出る) 1トークン

スペース 1トークン

意味のわからない英単語(画像検索結果が殆ど出ないetc.?) 1文字につき1トークン

これの合計で75~77トークン以内に収めたら良い感じっぽいですかね?

目安がわかりやすくなった!

スペースとカンマは同じですか? 違うトークンとして認識されるんでしょうか??

「A B, C D」 AスペースBカンマスペースCスペースD =8トークン?

「A B,C D」 AスペースBカンマCスペースD =7トークン? >>695

すまん例にスペース使っちゃったけど今調べたらスペースは多分トークンの外だわ

カンマは1トークン

なのでカンマでブチブチ区切るととんでもない勢いでトークン数が消費されていく エロには厳しいみたいだけど、作った背景とかを

エロゲーやエロ漫画の背景に使うのもダメなのかな?

>>701

小学生でもわかることを聞くガイジが居てw >>659

よければ具体的教え欲しいです

自分素人なもんで、よくわからないです

あとColab Proにはしてます >>701

> エロには厳しいみたいだけど

確かにMJとDSは有料サービスなんでうるさいんだけど、

SDはコード丸見えなんで早々に良心回路外されて無法地帯化してる そういえばすでにDreamStudioの話誰もしてないね、DSって書いてわかるのか一瞬迷った

>>697

実験してたらこうなったのでスペースも関係ありかと思っちゃいましたがそうでもないのですね!

,,,,~,,,,many cats,(カンマ148個+many cats,) 猫が出る

,,,,~,,,,many cats,(カンマ149個+many cats,) 猫が出ない

,,,,~,,,,cats,(カンマ148個+cats,) 猫が出る

,,,,~,,,,many cats,(カンマ149個+cats,) 猫が出る

,,,,~,,,,many cats,(カンマ150個+cats,) 猫が出る

,,,,~,,,,many cats,(カンマ151個+cats,) 猫が出ない

>>699

「即位する」「即位した」でもトークン使用量が違うんですか!?

奥が深いなぁ……

とりあえず単語1トークン、カンマ1トークンを基本の目安として考えてみます!

その目安で簡易的な「プロンプト適用上限を超えています」とか表示されたら便利だなぁ >>681

>>682

VRAM80Gをクラスタでwwwww

テクスチャ用途で2048夢見てたが、ムリポだな…

なんとか512か1024をアップスケールして2048にするしかねーわ 例えばこれは12トークンになるっぽい。

aとかtheとか意味があるのかないのか。単語だけ切り出して意味ない気がするけど、文脈を見て関係あるのかな

a girl on the beach, white , swiming

'<|startoftext|>', 'a</w>', 'girl</w>', 'on</w>', 'the</w>', 'beach</w>', ',</w>', 'white</w>', ',</w>', 'swim', 'ing</w>', '<|endoftext|>',

a

girl

on

the

beach

,

white

,

swim

ing

●webui.py

info = model.cond_stage_model.tokenizer([prompt], truncation=True, max_length=max_length, return_overflowing_tokens=True, padding="max_length", return_tensors="pt")

ovf = info['overflowing_tokens'][0]

overflowing_count = ovf.shape[0]

+ iid = info['input_ids'][0]

+ vocab = {v: k for k, v in tokenizer.get_vocab().items()}

+ t = [vocab.get(int(x), "") for x in iid]

+ print(t)

if overflowing_count == 0:

return

即位する 11

'<|startoftext|>', 'a', '?', '3', 'a?', '?', 'a?', '?', 'a?', '?</w>', '<|endoftext|>'

即位した 11

['<|startoftext|>', 'a', '?', '3', 'a?', '?', 'a?', '?', 'a?', '?</w>', '<|endoftext|>'

>>709

文章におけるトークン使用量の計算難しそうですね…

「swim」と「ing」を分けて計算されるんですか…

現在進行swiming分解済み単語とカンマだけなら10トークンぽいのに、12トークン…

「hayao miyazaki」等の人物名も2トークン扱いかな…

「hayao-miyazaki」でも2トークンかな… >>707

なかなか興味深いですね

それ見て思ったのはカンマを二個並べると、トークン=意味としてのカンマと、純粋な区切りとしてのカンマを交互に認識していって

約150個のカンマが、AI的には70数個のトークン(中身はカンマ)として認識されて最後に77個目に猫をねじ込めるかどうかという挙動になってるように思えます。ただの仮説ですが そもそも人間が文章を見て何トークンか数えるのは無理だと思う

ましてUnicodeなんか出てきたら>>710みたいに文字ですらない単位で分けられちゃうし >>711

>「swim」と「ing」を分けて計算

>>699にあるURLの

>例えば「国王が即位する」という文をトークンに分けると、「国王/が/即位/する」という分け方になり、4トークン

>一方「国王が即位した」という文の場合、「即位した」で1トークンであるため、「国王/が/即位した」の3トークン

に近い挙動だね >>711

swim と ingは、2トークなんだけど、</w>はingにだけついていて、1ワードだという認識はありそう

じゃあ</w>の単位で認識するのか?というと「可愛い巨乳女」は

'<|startoftext|>', 'a?', ' ̄', 'a', '?', '?', 'a??', 'a', '・', '¨', 'a1', '3', 'a\', '3</w>', '<|endoftext|>'

最後だけ</w>がついているけど、ちゃんと可愛い、巨乳、女、が生成される

>>668の冒頭だけ取り出すとこう

Watercolor painting in style of krenz cushart ilya kuvshinov kyoani

['<|startoftext|>', 'watercolor</w>', 'painting</w>', 'in</w>', 'style</w>', 'of</w>', 'k', 'ren', 'z</w>', 'cush', 'art</w>', 'ilya</w>', 'ku', 'v', 'shino', 'v</w>', 'kyo', 'ani</w>', '<|endoftext|>'

Watercolorpaintinginstyleofkrenzcushartilyakuvshinovkyoani

'<|startoftext|>', 'water', 'color', 'painting', 'inst', 'yle', 'of', 'k', 'ren', 'z', 'cush', 'art', 'ily', 'aku', 'v', 'shino', 'v', 'kyo', 'ani</w>', '<|endoftext|>'

こっちは,paintingが1つ

swimingは現在進行系の形容詞、paintingはく名詞として解釈されているのか1トークンになってる? 形容詞とか名詞みたいな人間にとってどうかはトークンには関係ない

まして日本語だったら「可愛い巨乳女」は「å¯æ„›ã„巨乳å\³」みたいな意味不明な文字に見えてるはず

(もっと言うと「a¯aaa·¨a13a\3」でそれがトークンに分けられてる)

人間には分からんとしか言えんから理解するのは無理

何て言うか、厳密に数える方法を探索するというより

無駄にトークン数を浪費してしまう典型的パターンを突き止めて、共有しとく意義はあると思う

>>716

あなたは理解できてないんでしょうけどCLIPは理解してますね >>718

実際それは割とマジで(正確にはCLIPじゃないけど)AIは「a¯aaa·¨a13a\3」っていう文字列と可愛い巨乳女の画像を結びつけて学習してるから「可愛い巨乳女」って入れたら可愛い巨乳女が出てくる 可愛い巨乳女、は人間は理解できるし、CLIPも理解している

>>716は全く意味不明 細かいこと言わずに外人のおおらかさを学ぼう>>22 生成における文章の力は強烈だけどトークンの計算が面倒そうだな

単語だけなら37,38個認識してもらえるぽいこと知れて良かった

単語数、トークン数で思うのはさ、よくある強力呪文の例文に

in the skyってよく入ってるけど、AIが冠詞theを有意に活用してるのかはまあまあ疑わしいので(人間がtheを入れることで気持ちよくなってるだけ説)

theと省けば文末の単語を一個余分に認識させられる可能性があるみたいな、そういうハックは解き明かされてほしい

もう寝るので他力本願ですいません

今日の学びはbronde short hairを入れると髪型サンプル画像のせいか構図のほうも首から上だけのパターンに引っ張られやすいということ…

>>702

わからないので小学生にもわかるように教えて。

生成した画像は作成者自身が権利を持つのでアダルト作品にも使えるってこと? >>725

間違ってるよ

AIが生成した画像に著作権は認められないので

「作成者自身が権利を持つ」のではなく

誰も権利を持たない誰でも使っていいフリー素材になる

もちろんAIの画像をさらに手作業で加工すれば

自分の権利を主張できる

またStable Diffusionのライセンスでは

「人に危害を加えたり、倫理的に問題があったり、

誤った情報を広めたりするために使うことは認められていない」

具体的に何がダメなのかは自己責任で考えてくれ 欧米人じゃなくて日本人が欲しいって人は"hanako"とか入れてみて

肖像権と著作権勘違いしてるのが講釈してるな

そして最後は自己責任とか。最初から自己責任でいいじゃん草生えるわ

↑呪文唱えた人とAIと演算リソースを提供した人が全権利を放棄(明記)した場合はフリーになるけどな

>>729

「全権利」って具体的に、何法の何権の話をしているの?

少なくとも著作権は誰も持ってないから著作権以外だよね

まさか法律をよくわかってない人がとりあえず「権利」

という言葉を使ってみただけで

それが何権かは自分にも分からないわけじゃないよね 「お前の言うことは間違ってる、不十分だ」ではなく、端的に「これはこうです」って言う方がいいね

著作権以外にも、意匠権、商標権とか、知的財産権はある

私自身はあまり興味はないので調べる気はしないけど

権利で思い出したけど、StableDiffusionの生成した画像は、これはAI生成画像ですって見えない電子透かしが入ってる

背景はフリー素材に近いものだから漫画に使うのは大丈夫でしょ

実在人物のエロ画とかはやめといたほうがいい

>>731

> 権利で思い出したけど、StableDiffusionの生成した画像は、これはAI生成画像ですって見えない電子透かしが入ってる

マジ? >>733

公式にちゃんと書いてるね

an invisible watermarking of the outputs, to help viewers identify the images as machine-generated.

機械生成画像であることを識別できる、目に見えない電子透かしが入っています

画像の色調補正とか、上から何かを追加で書き込んだりしても残る

といっても激しく加工すると消えるけど

実際的にこれで何か困るかって言うと多分困らない。自分で描きましたドヤァ、の人の嘘がバレるぐらいかなw Midjourneyくんにもその透かし機能ついてて欲しいなあ

AI生成の画像に著作権がないは間違い

著作権がない画像が生成されればその画像には著作権はないが著作権がある画像が生成されればユーザーがその著作権を認識した時点で著作権侵害となる

例えば「鬼滅の刃の画像」とプロンプトに入力し鬼滅の刃の著作権がある画像が生成されればその時点で侵害

鬼滅の刃を知らないユーザーが「大ヒット漫画の画像」と入力し鬼滅の刃の著作権のある画像が生成され公開し、権利者から指摘されれば指摘された時点で侵害

AI生成画像が、偶然既存の著作権がある画像と同じものを生成した場合、「著作権侵害にならない」

両方に著作権がある状態になる、と弁護士が言ってた

そんなこと言ってたら漫画のファンアートが一切描けなくなる

類似したキャラで大々的に商品展開しなきゃ問題にはならないと思うよ

「AI画像に著作権がない」というのはAI開発者の著作権はないと言う意味

フォトショップでイラストを描いてもadobe社に著作権が発生しないのと同じ

>>739

画像を学習させたAIで学習元に似た画像が生成された場合は偶然とは言えない

既に完了した行為については違法性はないが権利元が「あなたが使用した画像生成AIはこう言う仕組みで我々の著作権を侵害しています」と告知されれば告知された時点から違法となる

ツイッターなどにあげた画像は閲覧が可能な期間ずっと公衆送信権の対象となるので告知を受けた時点で速やかに削除しなければならない

既に頒布済みの紙の同人誌などは回収しなくてよい >>723

画像とその画像に対しての説明文の対応を学習していると、

説明文によく使われる言い回しが効果的とか噂だけれどもトークンに分解されるなら関係無いのかな 法律上の著作権の認定は極めて厳しく意図的な丸コピーの継続反復でもないと殆ど認められないから

実際には民間による私刑が横行してて、米国では基本当事者間の訴訟で解決してくれというスタンスでこれを公認

このため法律ではなくyoutubeなどのプラットフォーマーや消費者のお気持ちで権利侵害かどうかは決まってしまう

現状は企業などの強者が違反を申し立てればプラットフォーマーは無条件に公開停止/発禁処分を取っている。法律は無関係

ただSDはアニメ漫画関係はかなり気を使ってるようなので気にする必要はないだろう

「鬼滅の刃の画像」と入れても中華製のパチモンみたいなのが出てくる

これはこれでなんか問題ありそうな気もするが

>>745

トークンに分解されていても、それぞれのトークンが独立して(重みに応じて)作用しているわけではないですね

例えば、girl having glass と gil wearing glassはこうなる

また、girl having glass, wearing red dress だとこうなる

つまり、単純にhave, wearがあるからそれっぽく配置しているわけではなく、英語の分法に沿ってどこにかかっているトークンかを理解していることになる

真面目に勉強するか・・・ AIがどんどん進歩していけば未来ではプロンプトの工夫なんてのもなくなって

プロンプト検索サイトで好みの画像探したらseedをちょっと変えたり

単語ちょっと追加してだけでリリースってなると思う

電子透かしはinvisible-watermarkというライブラリを使ってるみたいだ

hlky版やbasujindal版はこの機能が削除されている

basujindal >>664みたいに--turboで速くなってこっちがいいのか、と思ったら

GUItardも4GBで動く--optimizedオプションがついてた

動き速いなあ 4GBでもサクサク動くimg2imgのGUI作ってくれたら助かるが流石にまだ難しいかな

冬のボーナスで安い価格帯24Gのグラボ2枚刺し考えたけどうちの1枚しか刺せなかったわ

例えば24GBのGPUが2枚あるとして、512x512の画像生成を2つ同時に走らせるのはできるはずだけど、

合計48GBとして使って1920x1080の画像を生成できると書いてる人はいない気がする

できるのかな?

>>755

デモンストレーションのはGPU大量に使ってやっているから出来るんじゃないかなあ

デモ用のチューンで配布版は出来ないかもしれないけど nvidia GPUで24GBより上ってなると、A6000の48GB 70万円弱になっちゃうから

Google Colab Pro+ の51GBメモリ(月額5243円)はめっちゃお得だね

>>756

なるほど

よく分かってないけど、これ4倍、8倍・・・みたいに繰り返し使えたりするのかな? サイズでかいから上げないけど風景などはRealESRGANで結構いい感じになるなぁ

壁紙にしてもいいかな、って感じ 肖像画などはものによるね

>>761

ありがと

試してみようかな

webuiまたUI結構改善されてんのね

アップグレードどうすりゃいいんだw

conda env remove -n ldo して最初からやってほうがいいかな >>703

8/28版は何も変えなくても動いたからもう一回元のURLからドライブにコピーしてやれば普通にできると思う webuiでimg2img使うとエラーでる

TypeError: process_images() missing 2 required positional arguments: 'gobig_strength' and 'gobig_steps'

同じ人いますか?

>>761自己レス

>長いプロンプトで生成されない不具合

出力時の保存パスがちょっと長くなる修正が入ったようで、そこで自分の環境ではWindowsのパスの長さの限界超えたらしかった

C:\直下に移動して無事最新でも動くようになった

>>764

つい数時間前にそのあたりのコード入れたり消したりしてたからバージョン変えれば大丈夫そう webuiといってもどのバージョンか分からない

とりあえず、このwebuiでimg2imgだと、サンプリングメソッド=DDIMは動くけどそれ以外はエラーになるね。

https://github.com/hlky/stable-diffusion

エラー内容は違うから別のフォークだと思うけど

File "scripts/webui.py", line 1112, in sample

samples_ddim, _ = K.sampling.__dict__[f'sample_{sampler.get_sampler_name()}'](model_wrap_cfg, xi, sigma_sched, extra_args={'cond': conditioning, 'uncond': unconditional_conditioning, 'cond_scale': cfg_scale}, disable=False)

ValueError: not enough values to unpack (expected 2, got 1) >>766

自己レス。

最新版で解消しました。 1時間前に修正されたぽい Nendoroid構文色々試してるけどメチャクチャ強力だなこれ

プロンプトの前半に入れた瞬間にデカ顔2等身写真風になる

colabからのセットアップですらエラーになって

自分の知識の無さにゲンナリする

引数が足りてないとかそんなんかなあ。分からん 既に各種ペイントツールのプラグイン対応が進んでいるし

背景や小物はもうAI使って描いていくのが常識になるんだろうね

WebUIの

「sort samples by prompt」は使わないことにした

呪文をいろいろ試してるときにフォルダを分けられると逆に手間が増える

生成時にすぐいいの選別するし、次点みたいなのは後から自分でフォルダ分けた方がわかりやすい

「write sample info files」もexplorerで縮小画像一覧が市松模様になって見にくくなる

cfg値やらはだいたい自分ルールがあるし、呪文は別にテキストで残してあるので

seedは連番ファイル名のうち、一番小さい数字のやつってわかるし

つか生成ファイル名の連番ルール間違ってるね、seedが1234567890の時

-0001-1234567890.png

-0002-1234567890.png

-0003-1234567890.png

にすべきなのに

-0001-1234567890.png

-0001-1234567891.png

-0001-1234567892.png

ってなってる、カウンターに用意した0001が無意味

これからも色んなAIがでるみたいだし、

今のうちにハイスペPCを買っといたほうがいいのかな……

20万で足りる?

そういう文句はここじゃなくてissueまでって書いてあるぞ

シード指定で複数生成した場合、シードを1つずつ増やして生成されるんだから合ってると思う

>>776

いや無指定だし、infoのファイルの中見たら全部同じseedになってたよ

pngファイルだけseedが増えて行ってるへんちくりんな状態だった 確かにyamlファイルのseedは間違ってる

でもその文句はここで言っても仕方がない

同じシードなら同じ画像になる

無指定ならランダムなので連番でもない

ああ、逆か

yamlファイルの中の加算を忘れてるのか・・seedは+1ずつされてて

a dogを「無指定」+yaml生成で3つつくると

-0001-3671057218_a_dog.png ---- yaml内seed: 3671057218

-0001-3671057219_a_dog.png ---- yaml内seed: 3671057218

-0001-3671057220_a_dog.png ---- yaml内seed: 3671057218

ファイル名のseedが合ってて、yaml内がおかしい

>>779

無指定はランダム起点の連番、よってランダムではない どちらにせよ連番画像でシードが同じはずと考えるのはおかしい

MJの記憶が焼き付いてて

同一seedの--s無指定(2500)での変化が頭から離れなかったのだ(言い訳)

>>774

VRAM10GB越えのグラボを用意するつもりなら、全く持って足りない 現行のAIってGPUに仕事ぶん投げまくるのが基本だから徐々に需要が高まると思うな

短期的にはわからん

>>774

3060(12GB)のPCなら15万円ちょっとで買える

けど、その場合、無料のGoogle Colabと同じ性能でメモリが半分なんだよね

今すぐ買いたい、何かやりたいなら買えばいいと思うけど

この後、どのぐらいの必要スペックのどんなソフトが出てくるかわからないのがね

個人で普通に買えるもの(人によるけど)としては3090Tiで50万円ぐらいのやつかな

10月〜12月頃発売予定の4090も同じぐらいの価格帯で性能が倍になるらしいからこれも悩ましい

その上ってなるとA6000(48GB)の70万円(GPUのみ)

この上はもう1000万円を超える

現時点では50万円ぐらい出して24GBの3090か、予算内の11GB以上の奴か、って感じかな マイニング業者が転向してColabもどきみたいなの始めたら面白そう、月額300円で使い放題みたいな

それでも24時間ぶん回し続ける採掘よりは儲からないか

マイニング企業がAI企業にrentalするってのはあるかも

これベータの生成上限(200枚?)いくと

画面右下にyouなんとかで会員情報確認しろって英語で出てくる?

クアドロじゃなくてGTXで買うなら4000番待ちのほうが賢い気がする

ゲーム目的なら3070くらいがあれば十分だしあとは4000がこなれたころに買い換えっててもあるけど

元々求めているところが一般的には最上位でもまだ足りんって感じだし

拘りがないならGoogleに月6000円払ったほうが安上がりだと思うわ

3080価格推移

バブル崩壊と分かってても衝撃的

NVIDIAは4000番出す前に市場の3000系があまりに下落したら在庫回収しちゃいそう

なお、採掘業者産の中古はヘタってるから、保証期間残っててもやめた方がいいって話も

>>792

DreamStudioの話かな?

無料枚数の4割くらい使ったところで放置してるわ、ちょっと肌増えたらすぐ画像ぼかしてくるし

ここでその状態知ってる人いるのかなぁ、むしろあなたが先駆者になって教えてほしい

>>793

googleさんはエッチ画像作ってないかスーツ着たお兄さんたちが眼鏡を光らせて見てそうだし

拘ってないけど、ドキドキするよね n_iter 枚出した時に

一枚目以降はstepが変わるとシードも変わってるのかな

1枚目しか収束していかないから良い絵が出ても居なくなって困る

全身の絵が欲しい場合full bodyでいいんだろうか

boobs入れると引っ張られてバストアップばっかになる気がする

>>797

いろいろ試してる人が居るんだなあ

試してみます ありがとう MJはfull bodyに加えて9:16とかにしつつ

knee socksとか入れたら描かなきゃってなるのか全身になりやすかった

long legsとか入れたらどうかな

SDは正方形でもMJよりは全身出してくれることが多いけど

ガチャするより自分で落書きがにimg2imgで呪文被せるのが一番早い気がする

絵はmspaintレベルのこんなんでいいので

足に言及すると足を描こうとしてくれるから全身画像になりやすいのは確か

なんだったらfull bodyだって書いてんのにバストショットじゃねえかってなるのより信頼性高い

img2imgを使うとこの位の画像なら数分で作れてしまうのが恐ろしい

絵が描ける人ならこれを下敷きに修正する作業なんてあっという間に終わるぞ

あ、作った画像はこれな

ベースのプロンプトさえ用意できていればこれが数分はやっぱしゃれにならんわ

念願のセクシーギャルできたぜ

>>802

背景はいいけど、顔も体がクニャクニャすぎて補正がめっちゃ大変な気がする >>796

512x256みたいに縦長にしてまず全身像であることを説明してから「胸は小さめ」「足は裸足」とか言及してくと成功しやすいと思う。 >>804

正直ゼロから描き起こした方がマシ

これじゃ下絵に引きずられてデッサン狂う 「脇の下を見せる」にしても「両手は組んで頭の後ろに」って説明文入れたほうが正確に描写してくれる。

背景としては本当有用だと思う

俺も802みたいな画像生成したいが…無理!

英語わかんねえよ

導入で手こずって3日経つけどまだStableDiffusion導入できません

Windows11のWSLで1から環境構築して使えるようにしている記事とかありせんか?

ある記事ではCUDA入れろとか、ある記事ではCUDAの記述なかったりとかでどれも1から導入しても何かが足りなくて必ず躓いてしまうんです

現状はWSLインストールコマンドでインストールされたubuntuにアナコンダとCUDAを入れてみたんですがStableDiffsionのtext2img描画コマンド?でGPUがCUDA対応してないとかで弾かれて躓いてます(Windows側にNvidiaドライバーは入ってます)

たぶん導入やそれ以前の問題でこうなってるんじゃないかなと思い、1から手順通りに従って完全に動作するマニュアルみたいなものが欲しいんですが

そんな都合のいいものはないですかね?

Linux初心者です

>>809

WSLでCUDA使う時点でハードモードだけどなんでそんな事してるの? Gregテンプレでも初音ミクって入れるとこんなに日本人っぽい絵になるんだよね

やっぱりバッチの一枚目が一番プロンプトを意識した絵になる確率が高い気がする >>810

なんの知識もない状態なので……

WSL環境ではUbuntu上(中?)にCUDAインストールしなくてもいいんでしょうか?

Windows側のシステム環境変数にubuntuパスのCUDAがどうも記述されてなかったので有効になってないのかなと

何がどうなってるのか本当に分かってないです エロを出したいときに直接nakedやnudeと指定すると引きずられて一気に絵が崩れる

裸にしたいときは裸でいそうなシチュエーションを間接的に指定したほうがいいな

今後のイラストレーターの仕事の主流は

AIの描いた絵の手直しになりそう

>>812

CUDA以前にWSLを使う理由がわからない。なんでそんな事してるの? どのガイドを見ればWSLを入れだすことになるんだろうか

イキって独自導入記事書いてる変な人のヤツでも見たのか?

>>813

nudist naturalist pornstarあたり… >>815

Windows11環境だとコマンド一つで仮想linux環境が出来て簡単という話を見たからです

それとWindows標準の機能というのが個人的に安心できる点だったのもあります

皆さんはどういう環境で動かされてるんですか? WSLはオーバーヘッドあるからやめたほうがいいぞ

どう考えてもやる必要がない

釣りキチ三平の矢口高雄が背景上手いと評判だからMDで海を描かせたら上手かった

人体が微妙に崩れてるのは明らかなんだから

上から3Dモデルに同じようなポーズ取らせてから手直しするなりすりゃいいんじゃない

>>813

nudeでも、上手いというか写実的なイラストを描く人、具体的にはgreg師匠あたりに描かせると

実はこっそり描いてませんでした?ってくらい整ってる率が高い

なので崩壊要因が他のPromptなパターンもあるからセパレータでいろいろ試したほうがいいね 初期?のAIの出した崩れた女体でしか性的興奮を覚えなくなったなんとかフィリアみたいな人もどこかに生まれているかもしれない…

グラビア的なセクシーポーズにしたかったら pin up girl とかいいよ

イラスト多めぽいから色がケバくなりがちだけども

on the bed とか on the couch みたいに状況設定すると

それなりなポーズをとってくれる

img2imgのあるgoogle colabとかありますか?

>>820 のGUItardの手順は昨日までは良かったけど、今時点では古いと思う。

・webuiを別途ダウンロードする手順だけどマージされてる(最新ではないけど)

・webui.cmdは設定だけで起動しなくなってる。 Launch Waifu Diffusion で起動

・ldoのリネームもwebui.cmdでいい感じにしてくれるので不要になっている

勘違い、間違いがあったらごめん 今はローカル用のpc無くてStableDiffusionをGoogleColabで利用してるんだけど、近いうちにStableDiffusionが規制される可能性ってありますかね?

Colabで耐えててpcを揃えた頃にローカル版含めてStableDiffusionはインストール出来ませんになってたらって思うと不安しかない…

それともオープンソースだからそんな心配はないのですかね…?

エロい絵の加筆みたいなことをやってもらいたかったんだが、まだまだ現代の技術では無理だったようですね・・・

絵師が上半身しか描いてないから下半身もAIに描いてもらおうって思っただけなのに・・・

肝心な部分が文字で見えなくなってるから文字だけでも消してくれないかなとかね・・・

greg師匠でも初音ミクってワードを入れると激しく崩れるので

名前を入れないで工夫してミクを描かせてみた

これくらいがいいところか >>829

規制解除版がgithubから消される可能性はあるけど、解除方法なんかはネットで語り継がれるんじゃないか

てか今使えなくてもとりあえずファイル一式落としておけばいいよ 粛々とAIに描かせた美少女画像を貼ってだべれる匿名掲示板的な居場所が欲しいんだがどこか無いものか

TwitterはBANやらなんやらでこういうのは向いてない

ここはなんか技術の話という感じで違いそうだが他に流速のありそうな板も見当たらず

みんなどこに居るんだ

>>0833

あれ、StableDiffusionってコードを打ち込んでネットからインストールしてく手順でローカルに入れるものだと思ってました。

ファイル一式を落とせるとこってありましたか?

>>829

現状、deep fakeの実行がColabのBAN対象になってるから

少なくとも制限解除版が実行不可になる可能性は十分あり得ると思う >>835

できれば日本語で…でもありがとう

久々に楽しいお祭り騒ぎだと思ったが時代だなあ

国内の匿名インターネット空間が壊滅していることに気づいてしまった >>832

そうですね。あくまで今時点はあってないってことで

>>836

一旦インストールしておけばオフラインで使えるよ

zipで固めて他の環境にも持っていける

minicondaのインストールは必要だけど >>834

画像の公開はDiscordやTwitterが多いんじゃないかな。確かに匿名の場所は活発じゃないかも

ここも作品・プロンプトスレと分離してもいいかもね >>838

モデルの落とし方は分かりましたがリポジトリがよく分かりません…。

そのリポジトリは二番目のurlのどこにありますか?

プログラム用語情弱で申し訳ないです… >>813

賢い

あとは文字では画風の指定だけして、img2imgで肌色であることをAIに理解してもらうとかうやな >>847

>>825の1番目の手順

git入ってなければgitもインストールする必要がある

(とりあえずzipダウンロードもできるけど後々gitはインストールしておいた方がいい) >>831

食べ合わせが悪いものを混ぜると作画が大崩壊するね

俺もいい感じのリアルタッチ人物画を出せる呪文にたどり着いたけど

もう少しおっとりした目にしたいなって思って橋本環奈先生を混ぜたらその瞬間世界が崩壊したw 拡散モデルってAVのモザイク消しを超大規模にやるみたいなもんって思っていい?

>>847

すまん確かに

緑色で[Code]となってる所クリックするとメニューが開く→ Download ZIP で保管

とりあえず練習兼ねてインストールしてみたら? >>850

>>853

ありがとうございました!

これでローカル版用のパソコンに備えることができそうです! >>825

レスが遅くなってすみません

詳細に書いていただきありがとうございます、参考にします! AI画像にやっきになっている人の男女比が知りたい

あとSD発表されてからのgoogle colaboの使用率の変化

けっこう公式が中身の解説を出してくれているのが遊びがいあるなこれ

Pythonの勉強兼ねて遊んでるけど変に盛り上がると大手が買収飼い殺しが多いからマイナー文化でいて欲しいわ

今更DALLの招待が来たけど、Stableまわりの勢いと進化が凄すぎて全然ワクワクしないな

これから100社単位で提携して各国語対応その他モデル構築する予定らしい

基盤モデルなんてこれからのど真ん中の技術だから、SDが主流かほかが巻き返すか知らないけどマイナーな訳はないと思う

Dalle、技術的には同じようなもんなんだろうけど、SDはオープンソースでみんなUI改造したりローカルで動かせるから勢いがいいよね

初音ミク抜きミクさん試してみたけど、何回やってもくそでかツインテ描いてくれませんわ

つーかどっとうpって貼れないのね 2862938

DALL-Eはプロンプトに強制的に黒人を出現させるノイズが混入されたりするので使い物にならない

大きめ画像はどっとうpをarchive.todayに通せば貼れる

AI君テクスチャとか繰り返しパターン弱すぎんか?

単調な模様がほしいんじゃ〜〜

img2img使えそうなcolab漁ってるけど全部setupが上手くいかねぇ

多分俺のやり方が悪いんだろうけど

なんかウェブサイト上とかで簡単に出来るの待つしかねーか

>>862