!extend:checked:vvvvv:1000:512 http://2chb.net/r/cg/1669092302/ http://2chb.net/r/illustrator/1669117382/ https://rentry.co/zqr4r http://2chb.net/r/cg/1667401816/ 前スレの初期並みにひどい生成画像見たら笑い止まらん

NSFW全滅だとアート系のヌードとかもダメなるってことだから、かえって使いにくいような気がするな2.0

なんらかのエラーだって言ってくれ

sd2はインペイントを考えすぎてるのかな

何が得意で何が苦手かはまだ追求されるだろうし、数日か数週間もすればSD2をベースにしたやつも色々出るだろ

SD1.5までで使えた「kawaii, loli face」は使いものにならない やっぱ各所から色々詰め寄られてるんだろうか

>>17 でもこんだけ配慮?されてるモデルだし良いもの出したら企業が使ってくれそう

どうせなんらかのフォークや制限解除版が出てくるだろ

「イラストやデザインの仕事はとても退屈。芸術的かどうか以前に君たちは道具(ツール)だよ。」 企業安心して使えないよ 結局権利や倫理的に怪しいソースを使ってさらに過剰学習という名のパク…

別に俺アンチじゃないんだけどまじで出てくるものが微妙すぎて泣きそう

まあ宇宙開発とかでもロケット打ち上げ失敗とかしながら発展してるんだし

WebUIってネガティブもトークン数えられてるのか?

>>32 いやこの考えを捨てよう…俺の中のネガティブプロンプトだ

結局の所強力なタグ付けとデータ量を持つ📦が最強って事でおk?

teddy bear sexが1000枚もない雑魚サイトがイキってんじゃねえぞ

>>33 普通に考えればポジネガそれぞれ75ずつじゃないの?

エロはある程度画力ある絵orまとまった構図の良質なデータセットなのに

これから始めようとおもうのですが、過去の1.5を使うことって出来ますか?最新の2しか利用出来ないんでしょうか

今って前の環境のwifeがないくらいの状態ってこと?

グレッグさんが無効な上に激遅いな >>43 >>46 そもそもクリーンAIとしてはadobeの方が使われるだろうしなぁ

これからは追加のデータセットを有料販売していくのが一般的な形になりそう

>>41 SD2.0ベースの二次元特化サービスで第二のnovelAIを狙っているとこ出てくるかもね

TwitterとかでEmadが投稿してたみたいなリアルな山の俯瞰視点の画像みたいなの出せないの?

CLIP部とUNet部とVAE部で各部だけ単独でGPUに載るようコードにmodl.to(device)追記して切り替えまくったら8GB VRAMでも動いたよSDV2

ckpt に直接dreamboothかけて学習させたいが、そんなことって出来る?

直接は無理

ダーティなことしなきゃまともな画像は生成できないってはっきりしちゃったのはなぁ

2.0で一枚だけ山出せたけど、プロンプト追加してくと変なノイズになっちゃうな。それも何連続も、プロンプト最初に戻してもおかしいまま AI画像ってのはあらゆる画像を生み出せることに意味があるんだ

お前が4本指350本指というものを思いつく時点で割と人間に思いつきうるものなんじゃない

俺は超優秀なアシスタントを手に入れた気分だわ

>>61 履歴書が超優秀だったからアシスタント採用したら失敗した感じよ

SD日和ったなぁ

Emad氏のツイートだとまとも?な西洋画出てるし実行環境か制御の問題かしらね

昔の画家の絵画は出る 現代の作家と写真系が凄く弱くなった気がする

それはモデルの問題ってことなのかな

MJはほとんど叩かれてないのを見ると

へんに他企業がリリースする画像生成AIで倫理観の整理がされてしまう前にエグいのをオープンソースで出してしまってほしいが

なんだ、技術スレとか言いつつ自分でソースコードもいじれない無産だらけだったのか

今頃気づいたのか。ここはインストール方法スレだからな

>>68 技術スレなんだから俺はソースコード描きなおして改善した、という報告するならいいんじゃないかな

そもそもデータセットの問題にソースコードもなにもないという

オープンソースのプログラムは「フォーク」といって別のプロジェクトに分岐することができる

>>77 >>77 定期的に人が増えてしょうもない荒れ方するよなこのスレ

責任はとらん!お前たちが好きに作れ!ということか

>>82 ツールに対する細かい社会的な都合とかを無視したら、

こんなに超短時間で良くなってるのに物足りないと批判されるってヤバいと思う

>>88 >>87 >>81 SD2.0は自分で使っていないのに判断は下せないかなと。

昨日からローカルで使えるよ

隙間見て 試してみたけど、たしかに高解像度でも崩れにくいし景色とかはとても綺麗だ

なるほど高解像度のほうがきれいになってるね 512x2でやってたのがダメだったのか?

>>88 >>90 文字が出るようになってるな。日本語プロンプトもいける https://imgur.com/a/Htrx37I 都市伝説で異次元に行くと文字が変とか言う、それっぽい。

>>104 日本人だって中央アフリカと南アフリカの違いはわかんないでしょう?

意味不明な文字が出るのは前からだね

前よりは文字らしきものが文字になってるな

SD2.0のcolab notebookが出てきてるな

わしゃわしゃしてみた結果、写真的なのと奥行きは強そう

NovelAI系が目的ならステイどころか一生気にする必要ないよ

先にNvidiaが発表したeDiffiが文字を正確に表記出来る事を考えると

延期を繰り返すのはだいたいクソゲーってのはどこの世界も一緒なのな。はー、最初の威勢もなくなったし残念だわ。

SDの規模と資金力と技術でもクリーンな学習するとこうなるってことは

SD2.0+eDiff+nsfw+masterpiece+style+最低でもダンボールタグの表現力(細部指定)が欲しいわけで…

Checkpoint /content/drive/MyDrive/model3.ckpt has both EMA and non-EMA weights.

>>123 え なんか改悪あったの

NovelAIの話じゃないよStablediffusion の話だよ

つーかもしかしていつか規制で学習元が規制されてまとまじゃなくなる可能性もびらぞう

自己発電用のつもりが無かったんでなw

anynai見てるからかnjのクオリティすげー低く見えるんだけど一般的にはそうでもないのかな

ハンコ顔がカッチリ出るのは絵描きからするとあまり。いつも同じ絵じゃんって思っちゃう

考えて数百トークン詰め込んで同じ絵じゃんとはならんと思う

あでもNJは適当に入れてもいい感じになるね

あとそう、NJは試してないから知らんけどプロンプトで突然絵柄が変わったり謎の解釈されるのが嫌なんだよね

指定しないからだと思う

なんUのスレとかpart20の方のスレで相談乗ってもらってくるといいよ

こっちはSD系だけど死ぬほど試して自分で呪文の傾向のメモも作ってるw

2.0は深度管理ができるようになったんじゃなかったか

絵描きでもプロンプターでもいいけど未来予想で短文連レスされると意味ある検証が流れるからできればやめてくれ

すまん

有名人・アーティストは学習時点でプロンプトとの関連を無くしたから

要するにハードが新しくなったからやれることやグラフィックはよくなったよ

SD2.0 はよ1111に対応してくれ

>>134 セルアニメ風はそんなによくない。イラスト風はかなりよく見えるけどね

アニメ絵みたいな省略された絵の深度はちゃんと判定できるのだろうか

SD2.0ってckptのやつ?

>>155 >>157 需要って最初から研究開発用途だぞ

colabだけどSDwebuiバージョンアップしたらなんか不安定になった

DBの拡張版がhuggingfaceから持ってこれるからSDv2のチューニングができるかと思ったが甘かったか

>>151 あえて突っ込み入れるなら刃の方

SD2.0、Lexicaにある奴の同じプロンプトを入れても全然再現できないな

1.4, 1.5のいい感じのを2.0でi2iしたらどんな感じになるんね?

>>169 テキストエンコーダが変わって、具体的に以前のプロンプトがどう通らなくなってるのかなあ

DBのテキストエンコーダってなんなのかイマイチ分からんのだけど、

単語の表現範囲が狭いというか生成される画像にばらつきが少ないんだよな

>>175 full bodyには「豊満」って意味があるからだぞ

やっぱり更新止まってたのは2.0への対応だったのか

単語にはたくさんの意味があるけど、そのことを理解してくれてないってことかな

CLIPスコアの上昇は解釈の幅が狭くなる事と同義なのかもしれん

waifuやnaiで使われてるbooruタグは素の1.5とか2.0では通用しないとか

NAIは単語を適当に並べるだけでいいけどSD2は自然言語的に書く必要があるってことかな

自然言語的にする必要はないと思うよ

なんかcolabが上手く動かんと思ったが、その辺のゴタゴタまわりで

1111SD2きたんかー

SD2ベースのWaifuやAnyが来てからが本番や

anythingはNAIのリークが元だから

しばらく2.0が盛り上がることはなさそうだな

今更SD1.xベースのWDがきてもマージの餌にしかならんからSD2ベースの世界を見せて欲しいなぁ

>>192 中華ニキの技術力と組織力に期待だな

VRAM4GB環境使ってA1111でSD2やろうとしたけど

自作ラノベをKindleで自己出版するつもりだけど

AI使ってますって明記すれば問題ないでしょ

そういやこのスレの前スレあたりで誰かが開発してた圧縮言語だか圧縮プロンプトだかのwebuiのextension出てたぞ

>>201 >>199 >>206 オウフw

よくある異世界ものみたいに、俺も訓練すれば無詠唱で発動できるようになるかな?

架空の絵師名で生成して絵柄を統一させるとかいう

>>199 Ctrl+A……Delete……Generate!≪詠唱破棄≫!Anything無詠唱召喚だッ!

>>202 >>213 TheLastBenのfast-DreamBooth colab、昨日あたりから

>>217 実は前からckptの他にvae.pt, yamlを同名でそこに置くというオプションはあった

洞窟壁画からはや数万年、AIで絵を描く道具を人々は手に入れた。AIもデジタル描画の延長線上なのだが、いずれは手作業のみで自由闊達に描ける絵師の人口は減り、職人として彼らは尊敬されるときが来る

>>218 sd2.0でなんかわかりやすく変わったなって感じられるプロンプトってどんなんになるんだろ

>>221 オートバイクとロードバイクとか、マウンテンバイクみたいな

工業品って、最初は薄くて軽いことを売りにして出るけど、

車は自分の足で走ってないとバレるから陸上競技は滅びてないけど

今いるイラストレーターがトラックに轢かれて未来の日本に転生したら手描き無双するのか

>>229 いつのまにかAUTOMATIC1111でも使えるようになったのね、SD2.0 >>227 AIしか使えない人と、プロレベルで絵が描けてAIや3D使って時短もできる人だと、前者を使う理由がないけどな…

その段階だと誰しもが簡単にAIで絵を生成してる時代の話だからAI開発じゃないと食って行けないだろ

今でも誰でも簡単にAIで生成できるけどなぁ…

スマホカメラかミラーレス一眼カメラかの違いかな?

架空の絵師名のついでで書き込んでおくけど意図的にtypoするのもかなり有効

アニメはまだ無理なんじゃね?

>>241 日本のアニメ技術を学びたい中国人からしたら

同じキャラを出してくれないんだから無理や

シード固定のプロンプト変更でなんかうまくいかない?

キャラクターなら相当細かく注文つけとけば同一人物は出やすいけど

>>245 NJはちょっとまんまなんじゃないかってのがポンポン出るからやりすぎコージー感ある

個人的にはWebNAIよりも悪質に見えるんだよなそこ

nijiのイラストをネットにあげてドヤってるやつは

>>246 二次創作なら学習画像が沢山あるからできるだろうがオリジナルだと厳しいわな

版権の取り扱いがヤバイし

nijiはmidjourneyの系譜のせいか呪文のチューニング難しくてな・・・

ポージング指定する時にデッサン人形を

最近は今まで馬鹿みたいに生産してきた何万枚という構図があるから、それをベースにi2iすることから始める

すまん、初心者なんだがwiki見てDreamBoothやってるんやけど上手くいかない >>264 pink板見て来たらむちゃくちゃ技術的な話していて驚いた

そりゃあ向こうは全員が『賢者モード』搭載してるぐらいだろうからな

2.0のwaifuみたいなの来るまでは何も怒らないだろ

たぶんSD公式は2.0の配布モデルは実質デモ版みたいなもんとして割り切って突っつかれそうな要素は排除したんだと思う

Sd2.0はむしろCLIPの変更やらi2iの強化やらがメインで、モデルはおまけみたいなもんじゃないの?腕時計のお試し電池みたいな

でも高画質で学習が必要となると対応データセットも簡単には出せないよね

>>279 1.4や1.5で吟味したプロンプトの効き方が変わって、また探し直しになったのがめんどい

>>263 SD2の学習されてないものは追加学習すればいいんだけど、アウロリペドエログロ差別宗教犯罪関連のいくつかのNGワードがあるとモザイクになる仕様はかなり厄介だとは思う

また合成ワードでみたいなので回避するしかないんかな

HNのメジャーアップデートすごいな

>>286 sd2は参照実装みたいなもんやしな

ちょい前話題になったVITSはベースモデルが中国語で訓練されてる影響で訛りあるからしょぼいと思われて沈静化したけど

>>286 >>289 >>289 >>265 >>292-293 >>291 感情を指定したり文章から感情を推定したり音声から感情を読み取ったり既に出来るんだよなぁ

数年したらAIだけでアニメ作れそう

>>296 まあ石ころの画像でも汗とか血管マークと湯気をつければ感情があるように見える

>>299 感じ方は人それぞれと言うけれど、個人の感想を言い合うだけじゃ話として成立しないと思う

DreamBoothって正面の絵しか学習できないのかな?

新しいHentai Diffusionが凄いらしいと聞いて試してるけどガチで凄い >>304 適当なvae使えばいいよ

もちろんヒストグラムが端から端まで埋まっていない時に限らず色調補正できるに越したことはない

an Asian youkai girl portrait with nekomimi ああシード同じにするの忘れてた >>304 anyはヒラメっぽいから嫌いだ

結局リーク今んところNAIありきだね

waifuって1.4もうすぐじゃなかった?いま出しても他のが強くて知れてそうだけど

waifuは個人だろ?

>>309 anyでも画家名いれて工夫すればもっと柔かい感じにできる

>>318 anythingはただ美少女作るだけだから飽きた

昨日、極めたとまで思ったのに

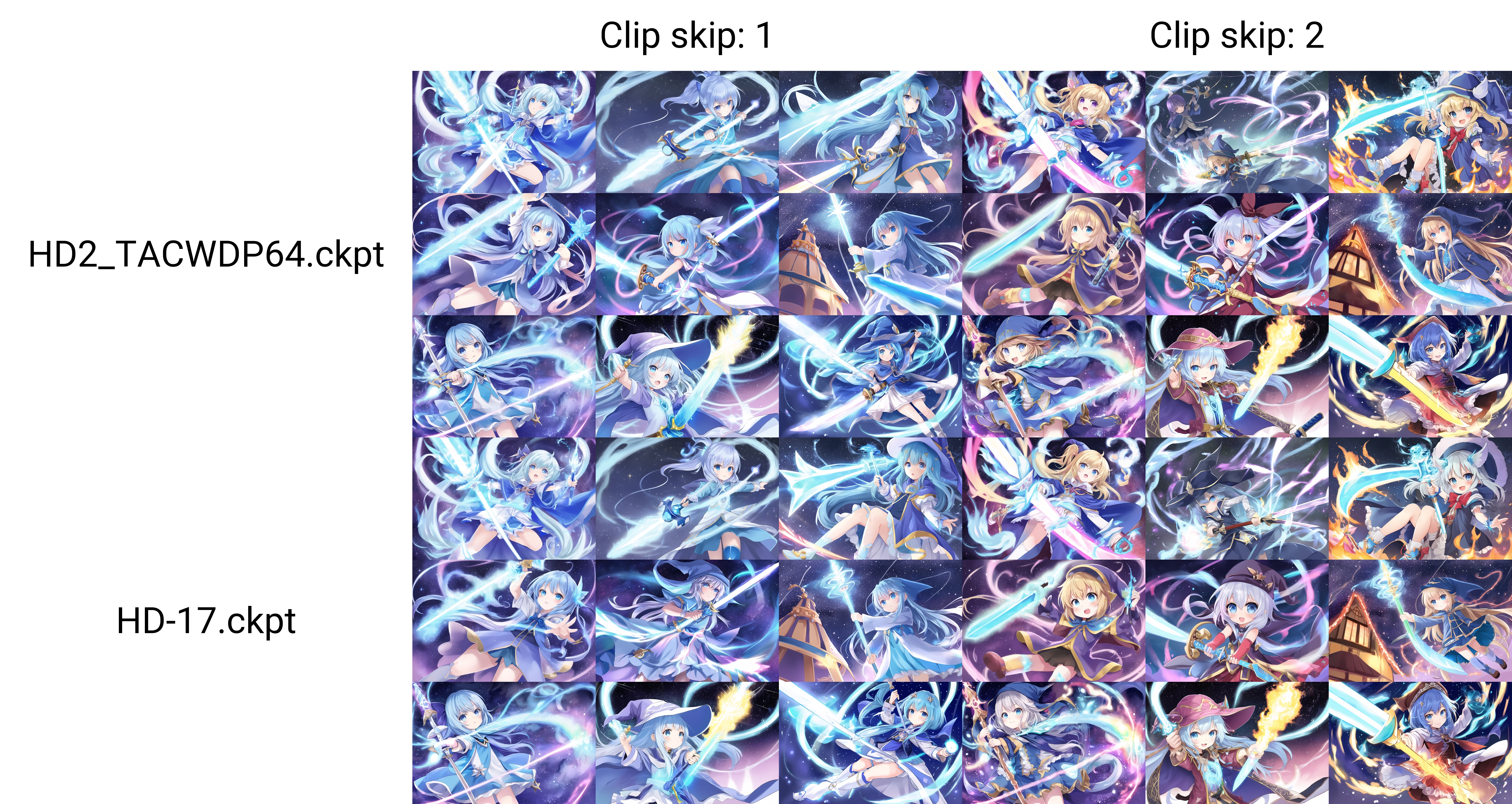

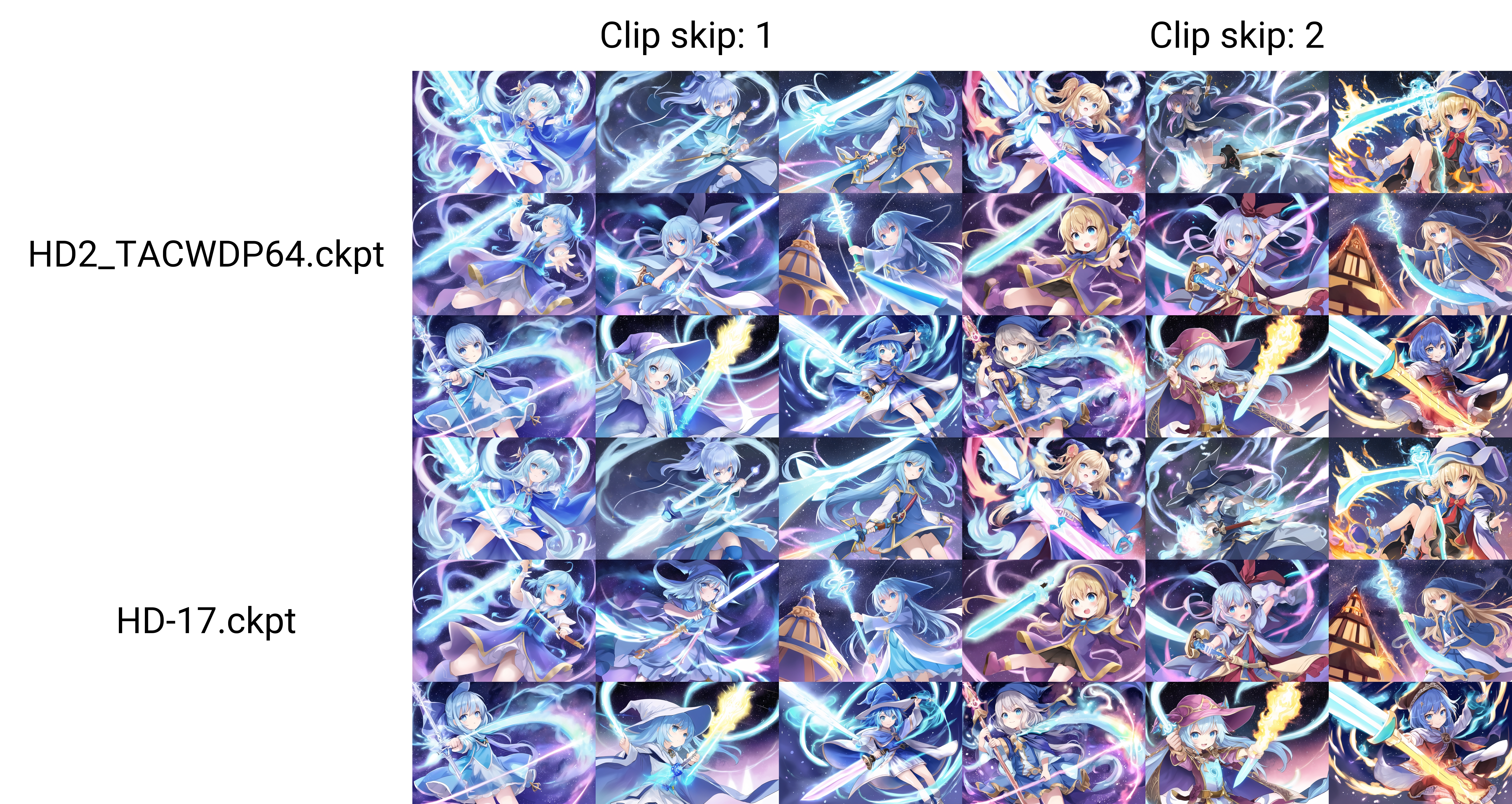

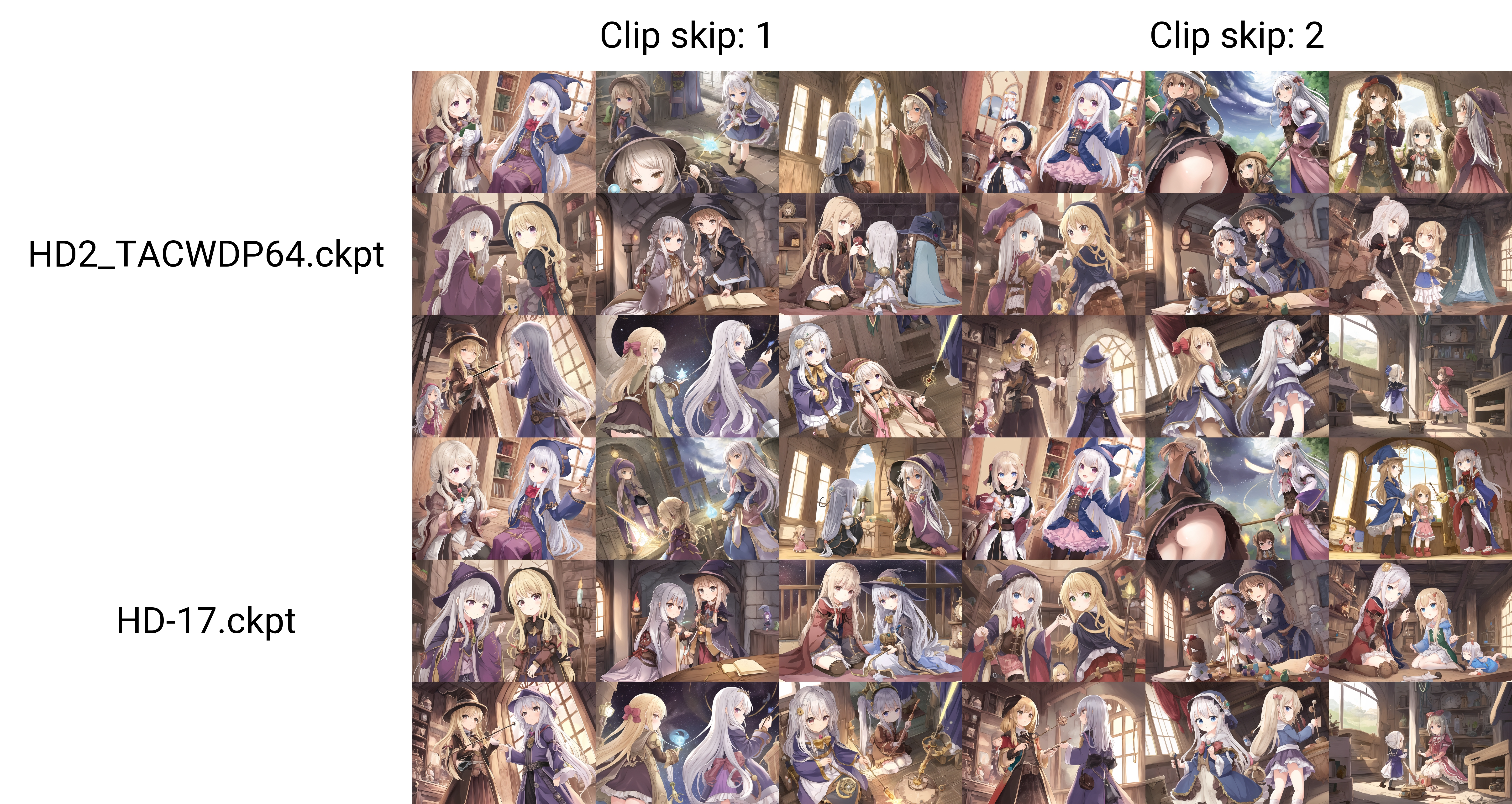

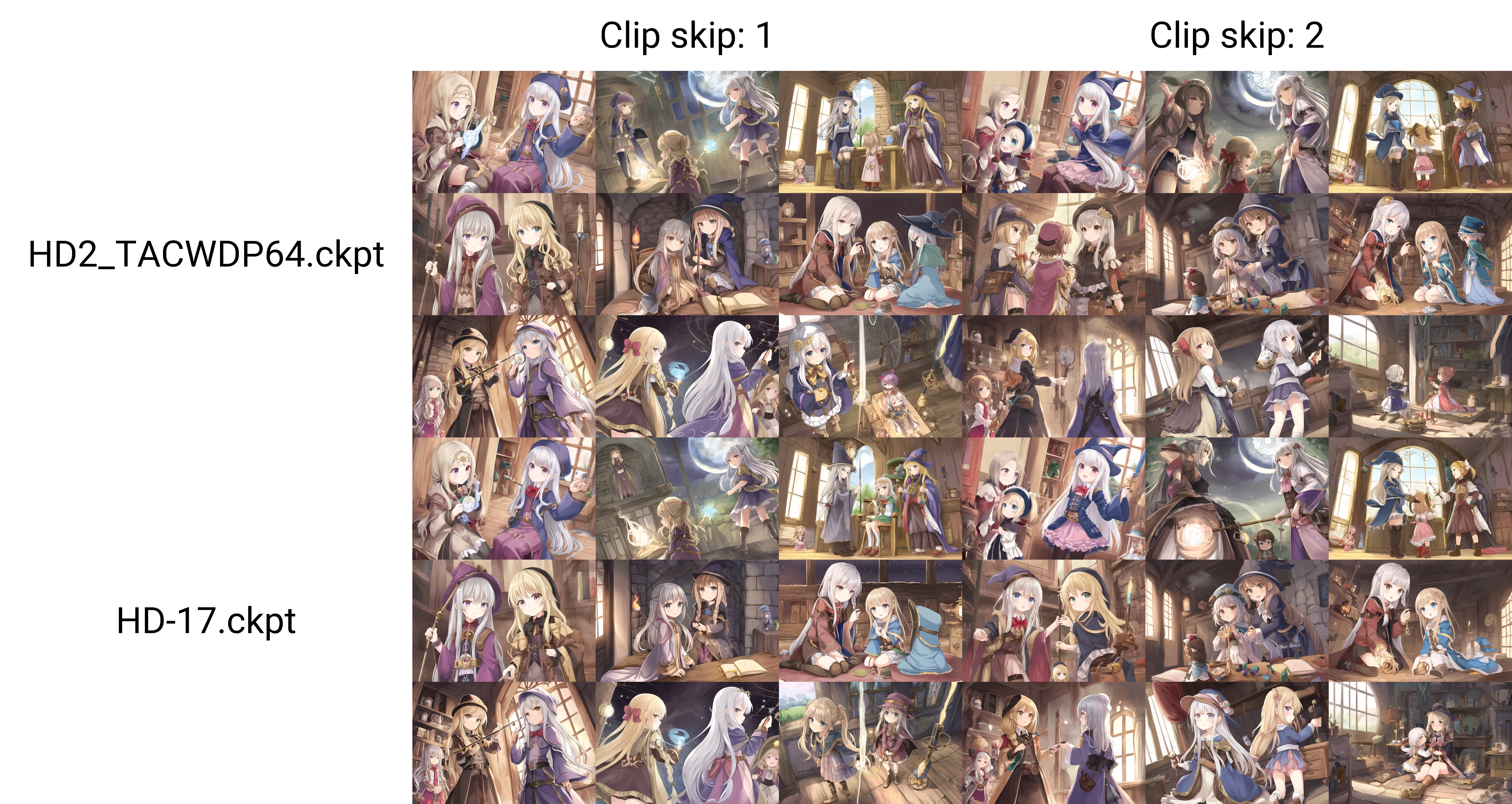

同じ設定でモデル比較 それにしても

>>324 ワイは底辺やからAIより時給やすいだろうし安泰やわガハハハハ

>>325 >>325 anythingは変わったポーズのモデルデータ入ってないからか奇抜な絵が作りにくいから飽きる

>>332 1つのモデルにまとめたいっていうのがもう古いわな

言えてんのこれだけじゃねえか

革ジャンのムーアの法則は終ったは値段を上げるための方便だと思ってる

AI凄いって盛り上がる間隔が狭まってるよね

凄すぎて凄さを忘れるくらいまでになると

シンギュラリティやらすぐ強いAI出現やら言い出す人達は

GPT-3といえば某界隈でのAIのべりすとの活用例を見てるけど

現状は人間が学習モデルを作ってごく限られた範囲に適用しているだけ

局所的な能力はただの弱いAIでしょ

Photoshopのコンテンツに合わせた修正ツール自動選択ツールがどんどん進化してるのと同じことしているんだと思ってる

強いとか弱いとか関係ない。

失業する人大量に出てくるならそれはそれでお仲間だしいま好きなことやってりゃいいや

AIに肉体労働ができるかよ

体内電流あげるからマトリックスの世界に行かせてくれや

こうしたいの方向性までAIが考え出したら人間用無しだな

車の組み立てができるなら肉体労働もそのうちなんじゃないの

なぜか絵とか音楽だけやたらと騒がれてるけど他の分野も危ういの気づいてないんだよねみんな

>>355 デジタルに近い分野ほどすげ替え効くからな

数字いじりとかコードいじりなら明らかに得意そうなイメージあるからじゃないのかね

AIは数字いじり苦手なのでは

>>360 まあでも音楽とか絵は今後超進化して何でもできるようになっても、この人が直接描いた絵がほしい!直接作曲した曲聞きたい!みたいなのあるからよくね、著作権も発生するし仲間内で遊べるやん趣味として

>>352 今頃GPT-3のアプデ来たんだけど、

この人が~ってなるのは、あくまで今現在は多くの人にとって深く好きになれる存在が人間しか居ないからでしかないでしょ

それ以上のどっちがどうだは宗教戦争になるから踏み込むな

どっちでもええんやが

NAI並みのエロ描写が出せる一般公開モデル(ckpt)ってないのかな

俺も知りたい

waifuなら、それでもwaifuならきっと

>>369 >>372 DBの追加学習に結構すぐに限界があることがわかったから、今のところマージ遊びに落ち着くなぁ

>>373 ANYは男体マジで出ん

お前らってステップ数とスケール数どうしてる?

>>379 いやスレチなんだから他所行けよ アンチ馬鹿にしてるけどルールも守れない奴よりマシだわ

>>378 SDの学習で使ったCLIPから変更して良くなる理屈が分からんのだが…。

ふと思ったけど皆promptどんなの打ってるのかなって。

>>384 カンマは一語にカウントされるから不要と理解してる

>>383 NMKDが1.71になって+/-表記に変更

stable diffusionでレオタードをローレグ化してくれるワードとかってありませんかね?

>>378 clip変えるやつかなり効いたよ

>>378 >>392 >>393 正常に出てたシードが奇形化するオチじゃねえだろうな

>>378 プロンプト1 自分でもやってみた

まあCFGスケールとかほかのモデルとかいっぱい動かして見てみたいパラメーターはあるんだけど時間かかりすぎる

>>393 マジレスすると英語にlowlegなんて単語はない

DreamBoothってCLIP自体も学習してたの知らんかった

AIはツールだからそれ以上でもそれ以下でもない

>>412 それで離れるようなバカは客じゃねえんだろう原始人相手にしてても無意味だからな

それは自己欺瞞だな

フォトショに戻ればいいんじゃね?

PhotoshopはAIでは老舗

>>420 イラスト界隈で今AIがどんな立場にあるかセルシスが知らないはずがない

>>412 ローカルじゃなかったら無料GPU提供サービスで笑うしかない

絵描けないけど手だけは自力で修正ってできるかな?

SDがクリーン化アピールしているのはclip studio以外にも組み込んで使う話しが来ているからではないかと予想

クリスタ使ってる人達ってマジでグラボって何?レベルの人多いからね

>>428 >>426 クリスタのSDは当然だけど画像生成はセルシスのサーバ側で実行するんだろ?

>>430 クリスタでSD2.0ベースならクリーンかもしれんが背景作るくらいしか用途がないな

>>435 クリスタは写真から線画作る機能あるから最初から線画作らなくてもいい

普通に色付きで生成して輪郭線抽出でええやん

>>436 >>436 背景透過した線だけのキャラって書いてくれないんだよな

>>436 いやそんなに無茶じゃないかもしれんわ

線画”風”とかラフスケッチ”風”じゃなくて、ラフスケッチから必要な主線のみにクリンナップした状態がほしいってことだろ、たぶん

waifu1.4は、やっぱwaifu1.3寄りになるよね・・・

線画加工するツールなら別にあるだろ

ラフから線画とかそれこそペイントソフトに高性能な専用AI投入されそうやな

少し前にNovelAILeak使ってるサービスにNovelAIが仕掛けた話は出てたね

>>452 >>457 12.68GBあっても駄目だわ、fast-stable-diffusion側で消費GPUを増やしちゃったのかな

>>461 vram12gbの3060だとどのくらいの解像度の画像が作れるんですか?

1500×1500がつくれるんですか?

>>464 >>465 rtx3060でこんなに細かい画像つくれるんですね。すごい

オッサンゲーマーというサイトではvram12では、640までしか作れないと書いてあるんですが、何か間違っていますか

最近はvramの利用の効率化が進んでるので、昔の情報はあまり当てにならない。

そんなに進歩してるんですか。あの記事からたった2ヶ月なのに

あと、ダイレクトに出せるのが2048x2048くらいってだけで、一回出したのをアップスケール&分割描き直しという手法もあるので、これだとどれだけでかいのでも描ける。

4Kだってヘーキヘーキ pixivに投稿されてるエロ画像がみんなサイズ小さいので、

>>477 最近初めてstable diffusion web ui (automatic1111)を導入して、画風の学習をさせようとしているのですが、全く上手くいかなくて行き詰っています。原因が分かる方いますでしょうか? https://wikiwiki.jp/sd_toshiaki/Textual%20inversion https://imgur.com/a/mBapB0u ベースをNAI同じ設定で回して見たら?

8GBで十分

3060はホント同価格帯の代わりがないのに安くて優秀で庶民の味方

悲報

NAIとかNJのクォリティみて調整してるんだろうな

誰かがwaifu2.0みたいなのを作ってくれないと

>>479 >>485 >>480 >>484 tagger使おうと思ったんだけどエクステンションからインストールしてstable-diffusion-webui-wd14-taggerとmodelsに解凍したフォルダを置いてもinterrogatorにWD14が無いしinterrogateを押してもコマンドプロンプトは反応しないんだけどフォルダの置き場所間違えてる? >>491 1.3だいぶよくない?

初期NAIでもまだまだやれることありそうなのに

やれることはあってもできないことは見えてきてるやろ

>>494 >>495 waifuの延期はしょうがないだろ

waifuが揃えた学習データーセットでSD2.0ベースで学習させるだけで2~3週間はかかりそう

Waifu作者を応援したくなった

>>495 >>495 ただ新規ならたいして値段も変わらない3060を買うだろうけど

>>508 Emadのツイートは虚構新聞より少し信頼してもいいってレベル

論文で性能比較してるって事はもうモノは出来上がってるんだろうから

>>517 Dreamboothに手を出してみたくてスレとgithubの情報を追っていたのですが >>453 )ではvram使用量が大きく無料プランのcolabでは動かない/有料プランでもGPUガチャになる? >>519 >>521 SD2.0なんか新しい話はないかなあ

SD1.4も、アニメ絵だのあんまいいのが出ねぇなとやってるところにWD1.2がきて派生モデルが盛り上がっていった感じだし、

>>499 webuiのdreambooth見てたら更新来てる!

2.0は学習させるとかなりいい感じになるって言われてたし年末くらいにはそれなりのものが出てくるんじゃないかな

stable diffusion のtrainで画像学習させる時に、画像ごとにつける(?)プロンプトってどんな感じにしてますか?

>>528 >>529 >>532 >>533 学習素材上に存在してるけど

>>530 ほんとややこしいな!前にテンプレート弄ってみた時に全然学習しなかったのはこのせいか

>>536 俺は実写顔学習させて遊んだりするのだけど、インスタとか盛った写真の影響を強く学習しちゃう場合は、

>>540 >>540 >>543 再現率上げれば汎用性が下がるからな

>>541 >>538 初めて学習する人は、タグ付けしない方が上手く行くと思うよ

>>542 「黒い服のヨル」にすると「赤い服のヨル」も「青い服のヨル」もいるからそこは特徴じゃないからね、って伝わるわけやね

今ダウンロードしてるところ

俺はフォトショと1111連携させるツール使ってるな。意外と便利

お守り代わりレベルに使われるがmasterpieceって結局何なんだ?

colabの1111でDreamBoothをやりたいんですが、Extensionからインストールしてもタブが追加されません colabの方でdreamboothをインストールするように書き加えたら動くんじゃね

>>556 >>556 >>559 >>556 >>383 masterpieceはSD出たての頃のグレッグさんみたいなもんやな

>>561 InvokeAIにモデル追加するのさては結構めんどくさいな?

なによりWebUIのExtensionたちを手放すのは惜しい

>>569 久々にNobelAI契約したがなんか使い勝手悪くなってね

InvokeAIのモデル追加に使う!import_model path

>>573 >>564 >>573 >>575 個人での学習用途なら3090TIは今後3年は最上位クラスだから…

来年の4060VRAM24Gで逆転ホームランを期待してる

そういう上位機種が売れなくなるようなことは死んでもやらん

pixivでみる絵のプロンプトってどこで勉強できるか教えてくれ

VRAM24GBの下位モデルなんて出るわけないんだよね・・・。

1111版やってるんだけどmeituみたいに自分の書いた絵を変換してみたいんだけどできる?

ここ数年VRAMの容量なんて飾りだと思われてたからな

VRしてる人なら『VRAM6GBぐらいは最低欲しい』っていうのがあったけど、画像生成で一気に要求増えたしな

3060の12GBが画像生成にハマり過ぎててな~

>>590 >>588 AI絵なんて絵の描けねえ無産が自家発電するためのツールだろうに

2,3回ポチポチしてドヤっていう層向けとしては大成功だろう

>>594 >>599 3090tiなんかで回してたら電気代半端ないよ

3070 8Gの俺の複雑な心境

ここで3060tiや3070のVRAM増量版を出すどころか

出た当時はスペックに見合わず無駄に多いVramを活かしきれない微妙なグラボって扱いだったけど、まさかレア扱いになるとはね

上位のGPUは電気代もだけど電源がな…

普通のゲーマーはVRAM容量よりバス幅・アクセス速度の方が重要だからね。

>>605 pc買い替えのタイミングにnovelAIリークが重なって3060買えたから良かったわ

仮想通貨のマイニング祭りが終わって、3090が20万以下で買えるなんて今しかないよ VRAM欲しいのはMOD好きとVR系位かな正直ニッチ

昨日なら3060が3万で買えたんだけどな

>>602 NAIリーク直前に70Ti買った俺もいるぞ

>>613 2060や3060の12G版ってメモリ余ってたから使ったったw説は本当なのか気になる

学習ってそんなにパワー食うのね

>>618 >>620 >>621 何エポックに対して何LRといった内容を掘り下げているサイトってありますか?

RadeonをメインにしてGeForceをサブにしても

>>624 不安定な組み合わせもあるのかもしれないけど(マイニングでwindows+)geforce+radeonいけるって話もある

>>626 >>629 ディスプレイ繋ぐのをRADEONにしてGPGPUとしてGeForce使うのは余程へましなきゃ今のOSはこなすがまあ使えん奴には使えんだけや

やっぱラデはRX6900とかでもRTX3060の方がいい感じなんかな?

Stable Diffusionそのものの技術は日進月歩なのに

4090で学習させてたら途中でVRAM不足でクラッシュwwwww

>>633 Windows+Radeon環境でも1111 webuiを楽にインストールさせてくれれば文句ないのになあ

そこまで言うなら自分で音頭取って有志をあつめるか、究極的に自分で書けばいいじゃんって話なんだよな

Radeonがメモリ32GBとか出してくれると期待している

画像のサイズを変えずに画質良くする方法ってないですかね?

そろそろnijijourneyを学習したSDモデルが出てきてもいい頃だろ、少し楽しみ

Stable Diffusion 2.1 beta coming real soon to a Discord near you

>>642 くっそ劣化したjpgを同じ解像度のまま元の絵に復元したいという意味では?

i2iすれば? >>630 >>653 pruningと呼ばれる軽量化が施されたもの

>>653 ChatGPTww

ChatGPTはそれでいいんだがSDだと削った情報にある程度必要な人もいるわけで

まあ生成時はprunedでいいって言うのは間違いない

chargptは面白いけど

>>654 macもネイティブ対応なんだね

NKMDでi2iしようとしたんだけど何故か元の画像がそのまま出力されるんだが原因がわかる人いない?

>>668 あとはInvokeAIのキャンバスみたいな機能が

今はというか、もうInvokeAIはChatGPT並みにエロ禁だからちょっと面倒なんだよな

なんで初期インストールの時にnsfwチェック拒否らなかったん?

ユーザーフォルダに.invokeaiファイルがあるからそれ編集すればいいみたいなことnsfwチェッカーが反応しても出たと思う

真ん中にキャラだけ置いてる透過画像から背景を作るのって出来る?

>>677 >>678 ちょっと試したけどパースはインペイントで背景消して描きなおしても人物に合わせてパースも参照されてるみたいや

multi-subject rendererみたいなスクリプトなかったっけ

そのキャラを黒くしたマスク画像作って、inpaintでマスクのアップロードしたらいいのでは

Any v3.0使うときはvae入れないと色が淡くなるってのは分かったんだけど、Any v3.0と他のモデルを7:3くらいでマージしたときもvae入れないと色が淡くなるんですか?

自分は応急手当的にそれで問題なさそうだったからそうしてる

1111使ってるから設定でAnyのやつに固定してるわ

理屈は分からないけどとりあえずAnyのvae使っとけばいい感じなんですね、ありがとうございます

>>652 Any3の画風でnsfwするには、naiと3:7でマージするのがいいって聞いたんだけどうまくいかない…間違った情報かな?

なんか更新したらHypernetworkの学習できなくなった?

いつものこと

>>691 一枚目の方向性好き

2枚目のうにょうにょ感も頭身下げればコミカルでいいかもしれないけど

>>695 確定でアニメ塗りで出力されるモデルかプロンプトないですかね

>>695 novelAIでi2iしたら必ず水墨画みたいに線が太くなるんですか設定とかの問題ですか?

マスピ絵は絵の具の原色みたいなものかな

Waifu2.1が出る前にSDがより高品質な2.2出しまぁす!って発表してWDも再延期、とかありそう

なんでこのスレの住人が最新情報の正偽を知ってると思ったんだよ

ある程度の人は参加してるとは思うけどね

.ptファイルでマージみたいな事が出来たら便利なのに…

samplerってどれを選べばいいんですか?

hypernetworkのマージはフォークがあったと思う

まず個人的に使い物になるサンプラー一覧

CFG Scaleに限らずSamplerにも言えることだけど

>>706 ,707 Kaggleの自分のDatasetにNotebookで落としたモデルを送り込むってできない?

DAの威力に腰が砕けた

huggingfaceでモデルを探していたら

でもワンチャンColabよりはそのへん緩いかもしれんね

ここ親切な人が多くて平和過ぎて草

流行りにつられたあたおかさん達は別のブームに住処を移動したんじゃない?

nijijourney入れたけどこれすごいわね

それは本当に限りなく欲しい絵に近いものか?🤔

i2iと追加学習はどっちが良いんだろう?

でも当たりを引いてしまえばもはや誰も真似出来ない絵が出せるわけで

あっi2iの特徴だこれ

>>738 実写画像を生成してi2iでいいじゃん

>>741 実写は物理的に限られた構図が無限なのに対し

学習やったことないけど

追加学習やったことないけどそれは学習の方向性によるのでは🤔

>>745 >>737 wd1.35もwd1.4もすげー楽しみ

※これまでとは

>>748 nijiの学習データもリークされねーかな

>>752 リークはともかくniji上で学習もimpaintもoutpaintingも出来るようになって欲しいのはあるな

gapeってNAIに追加学習したものだったんだ……

別にdanbooruから学習したってことはわかってたんだからリーク使わなくても同じ方法でモデル作ればNAIと同じものが出来るだろ

nijiってつまり基本midjourneyだろ

>>724 Any3でエロやるならNAIと混ぜるといいらしいけど、

>>748 なんでそんなに元気なんだ?

え?知らないの?

いつの間にかSD2.1公開されてんじゃん。ギリギリ最低限のNSFW成分を含めて追加学習したみたいだな

Stable Diffusion 2.1はリリースされたから試さないと。

ベースモデルは毒にも薬にもならなくてエエ

v2-1_768-ema-pruned.ckptをダウンロードすりゃいいのか

redditにあるちょっとした比較見ても差がわからんな

AUTOMATIC1111だとv2-1_768-ema-pruned.ckptを選ぶとランタイムエラーが出るな

とりあえず2.0用のyamlで動いたよ

vram24GBクラスのVGAって4スロット占有するんだな…

>>777 F222のほうがいまのところはいいおもちゃだな

もともと人体生成弱いのに裸類消しちゃったらよけい生成弱くなるわけだから、そこは反省したということか2.1

はよ蒸留なんちゃらとやらで1秒で生成できるようにしろよ

>>778 いまVGAの他にスロット3つ使ってるから他の用途捨てるか新規に生やすしかないんだ

なんか役に立つかもしれないとライザーカード2つもってたな

2.1VRAM要求厳しくなったのかな? 2.0では大丈夫だったのに真っ黒画像になる

>>788 >>791 >>777 そのエラーを設定すべてと共にissueに投げると喜ぶ人がいるよ

エロの無いmidjourney系統に

ハッキングをしかける必要すらないぞ

クリーン化して幅広く情弱に売りつけるか

中国産じゃないmeitu使いたい人はいるだろう

meituはバズってから株価1ヶ月で倍になったし、セルシス(クリスタ)はAIやめますって言って株価10%下がった

AIは次ステップ前夜って感じ

ElysiumはAnyベースだってばよ

>>802 meituに絵放り込んだら色んな絵柄の高クオリティの絵出てくるからマジで凄い。エロ絵解禁されたらなんぼでも出したい

NAI/Any系列かWD系列かと言われたら、NAI/Any系列だわな >>796 一生trinとwdのマージしたやつベースにsfw生成してるわ

今日突然colabでHN/TIのトレーニングできなくなったな

とりあえずtorchの過去バージョンをインストールしたら使えるようになったけど

へーtorchのバージョンでクオリティ変わったりするんだ

いや、知らない

>>799 AIに投げるプロンプトもAIに作ってもらうとすごく楽ね

AI絵師の仕事がAIに奪われるなんて

>>817 一切指示無しで寝てる間にマスピ顔のハンコを量産するだけで500円ならまぁ…と思ったけど

1枚生成に5分かけるとして500枚で作業時間42時間=2日だよ

今応募してる奴は何考えてるんだ?

>>819 >>818 破綻なしの要望に沿った絵じゃないと意味ないだろうしそれを一枚1円はAIだとしても買い叩かれてるなw

1枚1円×500はいくらなんでもないね

一つプロンプト決めて

全部別の呪文でとかでもDynamicPromptとandomiz

間を取って1枚30-50円ならいいやつ作って選別して出してくれる人いそうだな

この三か月で腐るほど出力してるだろ?

あとで何か問題発生したときに、

まあでもやるやついるだろうなあこれ

何が狙いなのかわからんな

読むべき論文は山のようにあるけど一向に読む気が起きないのです

唐突に読むべき論文がーとか言い出して対抗心見え見えなの草

そのひとつ上のレス見て思っただけだから!

>>835 生成出来るパソコン持ちで1枚1円の

>>844 Vision Transformer入門 (Computer Vision Library)

>>847 SD2.1、普通に生成すると相変わらず微妙な絵になりやすいけど >>849 >>849 colabのwebuiでのトレーニング系全部エラー出るんだけど、普通に動いてる人居ます?

いろんな拡張機能とか触れるようになって思うんだけども

>>856 導入方法まで抽象化して欲しい連中が

スレチな流れかもしれんけど

解説サイトや技術スレが立ち上がってるやろ?

>>862 >>864 そのために裁判制度がある

オープンソースって機械で言えばネジとか歯車の話でしょ(「ネジ」や「歯車」に権利があって一つの企業が独占してたら発展なんて出来ないよね)

>>847 >>864 AIイラストじゃないけどUnrealEngineやBlenderの使い方の解説を丁寧にやってたチャンネルが

使い方で万再生いったけど使ってるの数人って話に対してだろ

>>870 >>875 >>837 大事なのはDDPM(世界初のDiffusion Modelで使われたサンプラーの論文)とLDM(SDの核となっている技術)とGLIDE(Diffusion ModelををCLIPを介して動かすもの)って教えてくれた人は言ってた

GANはDMの前に流行ってた画像生成に使われてたもの

金出すよりもむしろ人力ラベリングを手伝いたいくらいだな

ラベリングは結構な部分を人力に頼らざる得ないんだよな

スコアリングのための人力点数付けはやってる

>>870 別にAIは画像だけが学習元じゃないからね

SD(とかNAI)は自動ラベリングしてるからな

(deep danbooruじゃだめですかね……?)

DBしたckptを1111に読み込ませたら

いわゆるウイルスckpt

×元になる方にも出てるなら

>>891 zipファイルが壊れてたりメモリ不足だったり原因が何であれロードに失敗すれば

>>894 >>895 >>895 >>849 わからん・・・設定に詳しい人いたら教えてほしい

>>899 >>900 >>902 スレ間違えたか

>>902 >>903 >>896 >>897 >>902 2,3日前からstabl diffusionをgoogle colabde上でトレーニングを使おうとすると

絵描きなんだけど、構図の案だしとか、完成した絵をAIで添削してもらったりして画力上げる参考にしたい。

デザインや塗りなんかは参考になるけど構図はたいしたもの出てこなくて参考にならん印象

全部試したわけじゃないから比較はできんけど、絵描きはAIを上手く使えば結構遊べる

>>914 たいした構図が出ないと言う意見が言えるのは、相当ハイレベルな絵描きか、もしくはまるでAIを使いこなせていないかのどちらかだな

ヘタクソな絵でも複雑なデザインを保ちつつ綺麗にできるか独自に調査した結果

返信ありがとう >>908 >>910 >>912 昔euler aのバッチだと再現性がないって話が出てきたときに

>>922 >>923 10月ぐらいからは生成結果が変わるような変更入る場合はオプション用意されてるだろ

9月末にはAUTOMATIC1111の生成データもメタデータ入ってるからNAI以降の人は保存されてると思う メタデータに設定が保存されてないってのは、メタデータに全パラメーター保存されてるわけじゃないって意味

>>924 >>928 >>929 prunedでも4GBあるならfp32だぞ。ファイル名にprunedって付いてても、

Anyv3のprunedがfp32で4GB、fp16で2GBだから、

>>918 車屋に行って、どれでも変わりませんかって聞くぐらい愚かな質問。

多少のプロンプトの理解力の差はあれ、どうせ良い構図が出るまでガチャるんだから

初心者向け簡単説明拾ったので貼っとくね >>936 >>936 人間が頭で描いた完成図であっても、「リスペクト」とか「パクリ」とか状況で変わるけど、

圧縮や暗号化されたデータはオリジナルを元にはしているけど意味のわからないデータになってるから

学習元が特定できるレベルで露骨にコピーして出力されるケースも報告されてるけどね

>>936 技術系の質問いいですか?

>>933 そもそも鬼滅の刃を読んだ人間の脳みその中身をくまなくスキャンしたとしても鬼滅の刃の画像は出てこないだろうな

>>944 >>942 VIDEO どんなに複雑なデジタルタトゥー施しても一回印刷してスキャナー取り込みしたら終わりじゃないのかな

スクリーンショット撮っただけで消えるなんちゃって透かしもあれば

TI学習時の画像みたいにベクトルで再構築されたら流石に消えるかデータ破損しそうだなぁ

つまりスクショ撮ってi2iなり適当なwatermark removerなりでしまいよ

スクショ撮っても残るRGB以外の情報なんか無いだろうし

>>941 ちょっと過学習気味になったかな?微調整して…というのを繰り返してるうちに自分の中の目標の絵柄が迷子になる事が多い

>>956 >>958 劣化トレース一発で出て笑った >>963 >>963 推論攻撃とかでググれば日本語でもその例みたいなの出てくる

>>963 まあムンクが出たのは見たから完全にありえないとはいえないな

ブラッドボーンってプロンプトに入れたらブラッドボーンの画像出てくるのは当たり前じゃね

>>963 アポロ計画の画像生成やると見たことある写真みたいなのばっか出てくるのと同じじゃねえの?

>>971 まあ人間だって意図せずとも丸パクしてしまうこともあるしな

この場合は「知らなかった、AIが勝手にやった」が通らないからまだいいけどね

これってプロンプトに紐付いてる学習要素が限定的過ぎるって事なんかな? 新旧拡散モデル論文目は通したけど難し過ぎて目が滑りまくって全く理解出来なかったからバイアス掛かってない説明見たい

あー、でもiPhone Case、Galaxy caseはやべーな

AMD Radeon RX 7900 XTX Radeon RX 7900 XT レビュー https://www.4gamer.net/games/660/G066019/20221212075/ Radeonいろいろ弄り回して生成できても学習できないし

AMD「CUDA実装します」

ああ、CUDAをOPEN CLに変換するレイヤーとかあれば解決・・・いや、パフォーマンス出るかどうか怪しいな。

用途不明のAIチップが搭載されているらしいがAMDだし期待度はないな……

>>931-932 >>987 xformersとFP16とvae使ってなければ基本的にはFP32だけになるのでその場合--no-halfはいらんけどな

>>983 >>985 https://gpuopen.com/orochi/ >>990 NVIDIAが主導権握るの上手いということでもあるけれど、個人が高性能PC買う時にはAIに何かさせるのを気にする時代だから、

遊んでるレイトレコアも使って欲しい、なんか利用出来るところないのかな

NVIDIAに今更パワーみたいな同じ方向で追いつけるか?

こういう場に居たりするとAI方面が重要となるけど

>>996 >>995 20年前のゲーマー「VRAM40MB揃えたぞ!」

>>974 学習素材が少ないと構図とかもまとめて物体って認識するんじゃないの

lud20230125021350ca

このスレへの固定リンク: http://5chb.net/r/cg/1669278997/ ヒント: 5chスレのurlに

http ://xxxx.5ch

b .net/xxxx のように

b を入れるだけでここでスレ保存、閲覧できます。

TOPへ TOPへ

全掲示板一覧 この掲示板へ 人気スレ |

Youtube 動画

>50

>100

>200

>300

>500

>1000枚

新着画像 ↓「【StableDiffusion】AI画像生成技術11【NovelAI】 YouTube動画>2本 ->画像>88枚 」 を見た人も見ています:・【Cintiq】WACOM 液晶ペンタブレット Part94【DT】 Poser総合スレッド Part49 MAYA 3DCG屋による雑談スレ Part30 CGアニメーション 初心者が2D・3Dアニメを作る過程を見守るスレ PainterClassic/Essentials バージョン5.0 ディテールをディティールって言う奴は大抵ヘタレw pixiv 底辺卒業スレ part114 ぼったくりWACOM断罪スレ Blender 初心者質問スレッド Part45 3ds Max初心者質問スレ Part17 【Modo】 Part44 【コミスタ・イラスタ後継】CLIP STUDIO PAINT part101 【Cintiq】WACOM 液晶ペンタブレットPart122【DT】 【Cintiq】WACOM 液晶ペンタブレットPart133【DT】 漫画制作と3DCG おまいら、一太郎と花子がお亡くなりに・・・ 2Dクリエイター友の会 Part6 CG(映像・ゲーム)会社の女性社員ってどうよ? モニターのキャリブレーション 9 3DCGソフトを比較するスレ 其の33 【液タブ】海外製ペンタブレット総合 34【板タブ】 ★☆★☆ 組織内違法コピー ★☆★☆ すばらしい絵描き()見つけたっ!4 (ワッチョイ有) お絵描きのためのパソコン相談スレ Part37 pixiv 底辺卒業スレ Part93 てすと 【解剖図】リアルな人体製作【解剖学】 ■□ちっとも上手くなんねーよ。モデリング□■2 Daz Studioスレッド Part19 ©2ch.net pixiv 底辺卒業スレ part105 3DCG作ってうpして楽しむスレ part28 【Maya】Autodesk Maya質問・雑談総合スレPart14 すばらしい絵描き()見つけたっ!4 Blender 初心者質問スレッド Part37 あなたのCG作品は、どれほどヒットしましたか? 【artist side】 ©2ch.netその2 Windowsタブでお絵描きとか語ったりするスレ Part.1 色塗りたいんですが【16色目】 【Midjourney】AI関連総合15【StableDiffusion】 [萌え]日本のデザイナ[アニメ] ★Poserフィギュア★のハァハァ画像〜其の八〜 ■どうしてCGの道に進んだの?教えて!■ 【遊友館】クリエイター通信? part1 pixivで一番絵が上手い高校生って誰なの? Blender ニュース速報 Part2 Painter総合 66筆目【ペインター】 pixiv奈落底辺スレ Part79 LightWave3D・雑談スレ89 Windowsタブで絵を描きたい人のスレ Part.2 ※絵OK CG板 自治スレッド 【Cintiq】WACOM 液晶ペンタブレットPart129【DT】 【Midjourney】AI関連総合23【StableDiffusion】 オリジナル絵描きがまったり語るスレ ペイントツールSAI 120色目 在宅でCG・漫画描いて小遣い稼ごうぜ DL数12 佐藤航陽 pixiv 底辺卒業スレ part103 RETASレタススタジオを語って下さいpart4 【Midjourney】AI関連総合19【StableDiffusion】 タイタニックって今見るとCG丸出しだね Apple Pencil Part.2 Windowsタブで絵を描きたい人のスレ Part.3 ※絵OK 俺たちの考えたオリキャラを描いてもらうスレ

05:47:36 up 31 days, 6:51, 3 users, load average: 93.80, 91.35, 85.11

in 0.024626970291138 sec

@0.024626970291138@0b7 on 021319

特にこのグラフ

特にこのグラフ