�������ȗ��R�ɂ�鏑�����݂̍폜�ɂ��āF �����p�V �Ƃ݂������:�yStableDiffusion�z�摜����AI����X��21 YouTube����>3�{ ->�摜>38��

����A�摜���o �b�b

���̌f����

�ގ��X��

�f���ꗗ �l�C�X�� ����l�C��

���̃X���ւ̌Œ胊���N�F http://5chb.net/r/cg/1703243927/ �q���g�F http ://xxxx.5chb .net/xxxx �̂悤��b �����邾���ł����ŃX���ۑ��A�{���ł��܂��B

!extend:checked:vvvvv:1000:512

!extend:checked:vvvvv:1000:512

���X�����Ď��ɂ͂����3�s�ɑ��₵�Ă�������

Stable Diffusion���͂��߂Ƃ���摜����AI�Ɋւ��鎿��p�̃X���b�h�ł��B

���X����

>>970 �����ĂĂ��������B

���₷��l�͂Ȃ�ׂ����J�����Ă�������

�E�g���Ă���A�v���P�[�V�����i1111�Ȃ�ǂ�����^����ǂ�ŃC���X�g�[���������j��g���Ă���w�K���f���L����

�E�̐����͋�̓I�ɁB�u�ȑO�ƈႤ�摜���o�͂����v�u�ςɂȂ����v�ł͉��悤���Ȃ��B�ǂ��Ⴄ�̂��A�ǂ��ςȂ̂�������

�E��G���[���b�Z�[�W�������L���v�`���摜��o�͉摜���A�b�v���[�h����B�o�͉摜��imgur�ł͂Ȃ��Acatbox�ȂǃA�b�v���[�h���ɏo�̓p�����[�^���c��T�[�r�X��

�E���[�J���Ȃ�}�V���̍\���iGPU�̎�ނ͕K�{�AVRAM�e�ʂ�C���������̗e�ʁACPU�̎�ނ��Ȃ�ׂ��j������

�e���v����

https://rentry.co/aiimggenqa ��

���O�X��

�yStableDiffusion�z�摜����AI����X��20

http://2chb.net/r/cg/1700315721/ VIPQ2_EXTDAT: checked:vvvvv:1000:512:: EXT was configured

���̔͑���������ĕK�v�Ȃ̂���

>>1 ���ł��B�������r���l������Ȃ炱�������ǂ��ł��ˁB

�����l��ܯ������肳���̌������Ȃ��A���S�҂Ȃ�Ȃ�����

�����������f���͂Ƃɂ������������l���D��ŋ������Ȃ�

����ۂǂ�܂������Ƃ��Ȃ���IP�����̃��b�`���C�ɏ����Ȃ��Ƃ��Ȃ��͂��������b�`���C���̂悭�������ĂȂ��Ɩ��ʂɌx������낤

>>5 > �A���������ɗ��Ď��₵�Ȃ����Ȃ����蓚���Ȃ����Ɓi����ɓ������Ⴄ�ƌ��nj��邾�����ė��Ȃ��̂Łj

���[��A���܂茵�������Ȃ��Ă������C������Ȃ�

����҂͊Â₩�������łǂ��ł��傤

�O�X����Hires. fix��Latent�n�͂��̂܂ɂ��S���W���M��悤�ɂȂ��Ă���ۂ�

���X����Ȑl���Ȃ��̂Ɏ����ʼn��X�L���Ă�A�킩��₷���Ăق�Ə�

�������2�����Ȃ��

>>9 hires�̏u�ԂɃu�����ĕς��̂��z���[�݂����ŕ|������

��������hires���ď��T�C�Y�Ŕ���step�܂Ő������Ă������o�Ȃ��悤�Ƀm�C�Y�Œ肵�Ă���c��step��i2i�Ŋg�傾����

>>5 ���X�������ƌ��Ď��₠�����ɗ����疳���ɖ����ނ́H

>>5 ���X�������ƌ��Ď��₠�����ɗ����疳���ɖ����ނ́H

����ł��B

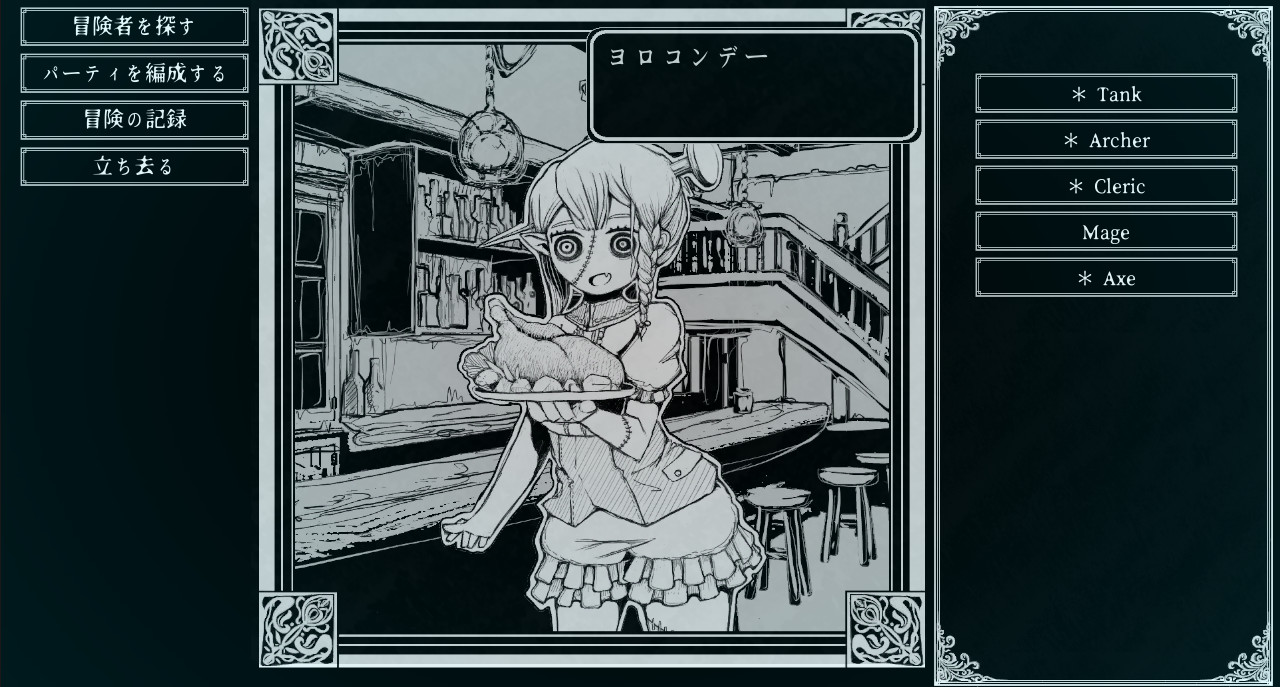

���̗l�Ȋ����̗֊s�̃��m�N���摜����肽���̂ł����v�����v�g�̎��������ŏo���܂����H

�܂��͗֊s�p��Lora�Ƃ����̕��@������̂ł����ˁB�c�[����ComfyUI�Ő������Ă��܂��B

�p�r�̓Q�[��(Path of the Abyss)�̃J�X�^���A�o�^�[�p�摜�ł��B

>>13 lineart���ɂȂ�LoRA���F�X���邩�炻��g���ĐF���������v�����v�g�ŗ}�����

������ۂ��͍̂��邯�ǂ��D�݂ɂ������ǂ����͂킩���

>>13 ���������H�݂����Ȃ̂���ˁH

https://civitai.com/models/81340 ������g���āAsketch�nlora�����p������s������

monochrome, greyscale���w�肵��

>>14 ���肪�Ƃ��������܂��Blineart����F���������������Ă݂܂��B

>>15 ����ł����������ł��B�����Ē�����Lora���g���Ă݂܂������ǂ��ł��ˁB

���낢�뎎�s���낵�Ă݂܂��B���肪�Ƃ��������܂��B

���Z�����Ƃ��남�萔�����|���������܂��B

1111�����[�J���Ŏg�p���Ă��܂��B

https://civitai.com/models/227059/fullyrealxl �@�̂悤�ȂUGB���郂�f����ǂݍ������Ƃ����

�ȉ��̃G���[�œǂݍ��߂܂���B

Failed to load checkpoint, restoring previous

Loading weights [6a5798187d] from C:\stb\stable-diffusion-webui\models\Stable-diffusion\kisaragiMix_v22.safetensors

Applying cross attention optimization (Doggettx).

changing setting sd_model_checkpoint to fullyREALXL_v30ForREAL.safetensors: RuntimeError

Traceback (most recent call last):

File "C:\stb\stable-diffusion-webui\modules\shared.py", line 483, in set

self.data_labels[key].onchange()

�����ݒ肪�K�v�Ȃ̂ł��傤���B

����������������K���ł��B

�����ɂ��̃��f���ǂݍ���ł݂��畁�ʂɎg������ł悭������Ǒ��̏d�����f���ł������Ȃ�Ȃ�O���{�̃������s���Ƃ�����

>>0018 �����

>>17 �����SDXL�̃��f��������r�f�I�J�[�h��VRAM��12GB���炢�͖����ƌ�������

SD�Ȃ�N���I�v�V������

--medvram-sdxl

��lj������������

>>20 ����

���Ԏ����肪�Ƃ��������܂��B

���\�̖��̂悤�ł��̂œ����Ȃ�������폜���ĕʂ̃��f���łƂ������ɂ��܂��B

���������������đ�Ϗ�����܂����B

�܂���������܂������낵�����肢���܂��B

>>17 Doggettx���Ă��Ƃ�COMMANDLINE_ARGS��--opt-split-attention�ɂȂ��Ă�̂��ȁH

--opt-sdp-attention

�ɂ�����ǂ����낤�H

�ꉞCOMMANDLINE_ARGS�������Ăق����A���ƃO���{���̑��̊��Awebui���ŐV���ۂ���

�����ŋ�LCM-LoRA�̐ݒ�Ђ�����l�߂Ă������̃N�I���e�B���o��悤�ɂȂ��Ă���

Sampler��Euler a�ɂ���̂���ԐL�ёオ����悤�ȋC������

�v�����v�g�͉��̂��LCM-LoRA��more_details��2�lj�����������Check Point��VAE�͓���

https://majinai.art/i/ggac9yr �Ƃ����킯�ŏ���x�̃N�I���e�B��LCM�ł��o������Č��_�ɂȂ���

LCM-LoRA�͉��G���Z���Hires�̃X�e�b�v���Z���������グ����̂��ő�̃����b�g����������

>>17 GPU�h���C�o��511.65�ŌÂ�����̂ŃA�b�v�f�[�g���Ă݂Ă͂ǂ����ȁB

536.40�ȍ~�Ȃ狤�LGPU���������g���悤�ɂȂ�̂ʼn��P���邩���B

>>23 �����ڍׂȊ����ŗǂ��ł��ˁB

>>22 ����Ȗʓ|�Ȏ�����Ă��邩

�N�\�{�P

>>24 ���P���ˁ[��

���Ԏ����肪�Ƃ��������܂��B

�UGB������̂ł��g���������������̂ł����AXL���f�����_���Ȃ̂�������܂���B

�t�@�C�����ς��Ă݂܂������_���ł����B

����PC�͂���Ȋ����ł��B

GPU 1

NVIDIA GeForce RTX 3080 Laptop GPU

�h���C�o�[�̃o�[�W����: 30.0.15.1165

�h���C�o�[�̓��t: 2022/01/28

DirectX �o�[�W����: 12 (FL 12.1)

�����I�ȏꏊ: PCI �o�X 1, �f�o�C�X 0, �@�\ 0

�g�p�� 0%

��p GPU ������ 3.8/8.0 GB

���L GPU ������ 0.1/15.9 GB

GPU ������ 3.8/23.9 GB

�m�[�g���ƌ������ł��ˁB

>>23 �����͎���X�����낤��

���₶��Ȃ��̂ŋp��

�����ŋ�LCM-LoRA�̐ݒ�Ђ�����l�߂Ă������̃N�I���e�B���o��悤�ɂȂ��Ă���

Sampler��Euler a�ɂ���̂���ԐL�ёオ����悤�ȋC������

�v�����v�g�͉��̂��LCM-LoRA��more_details��2�lj�����������Check Point��VAE�͓���

https://majinai.art/i/ggac9yr �Ƃ����킯�ŏ���x�̃N�I���e�B��LCM�ł��o������Č��_�ɂȂ���

LCM-LoRA�͉��G���Z���Hires�̃X�e�b�v���Z���������グ����̂��ő�̃����b�g����������

>>23 �����͎���X�����낤��

���₶��Ȃ��̂ŋp��

�����ŋ�LCM-LoRA�̐ݒ�Ђ�����l�߂Ă������̃N�I���e�B���o��悤�ɂȂ��Ă���

Sampler��Euler a�ɂ���̂���ԐL�ёオ����悤�ȋC������

�v�����v�g�͉��̂��LCM-LoRA��more_details��2�lj�����������Check Point��VAE�͓���

https://majinai.art/i/ggac9yr �Ƃ����킯�ŏ���x�̃N�I���e�B��LCM�ł��o������Č��_�ɂȂ���

LCM-LoRA�͉��G���Z���Hires�̃X�e�b�v���Z���������グ����̂��ő�̃����b�g����������

>>23 ���₶��Ȃ��b�͋Z�p�X�����A�Ȃ�JNVA��������ł��Ăق������ȁc

LCM�̘b��͍r�ꂪ��������\�����ӂ��Ă�

���b�`���C����͌����̍r���l��NGName�ɏo���邩�炢���ˁB

>>31 ��(ܯ��� cfbb-whC3)

�����ă��b�`���C�L��͎���������o���邩�炢�����

���o����Ɖ҂ɂ��Ȃ��Ă�

�ŏ��̕��̓z�炾���ʼnĂ�̂��悭������

16 �����������������ς��B (ܯ��� cfbb-whC3) sage 2023/12/23(�y) 01:03:34.95 ID:0DtREn2O0

>>14 ���肪�Ƃ��������܂��Blineart����F���������������Ă݂܂��B

>>15 ����ł����������ł��B�����Ē�����Lora���g���Ă݂܂������ǂ��ł��ˁB

���낢�뎎�s���낵�Ă݂܂��B���肪�Ƃ��������܂��B

>>32 ����͎������₵�đ��̂���l�̉ɑ��Ă̕ԐM�ł��ˁB

���������Ǝv���܂������X���Q�Ƃ���ꍇ�̓R�s�y���Ȃ��Ă�

>>16 �̗l�ɋL�ڂ���Ɨǂ��ł���B�r�炵�łȂ��̂Ȃ�B

�ŏ��̎��₪�g���Ƃ�

>>31 ���ɂ����͏Z�������Ȃ��̂Œ���

�l�������Ƃ��낾�Ɖ����NG����ƕ��ʂ̐l�܂Ŋ�������œǂ߂Ȃ��Ȃ�̂�

>>34 �������̃X�����Ă݂����ړI���킩��J�ߎE���U���݂����ȍr�炵�����đ�ς���������

���ʓI�ɗ����̃X���ɑ��čr�炵�Ă���y�̓��X�R�s�y��URL��NG���[�h�őΏ����邵���Ȃ������B

�����͂����ɂ������X���Ȃ��̂őo���̃X���Z���ŌX��NG�Ή��ł����ˁB

>>35 �����Ɍ��炸�����ǃ��o�C������n��NGName�ŗǂ��C�����܂��B

�����17�ł��B

�Ȃ��̂����ł����f���������Ă���܂��ł��傤���E�E�E

�\����܂���B

>>22 ����

���������H�v�ł������Ȃ��Ƃ�����Ȃ璧�킵�����ł��B

�R�}���h���C���Ƃ����̂͂ǂ����悢�ł��傤���B

>>34 �u�ŏ��̎��₪�g���v���Ă������ǂ��̍������킩��Ȃ����A���������N���u�g���v�Ƃ��Ȃ�����Ӗ��s���Ȃ��

���₵���l���ق��̎���ɉ���͕̂��ʂ̂��Ƃ���

������u���ԁv���Ȃɂ��Ȃ����A�r�炵�Ă�Ǝv���Ȃ�܂������Œ��ӂ��Ȃ�

�����������X���͂�����Ȃ̂�����A������ɗU������̂͊Ԉ���ĂȂ����

�������X���ւ̗U�����u�r�炵�v�Ƃ����Ȃ�A�������͍r�炵�����Ă��s�K�ȃX�����ƔF�߂邱�ƂɂȂ��

����Ƀ��X���A���J�[�������������R�s�y����̂��r�炵�ƌ��Ȃ������낵��

�������̃X���ɏ������݂͎~�߂�����������Ȃ�

>>37 webui-user.bat�ɋL�q����N���I�v�V�����Ȃ��ǁA�ҏW�������ƂȂ��H

webui-user.bat��google��������ƈ�ԏ�ɏo�Ă���T�C�g��������₷��

�ȃ������⍂�����ݒ��炪�ł���

3080�Ȃ�Ƃ肠����

COMMANDLINE_ARGS=--xformers --no-half-vae --medvram

�����肪�����낤���H

>>40 ����

�����Ă��������Ă��肪�Ƃ��������܂��I

�悸�O���t�B�b�N�{�[�h�̃h���C�o�X�V����2023.12.12�̕��ɂȂ�܂����B

���̌�ҏW���ċN�����܂����B

@echo off

set PYTHON=

set GIT=

set VENV_DIR=

set COMMANDLINE_ARGS=--xformers --no-half-vae --medvram

call webui.bat

�N���̍ۈȉ��̏�Ԃŗ����オ��܂����B

Launching Web UI with arguments: --xformers --no-half-vae --medvram

Additional Network extension not installed, Only hijack built-in lora

LoCon Extension hijack built-in lora successfully

[-] ADetailer initialized. version: 23.9.1, num models: 9

ControlNet v1.1.201

���̌����̕���ǂݍ��݂܂������܂����������^�C���G���[�ƂȂ�܂����B

>>23 �^���Ă݂����ǁA������ƃ}�V�ɂȂ銴������

�ǂ����Ă�LCM���L�̃{���b�Ƃ����͕̂ς��Ȃ�

�ł����p���͏オ��������T���N�X

>>41 ���[��킩��Ȃ�

safetensors�t�@�C�����j�����Ă���Ă��Ƃ͂Ȃ��H��DL����Ƃ�

�t�@�C�����ύX�������Ă��Ƃ����ǁA�擪�Ɂu_�v���Ă݂���ǂ��Ȃ�H

���Ƃ܂������ĂȂ����ǂ܂���webui�̃o�[�W������1.5�������Ă��ƂȂ���ˁH

�����VRAM8GB��SDXL�͂����̂��ȁAComfyUI�Ȃ�s����炵������

�ł����f���I�Ԃ��Ƃ��炢�͂ł����������E�E�E

>>43 ���Ǔ������ˁ[����[��w

�����ŗV���Ă��炤��

���O�������X���r�炵�Ă邵���f�ł����ɗ��邵���Ȃ���〜w

43 �����������������ς��B (ܯ��� cf1d-y73S) 2023/12/25(��) 20:07:47.45 ID:RecO/8Ju0

>>41 ���[��킩��Ȃ�

safetensors�t�@�C�����j�����Ă���Ă��Ƃ͂Ȃ��H��DL����Ƃ�

�t�@�C�����ύX�������Ă��Ƃ����ǁA�擪�Ɂu_�v���Ă݂���ǂ��Ȃ�H

���Ƃ܂������ĂȂ����ǂ܂���webui�̃o�[�W������1.5�������Ă��ƂȂ���ˁH

�����VRAM8GB��SDXL�͂����̂��ȁAComfyUI�Ȃ�s����炵������

�ł����f���I�Ԃ��Ƃ��炢�͂ł����������E�E�E

>>43 ����

���́E�E�E�Ռ��̎���������������ł����E�E�E

�o�[�W������1.1�Ə����Ă���܂����E�E�E

���ׂ�1.7�ɃA�b�v�f�[�g������ǂݍ��߂܂����B

�����E�E�E�p���������E�E�E

�e�g�ɂȂ��ċ����Ă������������ɐ\����܂���B

�{���ɂ��肪�Ƃ��������܂����B

�݂Ȃ����

���X�R�s�y��ID�R���R���N������̂��ȁc�Ȍ�NG�ŁB

>>46 �������ėǂ������ł��ˁB43�̃G�X�p�[���X�i�C�X�B

��������������H

�����v���H

�������ɍr�炵���������炱���ɗ��邵��〜������〜

��������悱�̑ʕ�

�u�ŏ��̎��₪�g���v���Ă������ǂ��̍������킩��Ȃ����A���������N���u�g���v�Ƃ��Ȃ�����Ӗ��s���Ȃ��

���₵���l���ق��̎���ɉ���͕̂��ʂ̂��Ƃ���

������u���ԁv���Ȃɂ��Ȃ����A�r�炵�Ă�Ǝv���Ȃ�܂������Œ��ӂ��Ȃ�

�����������X���͂�����Ȃ̂�����A������ɗU������̂͊Ԉ���ĂȂ����

�������X���ւ̗U�����u�r�炵�v�Ƃ����Ȃ�A�������͍r�炵�����Ă��s�K�ȃX�����ƔF�߂邱�ƂɂȂ��

����Ƀ��X���A���J�[�������������R�s�y����̂��r�炵�ƌ��Ȃ������낵��

>>34 �������̃X�����Ă݂����ړI���킩��J�ߎE���U���݂����ȍr�炵�����đ�ς���������

���ʓI�ɗ����̃X���ɑ��čr�炵�Ă���y�̓��X�R�s�y��URL��NG���[�h�őΏ����邵���Ȃ������B

�����͂����ɂ������X���Ȃ��̂őo���̃X���Z���ŌX��NG�Ή��ł����ˁB

>>35 �����Ɍ��炸�����ǃ��o�C������n��NGName�ŗǂ��C�����܂��B

1111��hires����extra�ɏ���ɗ����Ă������@�Ȃ��H

>>49 �ˁ[��

�����ō��

LCM���g�����Ȃ���z�ɂ͕K�v�ˁ[��

�������Ɛ��������

�u�ŏ��̎��₪�g���v���Ă������ǂ��̍������킩��Ȃ����A���������N���u�g���v�Ƃ��Ȃ�����Ӗ��s���Ȃ��

���₵���l���ق��̎���ɉ���͕̂��ʂ̂��Ƃ���

������u���ԁv���Ȃɂ��Ȃ����A�r�炵�Ă�Ǝv���Ȃ�܂������Œ��ӂ��Ȃ�

�����������X���͂�����Ȃ̂�����A������ɗU������̂͊Ԉ���ĂȂ����

�������X���ւ̗U�����u�r�炵�v�Ƃ����Ȃ�A�������͍r�炵�����Ă��s�K�ȃX�����ƔF�߂邱�ƂɂȂ��

����Ƀ��X���A���J�[�������������R�s�y����̂��r�炵�ƌ��Ȃ������낵��

�r�炵�K�C�W�̂��O�ɕ����ĂȂ���

>>46 �悩����

����������XL���Ă�����f�t�H�ł����Ȃ�g���������H���ĂӂƎv�����̂�

>>49 batch�ł܂Ƃ߂Ă��炢�����v�����Ȃ��At2i��i2i�����Ȃ��Ȃ����

������ƌ���������

https://github.com/nefudev/sd-webui-auto-operation ����Ȃ̂��������A�������c�[���Ŋg���ł͂Ȃ��Ƃ̂���

6�����O�Ɏ~�܂��Ă邵�A�Ȃ�������E�E

> �I���W�i���̎������������쐬���邽�߂ɂ́AjavaScript �̒m����������x�K�v�ł��B

���ƕ��ʂɂ��Ƃ�����ComfyUI�őg�ނ��炢��

�Ă������͂��̃K�C�W�̊u���X����������

���Ƃ͓S��autohotkey����

>>47 ����

>>52 ����

���Β��߂Ă��܂������A�����Ă݂Ă悩�����E�E�E

�{���ɂ��肪�Ƃ��������܂����I

>>55 ���������悤�ł悩������

�����͐L�ш����Ǝv�����Ȃ�������܂����Ă����

>>28 >>30 �O�X��124��

> LCM�̃A�j���G

> �x�^���Ƃ����h��͍s���邯�ǁA�����Ȃ͍̂Č���������

>

https://civitai.com/images/175093 > ��������������

�Ƃ���v/HOzmWw��

https://majinai.art/i/ggac9yr ���o���Ă͍Č��o����̂��H���Ė₤�Ă�������

>>23 �͂���ɑ���Ȃ�

���Ȃ݂ɏ�̌��G��AbyssOrangeMix3���f����҂̃T���v���摜�œ����V�[�h�l�ł͍Č��o���Ȃ��Ə����Ă���i���͋C�͍Č��j

https://civitai.com/models/9942/abyssorangemix3-aom3?modelVersionId=17233 ������V�[�h�ς���Ό��G�ɂ�����x�߂��\�}���o�Ă���

����ł�LCM�̓x�^�b�Ƃ����h�肵�������Ȃ��Ƃ��ʂ����悤�Ȃ��������ɂ���C�͂Ȃ�

>>55 CPU����GPU������ꍇ�̓��C����CPU����GPU�ɂ��āA�O���{��SD ��p�ɂ����GPU�������҂����😁

���̃X���ʼn��Ȃ������̂ł�����Ŏ��₳���Ă�������

�ق��̂ǂ̃X���Ŏ��₵���̂���?

>>59 facedetailer�̐ݒ�͂ǂ�Ȋ����H

>>59 https://github.com/daxthin/DZ-FaceDetailer ���Ԃꂾ���

�ݒ�ł���p�����[�^�ɂ͂ǂ̂��炢�̃T�C�Y�܂Ō��o���邩�͂Ȃ��݂��������

https://github.com/ltdrdata/ComfyUI-Impact-Pack ������͂ǂ�������

���̉摜�������ƌ������������ǁA�����悤�Ȃ��Ƃ��ł������ȋC������

���o�����̃T�C�Y���ł��邩�͂킩��Ȃ�����

>>60 >> 61

>>62 Detailer�̓_�u���N���b�N����Search��"FaceDetailer"�ƕ\�����ꂽ���̂��g���Ă��܂�

�����炭Impact-Pack�̂��̂���

�ǂ�����LoRA��K�p�����Ƃ��ɂ��܂������Ȃ��݂����ł�

��r�摜���グ�܂������A��LoRA�K�p���̐����ō�����

Detailer���� �b Detailer�L�� �b Detailer���̂�LoRA��K�p���Ȃ� �b WebUI��ADitailer�L��

WebUI�͓�Seed�ł��Ⴄ�摜���o��̂ŁiWas�Ȃ�����Ă��܂���j

�����Ȋ�̉摜���r�Ƃ��ďo���Ă��܂�

LoRA�g���Ă��̂��炢�Y��ɏo�Ă����Ɨǂ��̂ł���

https://imgur.com/a/EG0jwXQ https://imgur.com/a/Dym0MnP BingImageCreator�̂��ƂŎ���Ȃ̂ł����A�_��̃��m�i���A�ނ�ƂȂǁj�����������

>>64 �J�X�^�}�C�Y�s��Bing�ł͖���

���݂�AI�͌��X�����������̂𐳂����F���ł��Ȃ�

>>64 �܂��A��Ƃ��Ắu�������`��v�Ƃ��u�������\���v�Ƃ������Ƃ�����ƃ}�V�ɂȂ�

���Ƃ͕��̂̌`��̓t�H�g���A���̕�������

�C���X�g�n�̓f�t�H�������p�[�X�������Ă�̊w�K�����肵�Ă��ŁA���������_�Ƃ��Ęc�݂₷��

����͋|������

>>63 �T���v�����������L�`���ƌ����Ă���悤�ɂ݂��邪�cLoRA����̕��͖ڂ̊Ԋu�������Ȃ��Ă邵

Detailer �� ����l�̍D�݂̊�ɕς��鎖���ł���c�[���ł͂Ȃ��āA�����摜�ɑ��Ċ炪���������ɂ�������ƂȂ��Ă��܂��Ċ�Ɍ����Ȃ����̂����̃��f���ł����Ƒ傫�ȃT�C�Y�ŏo�����Ƃ��̉摜�ɍ����ւ���@�\�����炻��Ȃ��̂ł́H

�ł��邱�ƂƂ����A�傫�߂̊�ł��Ȃ�ׂ� Detailer �ŏC�����Ă��炤�悤�� guide_size ��512�Ƃ��ɂ����肷�邭�炢��

�����̃t���[�͂��ꂾ�� �܂� ���ʂ͂���܂�ς���Ǝv��

https://comfyworkflows.com/workflows/2b0434a6-9e2d-4417-a5b8-d93bbe777530 >>67 ���[�N�t���[���肪�Ƃ��������܂�

�D�݂��ǂ����ł͂Ȃ��ALoRA��K�p�����Detailer�̌����������Ȃ�Ƃ����b�ł�

�F�X���������ʁALoRA����߂���Y��ɂł��܂���

LoRA�̌����ڂ��Ȃ��Ȃ�̂ňӖ����Ȃ��Ƃ����W�����}

�ŋ�Stable diffusion��1111�Ŏg���͂��߂����S�҂ł��B

>>69 ���̌��摜�Ɉ��������Ă̂��肵���w�i�̂��āA�L���������͗��z�I�ɍ���Ă��ˁH

�ۑ����ĉ摜���E�N���b�N���ĂRD�y�C���g�ŊJ���ĂȂ��}�W�b�N�Ől��������ʂ���

>>65 >>66

���X���肪�Ƃ��������܂�

����ł͂܂��s���ӂȕ��ނȂ�ł���

>>70 ���X���肪�Ƃ��������܂��B

�Ⴆ�����Ŏ��Ƃ��Ă��鏗�̎q�̉摜���~�����Ƃ��āA�f�ނƂ��Ă͎��Ƃ��Ă��鏗�̎q�̓��߉摜������Ƃ��ɁA

Controlnet�ɓ��߉摜�������classroom�Ȃǂ̃��[�h������Đ������Ă銴���ł����A���ꂾ�Ƌ��������܂��o�Ă��Ȃ��Ƃ��������ł��B

���݂̐���AI�̋Z�p���ƁA���̎q���{��ǂ�ł��邭�炢�̉摜�Ȃ��ꂻ�������炻������܂��ʂɂ������w�i�ƍ�������݂����ȕ��@�����Ȃ���ł����ˁH

�G�̕ҏW�Z�p���ア�̂ł��̕ӂ����܂��ł�����@������Η��z�������̂ł����ǁE�E�E�E�B

>>69 ����́H

������90���ŏ��S�҂ł�stable diffusion���}�X�^�[!!�g�������}�l�^�C�Y�̕��@��OK!

VIDEO 1,�_�l�ԂŃ|�[�Y�����ς�������L�����쐬

>>72 ���������̂ł����́H

���R�p�[�X����Ȃ����ǁE�E

���邢��

�����H

>>76 ����͉E�̉摜��i2i���č��̉摜���o�͂����̂���

denoising strength���グ��p�[�X�������Ă�����

�����Ȃ��Ă���ƁA�ǂ̂��炢������Ƃ����\�}�̉摜���~�������̃C���[�W���������莝�K�v�����肻����

>>75 1���ڂ̎G�R���ł�2,3���ڂ��o��

�L�����̓��ꐫ�����������A����img2img�ɂ͏����̃v�����g������ĂȂ�����A�����ɂ�����ۂ����������قړ���ɂȂ�̂ł́H

>>72 controlnet�͕������̉摜�Z�b�g�ł��邩��A

controlnet1�ɋ����Acontrolnet2�ɏ��̎q��

�Z�b�g�������

��ɃZ�b�g�������������ł�

���Ƃ�control weight�������Č��������������

���G�Ɉ���������͔̂�����Ȃ�����A

������ŐF��ȃ|�[�Y���o�������Ȃ�

���̊��Lora��邵���Ȃ�

>>71 �R���g���[�� �l�b�g�ƃ��[���� Photoshop ��g�ݍ��킹��

�݂Ȃ��X���肪�Ƃ��������܂��B�Q�l�ɂ��Ă�����Ă݂܂��B

�yStableDiffusion�z�摜����AI����X��21

http://2chb.net/r/cg/1703250505/148 ���������ƂȂ�

�ŐV�iv22.4.0�j����Ă����ʂ�5_xxx girl�Œ��g�͊w�K�摜20����5�s�[�g�œ�����

���Ƌ�̓I�ȃG���[�����������Ȃ��ƈӖ����Ȃ��A�����Ǐ���Đl��blog���ł���Γ\����

��������{�I�Ȃ��ƂȂ�ł����ALora��K�p����ƃ��f���ɂ���Ă͊G�����ς������A�摜������Ă��܂����肵�܂��B

�����܂���AStable Diffusion1.5�̘b�ł��B

��������̂�Lora������C�ɓ���Ȃ��v�f������Ȃ�

>>85 ���肪�Ƃ��������܂��B

��͂肻���������̂Ȃ̂ł��ˁB

�C�ɓ��������f�������Ă���肽��lora�Ƒ����������ƂȂ��Ȃ���ς��c

>>83 lora �̓K�p�� 0.5 �Ƃ��ɉ�����Ƃ�

>>83 �ŏ��K�r�K�r�ɂȂ��Ă��[����ĂȂ���

lora block weight���Ă̂��g���ƁA�����܂ł͂����Ȃ����ǂ��Ȃ萧��ł���

>>86 ���ꂪ�d�����Ȃ��̂�

���[���̋��x��������Ƃ����Ȃ��Ƃ����Ȃ�

>>64 �������炢���猕�͉����܂Ƃ��Ȃ̂��o�Ă���悤�ɂȂ������A�ނ�Ƃ͂܂������

A1111��1.7�ɂ�����G���[�ł邩��1.6�ɉ�����������

>>91 git clone����C���X�g�[�������̂Ȃ�git checkout�R�}���h�Ńo�[�W������߂����Ƃ͂ł���Ǝv�����ǁA�ݒ�t�@�C���̐��������������Ȃ邱�Ƃ��l����ƁA�ʂ̃t�H���_��1.6���C���X�g�[���������̂��m������Ȃ����Ȃ�

1.6�͂���������_�E�����[�h����zip���𓀁Awebui-user.bat�̓��e�����܂ł̂Ɠ����ɂ��Ď��s����C���X�g�[�������

https://github.com/AUTOMATIC1111/stable-diffusion-webui/releases/tag/v1.6.0 �g���@�\��extensions�t�H���_���ړ����邾����OK

���l��models�Aembeddings�Alog�Aoutputs�̊e�t�H���_�ƁAstyles.csv���㏑���ړ�����悢

�������1111���C���X�g�[�����ꂽ�t�H���_�̃��[�g�ɂ���

�ݒ��config.json��ui-config.json�ɏ�����Ă��邯�ǁA�o�[�W�����Ⴂ�̐ݒ�t�@�C��������1.7�̃t�H���_����1.6�̃t�H���_�ɂ��̂܂܈ړ�����Ƃ悭�Ȃ����Ƃ��N������

WinMerge�̂悤�ȃe�L�X�g��r�\�t�g���g���āA1.7�̐ݒ�l�̂����K�v�ȕ���������1.6�ɓ]�L������@�������Ǝv��

�Ƃ����1.7�łǂ�ȃG���[���o���? ���܂ł�1.6���g��������킯�ɂ������Ȃ����낤����A1.7�ł̃G���[���������邱�Ƃ��l������

>92

>>93 LoRA���ꕔ�����F������Ȃ��̂͌������������������C������

���������̏Ǐ�ɓ����������Ƃ�����B�ǂ�����ĉ��������������ȁc

���͈ꗗ�ɏo�Ă��Ȃ�LoRA�ł��v�����v�g�ɏ��������Ɣ��f�����̂��

��������checkpoint��ʂ̂ɐ�ւ��Č��ɖ߂��Ƃ����ƕ\�������悤�ɂȂ邱�Ƃ�����Ƃ��A1111���ċN������ƒ��邱�Ƃ�����Ǝv����

�����Ă݂Ă�������

>94

>>87 >>89

���肪�Ƃ��������܂��I

���x������ƍ��x��lora�œK�p�������|�[�Y�Ƃ��L�����Ƃ����痣�ꂿ�Ⴄ��ł���˂��c���܂������Ȃ�����ł��B

>>88 ������ƒ��ׂĂ݂܂������~�����������ł��B

���������Z�p��g�ɕt�����璧�킵�Ă݂܂��B

���肪�Ƃ��������܂��B

�����ЂƂ̎���X����158�ł�

>>96 ����ȒP�ȒP

�Ƃ肠�����u�炾�������ă��f���̓������o�������v�Ƃ���

�@lora block weight�����

https://github.com/hako-mikan/sd-webui-lora-block-weight �Aaaa,<lora:aaa_v10:1>��

aaa,<lora:aaa_v10:1:lbw=1,0,0,0,0,0,1,0.3,1,1,1,0.8,0,0.4,0,0,0>�ɂ���

�iLora�̊畔���������o���đ��̕����̉e������邩���炷�j

���ꂾ������

https://sorenuts.jp/751/ �����Ⴒ���Ꮡ���Ă邯�ǁA

����1,0,0,0...�݂����Ȓl���e���v���ɂ��āA���ꂱ�꒲�߂��Ďg������������Ă邾��

���ۂ͊炾�������Y��ɕ�����Ă�킯����Ȃ��̂ł�����Ƃ����������邯�ǁE�E

>>97 �����Ă邩�킩��Ȃ�����

https://github.com/bmaltais/kohya_ss/blob/master/docs/config_README-ja.md > �܂����ӓ_�Ƃ��āA image_dir �ɂ͉摜�t�@�C���������ɒu����Ă���p�X���w�肷��K�v������܂��B

> �]���� DreamBooth �̎�@�ł̓T�u�f�B���N�g���ɉ摜��u���K�v������܂������A������Ƃ͎d�l�Ɍ݊���������܂���B

> �܂��A5_cat �̂悤�ȃt�H���_���ɂ��Ă��A�摜�̌J��Ԃ��ƃN���X���͔��f����܂���B

> �������ʂɐݒ肵�����ꍇ�Anum_repeats �� class_tokens �Ŗ����I�Ɏw�肷��K�v�����邱�Ƃɒ��ӂ��Ă��������B

�悤�́u10_am�v����Ȃ��A�u10_am girl�v�Ƃ��ɂ��Ȃ���

�\���Ă��ꂽcmd�̉摜���ŁA���ʂ�

�uclass_tokens: aaa girl�v�Ƃ��Ȃ̂�

�uclass_tokens�F None�v�ɂȂ�������Ă�̂ŁA�������Ȃ��Ȃ��Ă�̂ł͂Ȃ�����

>>99 ���肪�Ƃ��������܂�

Kohya�T���v���̃J�G���Ŏ������Ƃ��́u20_usu frog�v�Ƃ��Ă��܂�����

�����悤�ɖ������ł���

>>100 caption��txt����ؗp�ӂ���Ȃ��Ȃ�Ă��Ƃ͂Ȃ���ˁH

�����t�H���_��1.jpg�ɑ��Ă�1.txt�Œ��ɂ���tag���[�h������ł�t�@�C��

>>101 10_am �̂Ƃ���txt�`���ŗp�ӂ��Ă��܂�����

�J�G���̂Ƃ��͗p�ӂ��܂���ł���

��� 10_am girl �Ƃ��Ă�����x�����Ă݂܂��I

�v�����v�g��

>>103 (abc:1.2)�̊��ʂɑ��āA�P�ɕ����Ƃ��Ắu(�v��u)�v����ʂ���L��

akagi_\(kancolle\)�Ƃ�

danbooru�^�O���uakagi_(kancolle)�v�Ƃ��Ŕ����������̂ŋ���Ȃ̂��ȁH

>>101 �ʖڂ��A�u10_am girl�v�ł��ς�炸�ł����c�c

>>105 �����悩������Lora�t�H���_�ɂ���json�t�@�C���i�w�K�J�n���ɐ��������ݒ�j��

�ǂ����̃A�b�v���[�_�[�ɂł������Ă݂�

��x�ǂ������ݒ�ł���Ă�̂��m�F�������A�������݂�����cmd��ʂ̉摜���ƍׂ����Ƃ��땪����Ȃ��̂�

�w�K�摜�͕ʂɂȂ��Ă������̂�

>>104 ���肪�Ƃ��������܂�

�J�b�R�̃G�X�P�[�v�����Ƃ��Ă����Ă��ł���

>>107 �ނށA�ꏊ��������Ȃ�

json�t�@�C���͂ǂ��ɐ�������܂����H

>>109 https://note.com/hcanadli12345/n/nacbb6dd31de6#cf5aa29f-5a79-48b9-a05d-a8d724953140 > �ۑ��ꏊ�́A\Packages\kohya_ss\presets\lora\user_presets �������߂��܂��B

�uConfiguration file�v���ĂƂ���J���Ĉ�xsave�����������ȁE�E

�ȍ~�����ƍ����̂ōŏ��ǂ���������Y�ꂽ��

�����̓v���Z�b�g�Ƃ�����܍l���Ȃ��̂ł킩��₷���悤�ɏ����Lora�̏ꏊ�ɂ��Ă������A���߂�

>>110 ������GUI�ł͂Ȃ��̂Őݒ肪�o������̂Ȃ̂����������Ă��܂���

�Ƃ�����Paperspace�ł�GUI�g�����肷���ł���

���╁�ʂ�GUI��kohya_ss�����[�J���ł���Ă�Ǝv���Ă���E�E

paperspace�Ƃ�colab��CUI�x�[�X�͒m��Ȃ��̂łǂ��܂œ������邩�킩��Ȃ�����

--dataset_config�Ŏw�肵�Ă�

dataset_config.toml���Ă̂͂����Ɛݒ肵�Ă�H�Ƃ����璆�g��\���Ă݂Ă�������

https://github.com/kohya-ss/sd-scripts/blob/main/docs/config_README-ja.md �̈�ԏ�̂��

paperspace�ł��ď����Ă��ˁE�E�}�W�ł��߂�

�܂Ƃ��ɕ���������Ȃ��ǂ݂����Ȃ��̂ɗU�����Ă܂Ŗ����ɓ����悤�Ƃ��邩�炾��

>>113 �����A�F�X���ɂȂ肻���ȂƂ�����w�E���Ă��������������ł�

���_���i���̂ł��肪�����ł�

�ŁA��قǂ�蒼�����疳����LoRA�Ƃ��ċ@�\������̂��o���܂���

�����͎Q�l�ɂ����T�C�g�̏�Â��A�킴�킴�Â��o�[�W������

torch��xformers���C���X�g�[���������Ă������Ƃł���

������WebUI�Ɠ������Ŏ��s���Ă݂���o���܂���

�{���ɏ�����܂����B���肪�Ƃ��������܂�

���������A���ږ��ɗ��ĂȂ��Ă����܂���E�E

kimono�Ƃ��a���n�̃v�����v�g�����Ɣw�i���A�W�A�n�ɂȂ�̉�����������ǂ����Ă���܂����H

>>117 negpip�͂ǂ����ȁH

https://github.com/hako-mikan/sd-webui-negpip 1girl,kimono,(asian, shouji, tatami:-1),

���Ǝg�������ƂȂ�����LECO���Ă̂�����炵��

https://github.com/p1atdev/LECO >>118 �����I���S�ɃN���A���Ă�I����͂������̂�

�����Ă���Ė{���ɂ��肪�Ƃ�

SD���[�J�����ʼn摜��100���������Ă��̊ԂɑO�ɐ�������100�����m�F���J��Ԃ��Ă���ǁA�Đ����n�߂���O�̉摜��seed�l�͊m�F�ł��Ȃ���ˁH

>>120 �m�F����O�ɂƂ肠�����S�����O�ɕۑ�������H

>>120 �u�m�F�v�̈Ӗ������܂����킩��Ȃ����ǁA�f�t�H�Ȃ�t�@�C������seed�������ĂȂ��H

> 00000-1098224275-1girl,black hair,blue eyes,.png

����1098224275��seed

�isettings�œƎ��ɕς��Ă���o�Ȃ����ǁj

���Ɖ摜����chunk�ɂ����L������Ă�̂ŁAPNG Info�ɉ摜�˂�����o�Ă����

���邢�͑O��100���S���ꗗ�Ŏc���āA�������Ƃ�����x�J��Ԃ��������ĈӖ��H

http://2chb.net/r/cg/1703250505/174 >�㒅�̎w��,���̕��̎w��, �Ə����Ă��A���邢�͒����Łu�ޏ��̓R�[�g�̉��Ƀs���N�̃u���E�X�𒅂Ă���v���p���ł���Ă��A�ǂ���ł��㒅����������₷��

>���̕������������Ȃ���Ώ㒅�͒��邯�lj��������_���i�Ƃ������|�C���j�ɂȂ�

>�ȂK�ȕ��͂̓��������܂��H

����Ȋ����ł����́H

>>123 �͂��B�R�[�g�̐F���w�肵�����ł��i�����F�ŏo�Ă�̂Ŏw�肳��Ă�Ƃ͎v���܂����j

>>124 ���ɕςȂ��Ƃ͂��ĂȂ��āA�l�K�͂������ʂ̂ł����

�|�W��

1girl,blonde hair,brown coat,(pink blouse:1.2),blue eyes,thigh gap,cowboy shot,(hat,bow,collarbone,turtleneck:-1),

��̃��X�ŏЉ��negpip��

bow,collarbone,turtleneck

�Ƃ��邱�ƂŁA�^�[�g���l�b�N��L���~�\�[������������A�傫�ȃ��{����}�~���ău���E�X�Ɋ�

�ihat��cowbow shot�ł�cowboy hat�}�~�j

�E�E�����܂ł��ƂȂ��������H�ʼn������\�}�ɂ��Ă��邱�Ƃ������̂�thigh gap�Ŗ�������ʌ�����

����cutoff��

blonde,brown,pink,blue

�ƐF�w�肵�Ă܂�

���f����mixtapeSalsa_v10FusOBakedVAE.safetensor�����ǂǂ�ł���������

����cutoff��

https://github.com/hnmr293/sd-webui-cutoff ����

�P��enable���Ă��珇�ԂɐF��`�������ŊȒP�ł�

���[�J��SD1.5�ł�

�v�����v�g�� (long pleated skirt:1.3), Middle School,�l�K��(thighs:1.3)������

������100%�~�j�X�J�ɂȂ����Ⴂ�܂�

���͂����L���̒��̓��������Č����������l�Ȃ̂Œ����X�J�[�g���o�������������Ă�������

�X�P�o���Y���܂Œ����ƕ|���̂�

����Ȋ����ł�

https://jocr.jp/raditopi/2022/05/30/430220/?disp=photo&item=2 >>128 �u���[�J��SD1.5�v���Ǝg���Ă���A�v���P�[�V������checkpoint���悭�킩��܂���

�~�j�X�J�ɂȂ����Ⴄ�摜��

https://catbox.moe/ �ɏグ�Ă��炦��ƃ_�E�����[�h����PNG Info��������̂ʼn��₷���ł�

>>129 ��

���Ƃ�����Ȋ����łǂ��ł��傤�B�摜��PNG Info�Ƀh���b�O&�h���b�v����Ɛ��������m�F�ł��܂�

�Ƃ����Ă��v�����v�g�́u1girl, school uniform, long skirt, �v�����ł��B�l�K�e�B�u�v�����v�g��mini skirt�Ȃǂ͓���Ă��܂���

�g�p���f����nostalgiaClear V2�ł�

>>128 �o���������ǁA�C����2���ׂ�Ɛ擪������܌����Ȃ����Ƃ�����

�����������Ă�T�C�g�����������ǎ��O

�~long pleated skirt

��pleated long skirt

��long skirt,pleated skirt

������Ɛ��т������̂�pleated skirt�Ƀ~�j�X�J�[�g�������܂܂�Ă�H

���̂ł����܂Ƀ~�j�ɂȂ�̂�negpip�őʖډ�������Ȃ�

pleated long skirt,(mini skirt:-1)

�Ƃ����낤��

�F�l���肪�Ƃ��������܂�

�܂����̏���܂�ɂ����Ȃ����܂������Ƃ����l�т��܂�

>>130 �����G���Ƃقڂقږ��Ȃ��̂ł����֎q����ɍ������r�[�Ƀ~�j�ɂȂ�悤�ł�

>>132 pleated �͒��߂� negpip���������Ă݂܂���

���f���͂������̑g�ݍ��킹�Ŏ��s���낵�Ă����Ԃł�

�i���� 12yo �� loli �͌����ă������o�������̂ł͂Ȃ������Ɍ����ڒ��w��N�����~���������ł����j

>>133 ���[��A���̂��炢���낤���E�E�F�����܂����A���߂̎w��͈����������Ȃ̂ŊO����

classroom�Ƃ�blazer��mini�v�f���܂܂ꂿ����Ă�̂�������Ȃ�

���ƃ��f�����킹������Ȃ��ǁA�ȂႤ��

>>134 �����I

������ƍ���̂͒��߂ė��������肵�Ă��̂ł�������ƒ����Ȃ����Ǝv�����甪�ڗl��������

�~�j����Ȃ��I�Ǝv������G�p����������

�Ə��X�ϋl�܂��Ă����̂ł���

�v�����v�g�����̂܂g�킹�Ă����������疳���S���S���ŏo��悤�ɂȂ�܂���

mini�v�f�����荞�ނƂ������蓾��̂ł���

�����玩���Ƃǂ��Ⴄ�̂��Ƃ����̃V�`���ł�������̂��Ƃ����i���Ă����܂�

���肪�Ƃ��������܂���m(_ _)m

long pleated skirt�ł͂Ȃ��āA(long skirt, pleated_skirt:1.3) �Ƃ��Ă݂�

>>136 ���ۂ���Ă݂���킩��

���������i�͕�����h�Ȃ��ǁA���肪�����

> �o���������ǁA�C����2���ׂ�Ɛ擪������܌����Ȃ����Ƃ�����

��������skirt with pleats��long�̏�ԁA���邢��pleats and long��skirt���Ă����Ӗ�

���[�J���ʼn摜����� PC �������Ă��炸

N�����摜����AI�T�[�r�X��

�摜�̊�����o���Đ蔲�������̂ŁA

1111��1.6.1�ŁATrain��Preprocess image�ŁA

auto focal point crop���I���ɂ��āAPreprocess���s���܂������蔲���܂���ł����B

�G���[���b�Z�[�W�́A

cv2.error: OpenCV(4.8.0) D:\a\opencv-python\opencv-python\opencv\modules\dnn\src\net_impl.cpp:279: error: (-204:Requested object was not found) Layer with requested id=-1 not found in function 'cv::dnn::dnn4_v20230620::Net::Impl::getLayerData'

������l����������Ăق����ł��B

>>142 1.6���ƂȂ��

1.7�ŏC�����ꂽ�Ƃ��Ȃ�Ƃ�

https://github.com/AUTOMATIC1111/stable-diffusion-webui/pull/14121 1.7�ɂ��������Ȃ������炱���炩�ȁH

https://github.com/AUTOMATIC1111/stable-diffusion-webui/issues/11727 > If you are running the extension ControlNet, it will uninstall OpenCV-Python 4.7 and install 4.8. I fixed this issue by:

> Turn off ControlNet extension in Webui

> Uninstall OpenCV-Python 4.8

> Install OpenCV-Python 4.7.0.72

> Then I ran launch.py and training with face focal point is running.

>>143 ���肪�Ƃ��������܂��B1.7�ɏグ����ł��܂����B

Auto focal point crop�͊�𒆐S�ɐ���킯�ł͂Ȃ���ł��ˁB�̂𒆐S�ɐ��銴���ł����B

3D�E�߂Ɋւ��Ă͂�������ԃ��A��������

�E�����邵AI�ʼn摜���ς��\����

�����ȃT�C�g�����Ă݂���

�����͋������Ďg���Ă��ǂ����x����

https://generateimage.app?reff=7dfe6a84-94eb-43c2-9bef-e87c97a98a83 ComfyUI��webUI��lbw�ŊK�w���Ƃ̌����������Ă���lj���������������l�����狳���Ăق���

lora�̊炪�Ƃɂ������Ȃ��Ŕ��^�╞�����͎���̂Ȃ�łł����ˁH�H

���A���n�Ȃ�炾���w�K������lora�������Ă����Ȃ��Ɩ�������ˁH

���m�l��asian�Abrown_eyes�Ŋw�K���Ă��A�����̊O�l��ɂȂ����肷���ˁ@����s�v�c

��149

���Čn���f���ŃA�W�A�n���w�K������Ƃ��܂Ɂu���Ă��H�v���ē˂����݂����̂��o�₷���C������

>>151 ���A���n�͂��Ȃ�n���x�グ�Ȃ��Ɖ𑜓x�Ⴄ�R���摜�ɂȂ�����A�炪��������A�̂ƃX�P�[��������Ȃ��w���e�R�w�K�ɂȂ邩�璍�ӂ���

�A�j���n�Ȃ瑽���o�����X�������Ă��C�ɂ��Ȃ��l����������

�Ō��L����lora�ɕ\��nlora�����Ă�

�\��d���Ȃ�L����LoRA�̋��x����߂邩LoraBlockWeight�Œ������邩����

�L�����̊�Č����鎞�_�ŁA�\��L����Lora�Ɋm���Ɉ�����������

>>147 lbw��Inspire-Pack��lora loader(block weight)�ł����́H

comfyUI��������ĂȂ����ǎ�����lbw�Ɋւ��Ă͕��ʂɂ��܂��s���Ă��悤�ȋL��

Lora �͓����Ō��L�����ł��X�ł��Ȃ�f�L���Ⴄ

>>154 �ł��Ȃ�lora�͂ł��Ȃ��B�ł���lora�͂ł���

�����Ȑl�Ԃ��D������ɍ���Ă�����̂����瓝�ꂳ�ꂽ�i���ɂ͂Ȃ��

�����ǒm�����ł͕��ʂɐ���ł��邱�Ƃ̕������|��ɑ����Ɗ����邯�ǂ�

�v�����v�g�̏������Ƃ��ԈႦ�ĂȂ�����

�����ł��邱�ƂȂ̂ɑ��l�̐��ʂɕ֏悵����ŕ��匾������Ăǂ�ȃn�Q�����Ă�́H

�����f���ɂ�

���A���n�̊�lora�ق�ƂɎ��Ȃ��č����Ă�E�E�E������Ă����ݒ肠������̂ɂ�

>>160 ������l�̐��ʕ��̃N�\�ȓ_�ʋ��t�ɂ��Ȃ��玩�삵�Ă��

�����͂�����������ɂ����Aܯ����X���ł��邱�Ƃ��ő�����p���܂��傤

>>157 ���������Ȃ��̘b����Ȃ��Ďg�p�c�[���ŊK�w�ւ̌��������S�R�Ⴄ�̂��Ȃ��Ȃ̂���m���Ă����狳���Ăق�����

�ЂƂ�̗Ⴀ���Ă݂�Ǝg�plroa��microwaistV05

A1111����OUT4����Ԍ���������

ComfyUI����OUT11����Ԍ���������

154

>>165 2023/6���ɃX�N�V���ۑ����ĂāA���̉摜���Ȃ�Ȃ̂��S���\�[�X���킩��Ȃ��Ȃ�����

OUT�t�]���H

webui��comfyUI�̂ǂ�����OUT���t�ɂȂ��Ă��炿�傤�ǂ���Ȋ����ɂȂ肻������Ȃ��H

�Ȃ�ƂȂ�lbw�o�Ă����肾�������ǁA�S�̂�webui�ɔ�ׂďo����������

�������܂����n�Ȃ̂��Ȃ��������̂��蕪�����͂����肵�Ȃ�����

controlnet �� hand refiner���Ăǂ��ł�����

>>167 ���̐����肻��

issue�Ƃ��Ă������ĂȂ��Ȃ�

inspire pack �̍�҂ɓ`���Ă݂Ă��ǂ���Ȃ��ł��傤��

������Ƌ����Ăق������ǁA���f�����Ƃ��ɃL�����̑̌^��ς���ɂ͂ǂ�����̂��x�X�g�Ȃ́H

>>171 ���f�������ă}�W���I

ChatGPT�ɕ����Ȃ�ł������Ă���鐢�̒��ɂȂ��

>>167 �����Ɖ摜���Ă��炦�킩�邯��BASE��IN���������Ⴄ���班�Ȃ��Ƃ�OUT�t�]�������Ă��Ƃ͂Ȃ��Ǝv��

LBW�̍�҂���ɕ����̂������̂�������Ȃ����ǂƂ肠����ComfyUI�������Ǝg����悤�ɂ����

����摜����AI�T�[�r�X��������Ƃ����

�v�����v�gA��10��

>>179 �o�b�`��10�ɂ��āAprompt from file or textbox�Ɋe�v�����v�g������̂ł̓_��?

>>182 ��

�o�b�`��Batch count�̂ق���

����Ȃ�A10���AB10���AC10���Ɛ������ꂽ��

179�ł�

LoRA�Ŋw�K������Ƃ���Prompt��Negative Prompt�͓��ꂽ�ق��������H

>>185 https://github.com/liasece/sd-webui-train-tools ����̂��Ƃ��E�E�������ɂ킩��Ȃ�

���[�J���ł�Lora�w�K��kohya_ss�����肪��Ԏg����̂�

http://2chb.net/r/cg/1703250505/322 >latent couple ���g���ĕ����l�o�͂��Ă�̂ł���

>����A�v�����v�g�͌ʂɓK�p����܂���lola�́A���ʂœK�p����Ă��܂��܂�

>�ʂ�Lola��K�p����ɂ͂ǂ�������ǂ��ł��傤���H

https://civitai.com/models/262118/mai-dragon-ball-super https://civitai.com/models/262108/gine-dragon-ball ��

����Ȋ����H

�ǂ�������̂������Ăق����Ǝv���̂���

�ڂ̐F�����̐F���قړ����L�����A����������앗�Ƃ����u�����ɂ�������ۂ��o�₷���v��\�i�ō��i���������j���o���Z���X�c�c

>>190 ���ꐦ����

�^�ʖڂ�AI�G����Ă��Ȃ炱�ꂭ�炢�g�����Ȃ��Ȃ��Ƃ����Ȃ��̂���

>>191 ���߂Ĕ��F�Ⴂ�̃L�����ɂ��Ăق����������

�f�t�H���ƐF��ʂ���̉^�Q�[����

����Ȃ�ł��悩�������ǂ�

>>193 ���O��������

�܂�ł������Ӓn�����Ă݂��Ƃ��Ȃ������Ă�̂�

Comfy UI �ŁAgithub���璸�Ղ������̕���Workflowe��jpg�摜��Comfy��D&D����ƁA

comfy manager�Ō�����node�Ȃ�install �������������� custom nodes�ő���Ȃ����̂������邵���̂܂ܓ������

NovelAI�Ȃ�ł����A�L�����������̊G���ōČ��������̂ł����Aofficial art��official style���Ăǂ��Ⴄ��ł��傤���H

���������Č����ɋ߂����̗p��������̂ł�

StableDiffusion�ŃL�������X�}�z�̒��Ɏʂ����摜���Ăǂ����Ώo�₷���̂ł��傤���B

AI�Œm�荇���E�������ق���

�������łˁ[�́H

https://undress.app/ref/ >>200 ����͂�������LoRA���g���Ă����Ȃ�����

civitai�ŒT���Ă݂Ă�

>>196 ���̕�����S���ǂ�ł��܂���ł����E�E�E������܂���

�y�ɃC���X�g�[���ł��܂��� ���肪�Ƃ��������܂��I

�v�����v�g�̊Ԃ�,�����ŋ���Ă����̂ł����A�u, �v��,�̌��̓X�y�[�X�ŋȂ��Ƃ����Ȃ���ł��傤���H

�P�ɐl�ԂɂƂ��ċ�肪������₷���Ȃ���Ă����ŋ�K�v�͂Ȃ���

�����������Ƃ����̂͌Â��o�[�W�����ł̘b��������ł����H

���܂��͌Â��b�͒m���̂ő��̐l�ɂ܂�����

>>200 �X�}�z�̉�ʈȊO���������摜���������Ai2i��inpaint �ŃX�}�z��ʓh��Ԃ��ā@�q���C�������̗��@�Ƃ����������v�����v�g����ďo��

����Ȃ��ƕK�R�I�ɏ����ȉ摜�ɂȂ邵�ʃR�}�̉摜���\�肵�Ă�Ǝv��

���O�́A�c�����O�̊Ԃ�_�ŋ�����������ł����H

�o�͂������ʌ���킩��

>>206 ���Ȃ�Â��o�[�W�����ł́u1girl,smile�v�Ɓu1girl, smile�v�Ō��ʂ��ς���Ă������Ǎ��͓������ʂɂȂ�A�������͂�

���O�̋��K�v���ǂ�����u_�v��肪�K�v���̓��f���ɂ��

�ǂ���������Ŏ����Ă݂Ă�

SD�̃x�[�X��danbooru�g���Ă�ƔF�߂Ă���Ęb�����犮�S�I���W�i������Ȃ�����A���_�[�o�[�ɔ�������\���͂���

���O���Č����Ă邩�牽���̃L�����Ȃ�ł���H

tagauto complete�̐ݒ肢���炸�f�t�H�Ŏg���Ă邯��

�����̂���^�O�����o������ǂ����ǁB

>>215 �p�P����Ăǂꂾ���P�ꂠ��Ƃ������Ă�c

>>216 ������H

��p�P�ꂾ���̎����ɂǂꂾ�����p��������邩�ŕς�邾�낤���ǃL�������͕K�v���B

1��86400�b�����甽������1�b1�������肷��Ȃ�

864�����ׂ�Ȃ�100��������B

�ł��g�[�N���̔����ׂ邾���̐����Ȃ�X�e�b�v���Ɖ𑜓x�����点��1�b������Ȃ��͂���

�b100�`�F�b�N�ł���Ȃ�1����OK�ɂȂ�B

�S�Ă͒P�ꐔ�ƃ`�F�b�N���x�Ɉˑ�����B

�����A�O��g�[�N���ɂ��e������ďo�͂��ς��Ȃ�@�B�I�ȃ`�F�b�N�͕s�\�ɂȂ邯��

>>218 �����864���P��̈ꗗ�������Ė��ɗ��̂��H �P��̈ꗗ�ɔ������� �Ƃ������� �������̂��H �l�̓��̒��ɂ��������u���ҁv�ʂ�̔������邩���Ȃ��̂����ǂ����f����H

��������l�͎����������Ȃ����P�ꂸ���琶���p�����[�^�[����ĂȂ��̂Ɏ������(�ŗL������������)�傫���ꗗ���璲�ׂĎg���̂��H

�C���^�[�l�b�g�Ŗ��ɗ��������ȕ\���ɖ𗧂������ȃ^�O�����������Ă��Ď����̖ڂ̑O��AI�Ő������邩 �摜�Ǝ��������J���Ă���T�C�g���݂Ď�������Ȃ��̂��H

�T���C�`

�L���A�s�[�X��XL�pLoRA�������

�d���Ȃ���Ńl�b�g�ŏE������掿11���ō������

���t�摜�������̂ɖ��Ӗ���1024�Ŋw�K����������₩��45��������������

�܂��A�K���Ɉߑ��o������������LoRA�ŕς��Ă����₪��

RedRayz����GUI��LoRA�w�K������ĂāA

>>224 ��҂��������ɂ����邩��A���ڕ����Ă݂�Ƃ�������

�Ȃ�JNVA����321

http://2chb.net/r/liveuranus/1705861083/ �Z�[�u�f�[�^�݂����ȃC���[�W�ŁAPNG Info����t2t���i2i�ɑ����ăv�����v�g���������Ă���ǁA

>>226 ����͂Ȃ��Ǝv���Ȃ�

txt2img����img2img�Ȃǂ֑���Ƃ��ɃV�[�h�l��T�C�Y�����M���邩�͐ݒ�́uUser interface�v�ɂ��������ǁA���̐ݒ��PNG Info����̑��M�ł͊W�Ȃ�����

kohya_ss�Ŋw�K�����悤�Ƃ�����ł���

>>227 �����ł���ˁ[�B

�����Ă�A�V�[�h�l���邩�݂����ݒ肠���Ă��ꂩ�I�Ǝv������PNGInfo�͊W�Ȃ��悤�ŁB

Override Setting�̂����ŐV�������f�������Ă�����Ȃ̂ɌÂ��܂܂ŁA���炭�C�t���Ȃ��������Đl���\�����Ȃ��ł����ˁH

>>225 ���肪�Ƃ��������܂��B�������ŕ����Ă݂܂��B

>>229 --no_half_vae ���ǂ��ɋL�q�����낵���̂ł��傤���H

Advanced��Additional parameters���ȁH

>>229 >>233 ���肪�Ƃ������܂��@�w�K���J�n�ł��܂���

���݂܂���K�`���S�҂ł�

���f���@Check Point��������

>>235 ���肪�Ƃ��������܂��I����Ă݂܂��B

>>235 �����I�ɂ͂���܂ł̃v�����v�g�Ɉ��������邱�Ƃ͂Ȃ����ǁAA1111�̓o�O�Ȃ̂�������������摜���o�邱�Ƃ�����Ƃ悭��������

���f�������������ւ��邾���Ń��Z�b�g�����Ƃ����̂͏���

A1111���ċN�����Ȃ�������Ȃ��Ǝv���Ă�

�}�X�s��̘b���H masterpiece�Ƃ��w�肵���炻��Ȋ炵���o�Ȃ��Ȃ�@�N�I���e�B�����߂镾�Q��

>>235 ��{�I�ɂ����Ɛ������Ă��炻�ꂪ���݂��A�݂����Ȃ̂͂Ȃ�

R18���Ȃ��Ȃ��o�Ȃ���������̉摜���c���Ă�̂ł����

png info�ɓ˂�����ō����݂ƃv�����v�g�̈Ⴂ�����Ă݂�Ƃ�������

����P��ɋC�t�������s������o���ĂȂ��Ƃ����Ǝv����

�L���b�V���f�[�^�����邩���

Lora�w�K��aaaa_v1-000010�݂����ɍ��Ȃ���m�F���Ă鎞��<lora:aaaa_v1:1>�����Ō������Ⴄ

LoRA�͉������ς��܂ŃL���b�V�����Ă��邯�ǁA�t�@�C�����ł͂Ȃ��ăG�C���A�X��������

���������������f���Ő������Ă�Ύ����悤�ȕ����o��͓̂�����O

http://2chb.net/r/cg/1703250505/518 > �ŏ�optimizer�̐ݒ��adamW8bit�ɂ��Ă����̂ł���Error no kernel image is available for execution on the device�ƂȂ����̂�adamW�ɕύX�����Ƃ���̃G���[�ł�

1070ti�Ȃ��adamW8bit�͓����Ȃ��낤��

> CUDA out of memory�Ƃ������̂ŐF�X�Q�l��SBwebui-user-bat��--xformers --medvram�������Ă݂���webui.bat�̂ق���set PYTORCH_CUDA_ALLOC_CONF=garbage_collection_threshold:0.6, max_split_size_mb:128

> �����Ă݂��肵���̂ł������܂���P���܂���ł���

> ���������������{�I�ɊԈ���Ă���̂ł��傤���H

����͊��Ⴂ�A�����webui���ł�����kohya_ss�Ƃ͊W�Ȃ�

���āA247�̌����X�悭����������E�E�\���Ă��炤�܂ł��Ȃ��A�Ȃ�قǂ�

SDXL�Ń��A���n��LoRA�̌����̂������f�����ĉ�������ł��傤���H

fudukiMix_v20 ���������Ă���̂ł��� LoRA JP2 ��lj����Ă��S�R�ς��Ȃ��̂ł�

�ł����Animagine�x�[�X��Refiner�Ƃ��Ďg�������̂ł�

SD1.5�ł̓A�j�����f�����x�[�X��xxmix9realistic_v40��Refiner������ADetailer�Ƃ������������C�ɓ���ł���

���z ��

>>247 >>250

����ς�webui��kohya�͕ʁX�Ȃ�ł��ˁc

kohya���܂߂�CUDA out of memory�G���[�H�ׂĂ�SB�̉������@�����o�Ȃ������̂�webui���̖�肩�Ȃƍl���Ă��܂��܂���

���������炷��Ə����I�ȃ~�X�Ȃ̂ł��傤���v���O���~���O�Ȃǂ̒m���͂Ȃ��̂ʼn����Ԉ���Ă���̂����x���Ԃ��Ă��킩��܂���

�ł���Ί��ݍӂ��ċ����Ă���������Ə�����܂�

>>252 Kohya_ss�N���������̈�ԏ�Running on local URL:

http://127.0.0.1:7860 �����

���b�Z�[�W��������SS����������

Kohya_ss�̃Z�b�g�A�b�v�~�X���Ǝv������

��ACUDA out of memory�͒P����VRAM������Ȃ����珈�����s�o���Ȃ����ăG���[������

8GB����VRAM������1070���Ⴛ��Ȃ�ɂ�肭�肵�Ȃ��ƌ�������

�ꉞ���L���������g�����Ƃő����Ȃ�J�o�[�o���邯��

���������ڗʂ�16GB�����Ȃ��̂ŋ��L��������8GB�i���C���������̔����j�����m�ۏo���Ȃ��̂�

�����ɂ���Ă�8GB+8GB�ł͑���Ȃ������Ȃ�Ȃ����ȁi����ۂǖ������Ȃ��ᕁ�ʂ�12GB�O��ł����܂锤�j

>>251 fuduki 2.0��lora�����ł��g����悤�ɂ������f���Blora��K�p����Ɖߊw�K�ɂȂ�\��������Ƃ̂��ƁB����fuduki1.5��lora�̎g�p��O��Ƃ��Ă���̂ŁA�ړI�ɂ���Ă͂����炪�I�X�X���B

>>252 �ׂ������͂킩���̂����ǃ�����32GB��3060ti(8MB)��Kohya_ss�ĂāAOutOfMemory��Őݒ肵�Ă�Ƃ���B�����Q�l�ɂȂ�B

�ELoRAtype�FStandard(���͖����H)

�ETrainbatchsize�F1��2(Max resolution�Ƒ��k)

�EMixed precision�ASave precision�Ffp16�Œ�

�EMax resolution�F512�Ȃ�Trainbatchsize2�ł��\�����A752�Ȃ�1�Œ�

�ENetwork Rank�ANetwork Alpha�F�グ�����͖���(128�A1�Ŗ��Ȃ��Ǝv���Ă�)

>>252 ���X�x�ꂽ�A���߂�

��ԏ�悭�����dreambooth�ɂȂ��Ă�A�������߂���������̂�OOM�ɂȂ�

�f�t�H�̋N�����̃^�u������ŁA�����ڂ��قƂ�Ǖς��Ȃ��̂�

> �݂�Ȃ悭���炵��

https://www.reddit.com/r/StableDiffusion/comments/111w2gy/cuda_out_of_memory_when_using_kohya_ss/ >>254 ���肪�Ƃ��������܂� v1.5 �Ŏ����Ă݂܂��Ɗm���� LoRA ������Ă��Ă���̂�������܂���

�i���� seed �ł���ȂɈႤ�̂͏��߂Ăł����j

����� 1.5 �̕��͑f�ł� 2.0 ���D�݊��ł����̂ł���ł��낢�뎎���Ă��������Ǝv���܂�

���߂�2�T�Ԃ��炢�̏��S�҂ł��@�O���{��gtx1660�ł�

kohyass�̍ŏ��̃^�u��Dreambooth�I�����Ă��܂���

>>259 >>260 �w�K����lora��I�����^�O������Ă��܂�

�v�����v�g�������܂���������lora����ƂȂ��œ������ʂł���

>>258 �Y�t���Ă�e�L�X�g�̏��������Ԉ���Ă���\��

>>262 ����lora�̃��^�f�[�^�������Ƃ��ɐݒ肵���^�O���S�Ă���̂�

���Ԃ�Ԉ���ĂȂ��Ǝv���܂�

���̓L���v�V����txt��Ȃ��ł��ꉞ�w�K�͂��邵�A�g���K�[���[�h�Ȃ��ł�Lora����Ă�Ɣ�������

>>258 �G�X�p�[����Ȃ��̂ōׂ����ݒ茩�Ȃ��ƂȂ�Ƃ��E�Ejson�t�@�C�����A�b�v���[�_�[���ɏグ�ē\����

> ��������ł͊w�K���Ɖ摜�������ɃG���[���Ȃ��悤�ł�

Loss��������NaN�Ƃ��ɂȂ��ĂȂ�

>>266 ���肪�Ƃ��������܂�

�ݒ��ς��Ċw�K���Ă݂܂�

�x���Ȃ��Ă��݂܂���B

>>256 >>260 ���킠�������������������A���̒ʂ�ł�

�o���܂����c

�w�E�����܂Ń^�u�����������Ƃ���C�Â��܂���ł���

�{���ɂ��肪�Ƃ��������܂�

>>253 >>255 ���J�ɂ��肪�Ƃ��������܂��B�X�y�b�N�I�ɂ�͂�Œ���Ƃ��������Ȃ�ł��ˁc

����͎��̃~�X�ł���������̎Q�l�ɂ����Ă��������܂�

���肪�Ƃ��������܂���

kohya_ss�̍ő�̌��_�����̃^�u���Ǝv��

���������ԈႦ����Akohya_gui.py�Ƀp�b�`���Ă�Dreamboith��LoRA�̃^�O�̏��ԓ���ւ���悤�ɂ���

�h���[���u�[�X��LoRA�̃^�u�̒��g��

����ق�ƂɃ^�u�̒��g�قړ����Ȃ�ł��ˁc

����ւ����ĊȒP�ɂł����?

kohya_gui.py�̈ȉ���2�s��Dreambooth�̏�Ɉړ����܂����B

���傢�Ǝ���

>>278 �Q�[���W���ƌ덷�݂����Ȃ���Ƃ���Ă�

>>278 ��PCI3.0��4060�������

�v�����ĂȂ����ǁA��芷�����ق�������

�v���Ԃ��SD�G���Ă���ǂ��ALCM lora��a1111�Ŏg���ɂ�

>278

���肪�ƁA�ǂ����3.0�ł��邱�Ƃ͂����܂ŋC�ɂ��Ȃ��Ă��悳�������

�Â�PC���Ɠd�������o����������Ȃ�����

4060Ti�Ƃ�����x8�ڑ�������X�Ɏ�p�t�H�[�}���X�ቺ�͂��邩����

�O���{�����ւ��͗\�Z�������Ȃ�VRAM16�ȏ�~������

>>276 ����ς�������ˁB���܂������Ȃ���

�Ǝv���Ă��獡�Ȃ�����������

�����Ԉ���Ă����̂��悭�킩����

.py��TAB�Ɣ��p�S�p�X�y�[�X�ł߂��Ⴍ����ɂȂ肪��

Python�̓C���f���g�̐���C����̃J�b�R�ɑ������邩���

�������Ƀ������͂ǂ���AVS Code�ł��������

���≴�̓������g���ĂȂ����ǕʂɃv���O���}������SD�������Ă�킯���ᖳ�����륥

�ŋ߂͏����K�͂��傫���̂�vscode�Ɉڍs����������

���Ƀ������g���Ă����Ȃ�����

�T�N���G�f�B�^��30�N�߂��g���Ă�

�}�W���X���邯�ǐ�p�̃\�t�g���g��Ȃ�����Windows�ł�BOM��������

>>300 ���܂̓��������f�t�H���gbom����UTF-8����

289�����ǃT�N���G�f�B�^���g���Ă܂���

���⎸�炵�܂�

Kohya_LoRA_GUI��

>>228 �Ɠ����G���[���o��̂�--no_half_vae��ݒ�ɉ��������̂ł����Y�����鍀�ڂ��ݒ�Ɍ�������܂���

Kohya_LoRA_GUI�ł�--no_half_vae�̐ݒ�͂ł��Ȃ��̂ł��傤���H

�O���{��SD�p�ɍw�����悤�Ǝv����ł���

>>305 VRAM�ƃ������͑��x���S�R�Ⴂ�܂�

8GB�ł�SDXL�����͉\�ł����V�K�ɔ����Ȃ�12~16GB�ȏ���������߂��܂�

>>304 ����������Ȃ�������Ȃ��˂�

>>305 �\�Z�̋��������VRAM��ԑ傫���ĂȂ�ׂ��V�������̂���I�ԂƂ�����

XL���C���Ȃ�16������

12�͗\�Z�̊W�Ƃ����g���Ă邩��Ë�������Ċ���

>>305 ���x�������Ȃ�2~5���Ƃ��ɗ����邼�A�}�W�ŁBVRAM�ł���1��������Ȃ����炢�̐������AVRAM���炠�ӂ��Ɨ\�z���Ԃ�15-30���Ƃ��ɂȂ�

VRAM24�M�K������2~3�M�K���ӂꂽ�����Ȃ̂ɂ��ꂭ�炢���x�������邩���

GPU�̓��C���������ɒ��ڃA�N�Z�X�ł���킯���ᖳ������

CPU�ɗ���Ńf�[�^��]�����Ă����Ȃ��ƂȂ�Ȃ��킯�ł��̃I�[�o�[�w�b�h���ƂĂ��Ȃ����

�ш敝���{�g���l�b�N���������ȁH

���C���������̑ш���ႢPCIe�o�R�ŃA�N�Z�X����킯�����炻�����������

>>308 ���݂܂���

>>232-233 ��Kohya_LoRA_GUI�ł͏o���Ȃ��݂����ł�

Advanced��Additional parameters����������Ȃ��̂�

>>311 PCIe3.0 16GB/s

PCIe4.0 32GB/s

PCIe5.0 64GB/s ---�Ή��N���{������

���X���肪�Ƃ��������܂�

>>313 �������߂�AKohya_LoRA_GUI���Ă̂�����̂��E�E

�Ȃ�JNVA�̉ߋ����X�ɂ���

http://2chb.net/r/liveuranus/1696248064/389 ����ł͂Ȃ��̂��ȁE�E�H

>>316 �グ���Ă���摜�̂��̂ƃo�[�W�������Ⴄ�̂��p�t�H�[�}���X�Ƃ����^�u�ł͂Ȃ������̂ł���

SDXL�Ƃ����^�u��VAE��32�r�b�g�Ŏg�p(--no_half_vae)������܂���

�����ƒT��������Ō����Ƃ��Ă�����ł��ˁcʽ��

�ł�����Ŋw�K���i�߂�ꂻ���ł�

���肪�Ƃ��������܂����I

StableDiffusion���g���Ă݂����āA4060TI 16GB�����Ǝv���Ă���̂ł����A

>>321 �����܂ŒႢ�ƌ�����������

�Ƃ肠�����g���Ă݂�����̂ł͂Ȃ���

�s������Ȃ���������

>>321 ���C������������32�M�K�ς�ł���Ƃ肠�����g����Ƃ͎v����

���ʂɋN�����Ă邾���̏�Ԃ�Python��7�M�K���炢�H���Ă邵SD�g���Ă�u���E�U�̃^�u���������H��������Windows���������H���ɂȂ��Ă邩��B

���C��������16�M�K���ƃc�����Ǝv���B��Ζ������Ăقǂ���Ȃ���

�����Č�����CPU��2�R�A���Ɖ摜�������ɑ��̎�����͖̂����B���挩����Ƃ�

>>318 �����Windows Notepad���B

������(�P�Ƃœ���notepad.exe)�ł͂Ȃ��B

windows10�ȍ~�Ń�������notepad�N�����Ă݂��ꔭ�ł킩��������� Sa21-on57�͉������Ă��

>>324 ������

�������ł͂������̕ύX������܂����B

UTF-8�G���R�[�f�B���O

�o�C�g�I�[�_�[�}�[�N�Ȃ��Ńt�@�C���� UTF-8 �ŕۑ�����I�v�V�������lj�����A���ꂪ�V�����t�@�C���̊���ƂȂ�܂����B

cpu��11����ȏ��i7,��������32GB�B

������ = Windows Notepad = notepad.exe

���݂܂���

�d������ˁH

4070Ti�̐����d���e�ʂ�750W�������߂Ƃ����ق�������

>>330 �d���ȊO�͂�������

�~���������C����������64GB�~��������������炫�肪�Ȃ���

>>331-333 �L�

���_�Ƃ��Ă͂���ϓd����750w�ɑւ�������Ƒ҂��Ĕ����Ηǂ���

���݂Ƀ��C���������̓}�U�{�̏����32G������64G�ɂ͏グ����̂ł�����

>>334 ���̏���͂�����1��32GB�ł����čő傶��Ȃ��Ǝv��

32GB2��������64GB�������4�������Ȃ�32GB�~4��128GB�����

������core i3 �Ƃ�CPU�̐��\��64GB����̕������݂��� 3700X �͂����炭128GB�����

�����}�U�[�{�[�h�ŏ��32GB�Ȃ������[�J�[�̃}�U�[�{�[�h��PCIe��3.0�ł�����x16����Ȃ���x8�̉\������

�ςȂ̂���Ȃ������Ƃ��Ă�B450�n�Ȃ�PCIe3.0������GPU�̐��\�͐���������Ȃ���

����ł�

>>337 hp��BTO�i�Ń}�U�{��moria2���Ă̂ł�

���ȃ������A�b�v�O���[�h���

�f���A�� �`���l���i1 �`���l�������� 1 DIMM�j������ �A�[�L�e�N�`��

DDR4 UDIMM�i288 �s���j�\�P�b�g 2 ��

PC4-21300 (DDR4-2666) ���T�|�[�g

8 GB ����� 16 GB �� DDR4 UDIMM ���T�|�[�g

32 �r�b�g�V�X�e���͍ő� 4 GB ���T�|�[�g

�⑫: 32 �r�b�g�V�X�e���� 4.0 GB �̃��������t���Ɏg�p�ł��܂���B

64 �r�b�g�̃R���s���[�^�[�ŁA16 GB DIMM �ōő� 32 GB�i�o�b�t�@�Ȃ��j���T�|�[�g���܂��B

�⑫: �L�ڂ���Ă���ő僁�����̓n�[�h�E�F�A�̋@�\���������̂ŁA�I�y���[�e�B���O �V�X�e���ł͂���ɐ�������邱�Ƃ�����܂��B

�������Ă�̂�64�r�b�g�}�V���ł���

>>337 �lj�������

���ꂾ�Ƒ������v���Ǝv���܂�

���O���{���

AMD Radeon RX 5700 8 GB FH PCIe x16

�t�H�[�� �t�@�N�^�[�FATX�i25.4 cm�i10.0 �C���`�j�t���n�C�g�j

�w�� I/O �R�l�N�^�F(1) HDMI ����� (3) �f�B�X�v���C�|�[�g

�f�B�X�v���C�|�[�g �o�[�W�����F1.4a

HDMI/HDCP �T�|�[�g�FHDMI 2.0b/HDCP 2.2

�ő�𑜓x�F

HDMI �𑜓x�F4096 x 2160 (60 Hz)

�f�B�X�v���C�|�[�g�𑜓x�F7680 x 4320�i60 Hz�A8 �r�b�g�j

�⑫: �ő�𑜓x���T�|�[�g���Ȃ��|�[�g������܂��B

������ �T�C�Y�F8 GB�i256 �r�b�g�j

�������̎�ށF256M x 32 GDDR6/14 Gbps�i8 �j

������d�́F180 W

PCIe�FPCIe x16 (Gen4)

�����ɍő� 4 ��ʂ��T�|�[�g�ł��܂��B

�d���R�l�N�^�F6 �s������� 8 �s��

AMD Surround �}���`���j�^�[ �e�N�m���W�ABlu-ray ����� DirectX 12 ���T�|�[�g

>>338 ���ł���̂�������܂��A����1�̃A�v���P�[�V�����Ő����ł����@�͌��J����Ă��Ȃ��Ǝv���܂�

Google Colab��sd-webui-train-tools���g����Lora��������

>>339 ��p�P�[�X��MicroATX�}�U�[��

�P�[�X�̒��ɉ�mm�܂ł̃O���{�����邩�m�F�����ق�������

���ƁA�d���̃T�C�Y

��p�̓d�����ƌ����ł��Ȃ��\�������邼

>>343 4070ti�͍��̃O���{��肿����Ƃ����傫������C�ɂ͂Ȃ��Ă�

�ł��d���������ł��Ȃ��\���܂ł͋C�ɂ��ĂȂ������ȁc�c�c�c

>>342 ��������Ȃ�����

https://github.com/liasece/sd-webui-train-tools/issues/49 �Ɠ����ǏˁE�E

webui�Agradio�Asd-webui-train-tools���ꂼ��͑S���ŐV�H

>>345 ��ɍŐV���_�E�����[�h���ē����̂ōŐV�ł�

��xLora�����ɐ�����������

����Lora���g���ĉ摜����������A�G���[�œ����Ȃ��̂�

�ēxLora�������Ȃ�������ALora�������G���[�ɂȂ��Ă��܂��܂���

>>322-323 ���肪�Ƃ��A���������₵�Ă���Ă݂悤����

colab�͂����ŐV�_�E�����[�h���邩��t�ɕs����

>>346 VIDEO ���N5����webui1.1�œ����Ȃ��Ȃ����p�^�[��

fork���Љ��Ă邯�ǁA�ǂ������X�V��8�����O�Ȃ�ŁA�ʂ̂Ȃɂ������������̂ł�

>>348 > colab�͂����ŐV�_�E�����[�h���邩��t�ɕs����

���ǂ�����

������Ă�̂��悭�킩��Ȃ�����

>>339-340 ���ꂩ

https://www.gdm.or.jp/review/2020/0215/337233/3 2������������ő�64GB�܂ł�Bios�̃A�b�v�f�[�g���Ȃ������烁�C����������DDR4-3200MH���̓��삪������������Ȃ�

GPU��Gen4���̂��Ă邩��PCIe4.0���Ǝv�����ǃT�C�Y�������R�t�@���ǂ��납�Q�t�@���̂��������������������肵�����Ă邗

Radeon RX 5700 XT�@230 x 111 x 41 mm

RTX 4070 Ti VENTUS 2X 12G OC�@242 x 125 x 51 mm

�d���͕��ʂ�ATXBOX�^���ۂ�����GPU�ɋ߂����邵ATX�d���R�l�N�^���ז����ĂČ��ݍ���10mm�����肫�邩�͕s��

�d���̉E���ɂ���̂��d���X�C�b�`��Ղ��Ƃ�����}�U�[�{�[�h���ɂ��Ă�\�����Ȃ���ŋl��ł邯�ǃt�����g�p�l���n�Ȃ�t�����g�p�l�����g���Ȃ�������������͂Ȃ�����

https://www.gdm.or.jp/omen-obelisk_34_1024x768 �܂��X�g���[�W���J�o�[���Ă�������ǂ��ɂ����Ȃ��ƃO���{���������Ȃ�����}�U�{��PCBOX�������ւ�����������

���S�ɃX���`�Ȃ�ł���ȏ�͐�p��

>>350 �����Y�����

111mm �� 125mm ��4070TI�̕��������傫������ǂ݂̂��W�͂ł��Ȃ���

�����͂������ςōׂ����Ԗڂ̂���V�[�g��킹�Ă邯�ǂ��������o�傪�Ȃ��l�͔����ւ��������߂���

>>350-351 ��������

�ڂ������肪�Ƃ�

�O���{�̉E���̓R�[�h�̉��ɂ���J�o�[�O�������������Ԃ�����̂�

�ň��X�g���[�W�J�o�[�Ԃ�����Ή��Ƃ��Ȃ�Ǝv��

���͉����̃R�l�N�^����

���ꂪ�_���Ȃ��l����4060ti�ɂ���c�c�c�c

���Ί�̓��{�l�ꂪ�^���Ȋ�̃��[�e�B�[�����q���w���̋��Ɏ���̂���

>>353 �ނ��낻�̃V�`���ŃG�����Ȃ��̂��Ăǂ���������

>>354 ���H

���������R�����g�Ԃ��ė���Ǝv����

�t�̎����������H

�����ӂ��ẮH�@���O

>>356 ���O2���X�������ĂȂ���ȁH

��������ĂȂ�

���₶��Ȃ��Ƃ������ȑO�ɂǂ��l���Ă��������������̂�NG�������Ȃ����

��w���͎������������x�݂ɓ˓���������������

���S�Ҏ���ł��݂܂���

>>361 �����Ɏg���Ă���c�[���ƃ��f���ƃv�����v�g�Ɛ������ʂ̉摜�Ⴊ�Ȃ��ƃA�h�o�C�X�ł��Ȃ�

�摜���݂čD�݂ɍ�������Ȃ��͌l�̊���������

������烍�[�J���X�e�u���n�߂܂���

�����̓��A���n�͎̂ĂāA�A�j�����ł������Ǝv���܂�

���f���Ō����s����������Ƃ̎��Ȃ̂Ő�ɃA�j������U���������Ǝv���Ă܂�

�A�j���Ȃ炱�̃��f���Ɗg���@�\����Ƃ��@�݂����Ȃ��̂�������ė~�����ł�

YouTuber���Љ�Ă��ꂽ���f������ꂽ�̂ł����F����̂悤�ȃN�I���e�B�[�̍����G�������ł��܂���

�F����̊G���P�O�O�_���Ƃ�����A�����̊G�͂S�R�_���炢�ł�

�s�H�Ƃ���`�ł͂Ȃ��ł����A���������������ł����A�N�I���e�B�[�͒Ⴂ�ł�

�����́A���f���������̂��A�g���@�\�������̂��A�ݒ肪�����̂��A������������܂���

�v�����v�g���d�v�Ȃ̂Łueasy-prompt-selector�v����ꂽ����K�x�������܂���

�ł����A�����Ă������easy-prompt-selector�Ǝ��ۂɓ�������easy-prompt-selector���Ⴄ�悤�ȋC�����܂�

�����炪�����Ă������easy-prompt-selector�ł�

https://imgur.com/a/YVja1J0 �����炪��������easy-prompt-selector�ł�

https://imgur.com/a/5IxJIIY �������Ă݂�Ƃ��łɂP�O�O�O�ȏ�̃v�����v�g���p�ӂ���Ă��ăJ�X�^�������Ƃ�����͏\���Ɏg���Ă�����̂ł��傤���H

�i�Z�Z�F�Q�j�Ȃǂ͎���͂��܂�

���Ǝ�����

>>23 �݂����ȊG����肽���ł�

�܂�YouTube�łP�O���Ԃقǂ��������Ă܂���LCM�͕�������������܂�

�R���g���[���l�b�g���|�[�Y��

LCM�����掿�g��

���ɂ����掿�ɂȂ�g���͏Љ�ꂽ�̂ł����A�݂�Ȃ����߂Ă���̂��������Ă݂܂���

�����ČJ��Ԃ����[���ƃ��f���ƃv�����v�g�����s���낷��@�Ƃ����F���ł��������Ă܂��ł��傤���H

���Ƃ��Ă�

>>23 �݂����ȊG�͈�x���o���܂��J�X������܂���

�f�r���[�Q���ڂȂ̂œ��R�ł����AAI������ƌ����ĊȒP�ɂ͉��l�̂���G�͏o���Ȃ����������ł��܂���

�܂������炷���낵���ł��傤���H

>>363 �t��1000�ȏ�v�����v�g�������Ă��S���o���킯����Ȃ���Θf�킳��邾��

����Ƃ��Ō����Ȃ�܂��͓���ƑS�������悤�ɂ���Ă݂Ă���

23�̂悤�ȉ摜���ǂ���v�����v�g�����f�����T���v���[���p�����[�^�[�����J���Ă���Ă������܂��͂��̂܂ܓ��͂��Ă݂ẮH

����LCM�͍��掿�g������Ȃ�

>>363 �����O�ő��̐l���ŕԐM�����������Ɏg���Ă���c�[���ƃ��f���ƃv�����v�g�Ɛ������ʂ̉摜�Ⴊ�Ȃ��ƃA�h�o�C�X�ł��Ȃ�

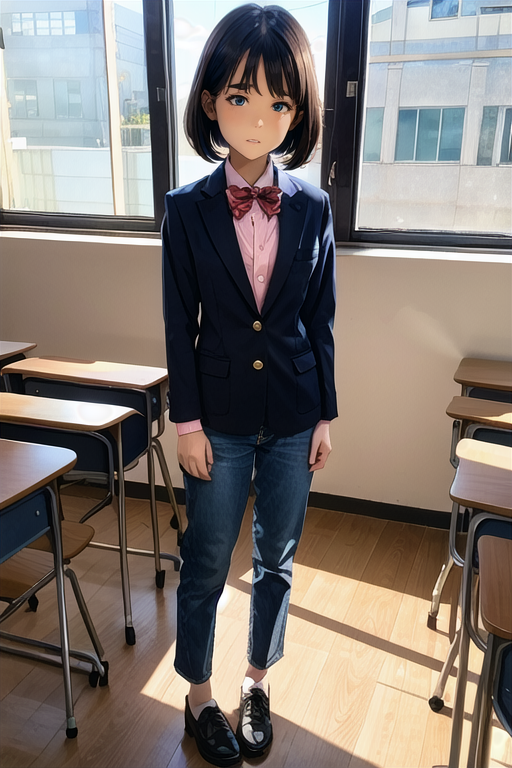

https://imgur.com/a/ysptWuJ ���f��

�h���[���V�F�C�p�[

�v�����v�g

���𑜓x�A���̎q�A�������A�p�[�J�[�A������������̏Ί�

�l�K�e�B�u

�C�[�W�[�l�K�e�B�u

�ǂ��������ł��傤���H

>>23 �Ɏ��Ă�敗�ɂȂ肽���ł�

�����烍�[���������̂ł���

>>366 23�̃��f���g���Ă��郂�f�����g��

�����Ɉӌ��������Ȃ�v�����v�g�͕ϊ���̉p��̂��̂�����

���f������������ƌ��̉p�ꖼ�Ńo�[�W�����������i������Ȃ���t�@�C�����j

23�̂悤�� �������ʂ� MajinAI

https://majinai.art/ja/ �ɓ\��ǂ������ݒ�Ő������Ă��邩�킩�邩�珕���ł���

>>367 ������܂��ɂ킩��܂���͓�����O����

�����Ă��玿�₵��

�Ƃ肠�����J�^�J�i���~�߂������ǂ�

�Q�S���ԑO��AI�摜�̎��ׂč������܂ł̒m���Ă郌�x���ł�

�����A���������������������

���ߕ��͉p��ł�

���{�ꂾ�Ɛ��x�������܂����

����Ō��ʂ͕�����܂����H

>>23 �Ƃ̈Ⴂ�ł�

�Q�S���ԑO��AI�摜�̎��ׂč������܂ł̒m���Ă郌�x���ł�

�����A���������������������

���ߕ��͉p��ł�

���{�ꂾ�Ɛ��x�������܂����

����Ō��ʂ͕�����܂����H

>>23 �Ƃ̈Ⴂ�ł�

���ƃ��[���w�K��AI�摜�����̃G���h�R���e���c���Ɨ\�z���Ă܂�

�������̃X���̂ق����i��ł�̂ł������Ŏ��₵�Ă݂āI

http://2chb.net/r/cg/1703250505/ �S�~�̎C��t������

���́E�E�E

ID:Ufrj+BNm0

>>23 �݂����ɂ��������Ă��Ƃ�����

�܂���

>>23 ��majinai���ăT�C�g�ɉ��������S���ڂ��Ă�̂ŁA�܂�������Q�l�ɂ��悤

PNG Info���Ă̂ɉ摜�˂������send to txt2img���Ă�����S������ɂȂ�

���Ƃ̓��f���uabyssorangemix3AOM3_aom3a3�v��VAE�uorangemix.vae.pt�v��p�ӂ���

>>376 �Ȃ烍�[���w�K�̂������ߓ��拳���Ă���������

�X���[���Ă�̂ǂ����ł����H

>>379 �u�Ȃ�v���āA�����u�Ȃ�v�Ȃ�

����Ɋ������܂�ł���

>>378 ���������Ă��ꂽ�珕����܂�

�Ȃ�߂��ڂŏ������Ƃ悱�����̌����Ă��˂�

����Ⴑ�������₽���ԓx���r�ߕ������ԓx�ŕԂ��܂���

���Ǝ����Ȃ�

�ǂ�������Ɏ���n�߂����Ęb�ł���

�炪�����Ȃ��������

�ڂ̑O�ɂ����炻��Ȏ���ȑԓx���Ȃ�������

�����Ȃł����H

�l�b�g���̂�

����X���Ȃ��炳�����Ƌ����Ă��ꂽ��ςޘb

��������[�����[��������

�߂�ǂ�������������������������������������

���O���R���s�����玝���A��ł���ŁH��

����ȃR�~���ǂ��႗

�������Ƙb���ς܂���

�G���W�j�A���Ȃm���

�����̉�Ђł�����������G���W�j�A�͂������L���[�Ȃ������������

���炾�炾�炾��Ƃ�

����X���Ȃ�₩�炳�����Ɠ������炦�����

>>378 ����͗D�G���

�d����ł���

�K�v�Ȃ��̂��������Ă邩��

���O��̋C�����Ƃ��U���Ƃ������������������Ƃ�����͂����̂�

�K�v�Ȃ��̂��������Ƃ�

�l�b�g���̈����Ȃ��̂Q�Ȃ�

���A���i���̖ڂ𗁂тȂ��n��l����

�Ȃ�₱�̂܂��Ȃ����ăT�C�g�I�I�I�I�I�I�I�I�I�I�I

���b�`���C�L�낤���r���̂�����ŕ�����������H

>>362 �Ȃ��݂܂���A�܂��ʂ̓��ɏo�����܂��c

>>385 �u���b�`���C������r��Ȃ��v�ƌ����Ă��l�Ȃ�Ă��Ȃ��ł���

�ƂɌ��������Ă��D�_�ɓ����邱�Ƃ����邩�献�������Ȃ��ق��������Ǝv���Ă��?

�Œ���̖h�ƂƂ��Ẵ��b�`���C�������č��邱�Ƃ͂Ȃ��ł���

>>361 �l�K�e�B�u�v�����v�g�Ɂurealistic�v������Ƃ����Ȃ�

������ɂ��Ă��g���Ă��郂�f�����킩�������������₷��

�ʎY�������摜�ƁA�ł������Ȃ����Ⴄ�Ƃ����摜��catbox�ɏグ�Ă݂Ă�

���b�`���C�Ń��o�C���n�ƌ������L�c�C���X�͍r���̂�NG�ŗǂ��Ǝv���B

IP����ɂ���Ǝ��P�ʼn���w�����邾���Ȃ̂ŁA

�Ȃ�Ń��b�`���C�͗ǂ���IP�͑ʖڂȂ�H

IP�͋t�����Ńv���o�C�_�܂œ���ł���̂ŁA�l�̏��Ȃ��X�����ƃR�e�n���ɋ߂��Ȃ�

IP�X���͏������ނ̂�VPN�����p�ӂ���K�v�������đS���̎�Ԃ�������

���܂ɋC�ɂȂ������X���IP�������ĕςȂƂ���ŏo�Ă���Ɗy����

�v���o�C�_���肳�ꂽ��R�e�n���ɂȂ��č��鎖������́H

�摜����AI����X���b�h���ă��b�`���C�ƃ��b�`���C�Ȃ�����

�ȂK���Ɋi�t���ⓚ�����킹�������z�����

�r�炵�͖h�����NG�ɂ��Ղ��Ɗ�����

����ID�݂̂��r�炵�Ă�̂͂����̎���q��������������

IP�͔S�����������p���Ă��邩��J�����Ȃ��ق�����ɂ����B

�^����IP�������݂������A���[�^�[��ping�U�������ꂽ��

���݂܂���ʂ̎���X���ɂ������܂��������b�`���C����̕���Mac�͕����邩���Ƌ����Ă��炢�܂��Ă�����Ŏ��₳���Ă��������܂�

Mac��Stability Matrix���C���X�g�[�����悤�Ƃ��Ă��摜�̃G���[���o�Ď��s���Ă��܂��܂�

�G���[��ʂɃX�e�[�^�X�o�[������܂����G���[�̓��e�͉摜�ɍڂ��Ă���̂��S�Ăł�

�G���[��Portable���[�h�ɂ��Ă����l�ł���

�ǂȂ�����������ɂȂ���A����������������������܂���ł��傤��

OS��Sonoma14.3 CPU��M1 �C���X�g�[�����悤�Ƃ��Ă���Stability Matrix�̃o�[�W������2.8.0�ł�

�摜�ł킩��̂́AGit�̃C���X�g�[�����L�����Z�����ꂽ�Ƃ������Ƃ��炢�ł���

���ꂪ�S�ĂƂ̂���

> �G���[��ʂɃX�e�[�^�X�o�[������܂����G���[�̓��e�͉摜�ɍڂ��Ă���̂��S�Ăł�

4���O��MAC�Ή����ꂽ����̂���E�E

https://github.com/LykosAI/StabilityMatrix/releases > system.operationcanceledexception

�����^�C���A�E�g�ł̃L�����Z���H�ʐM�W���낤��

�O���ɂȂE���ɍs���Ė�����

>>408 > ���ꂪ�S�ĂƂ̂���

����{�����A���炵�܂���

�A�J�E���g��Git���C���X�g�[�����錠���������Ă��Ȃ��\���͂ǂ��Ȃ낤��

Stability Matrix��mac�ɃC���X�g�[�����悤�Ƃ����S�������̏�ԂȂ炷���ɏC�������Ǝv�����ǁA���������ɂȂ��Ă��Ȃ��Ȃ炱����̖��̉\����������

>>409 ���Ԏ����肪�Ƃ��������܂�

Mac�ɂ͊Ǘ��҂Ń��O�C�����Ă��܂�

�ʏ�̃A�v�����C���X�g�[������ۂɂ�OS����p�X���͂����߂��܂����A����͂ǂ̒i�K�ł����߂��܂���ł���

����̃G���[�ƊW����܂��ł��傤���c

>>410 2.8.0 Mac �C���X�g�[���ɂ͂������s����������悤�ŃA�b�v�f�[�g���o�Ă�

���⎸�炵�܂��B�T���Ă���v�����v�g�W�F�l���[�^�[������܂��B�E��̃{�^���őS�N��R-15R-18���ւ���@�\������܂����B�����m�̕������܂����H

>>410 ��������git�͓����Ă�́H

https://prog-8.com/docs/git-env > git --version

�i�������悤�Ȃ̂Łj

>>412 ����H

https://github.com/Fumiya0719/novelai_spell_generator > ��ʏ㕔�����u�S�N��v�{�^���������ƁA�u�S�N��v�uR-15�v�uR-18�v�̏��Ƀg�O����ւ����\�ł��B

NAI�������T�|�[�g�I�������݂����Ȃ��Ə����Ă邯��

���Ή����肪�Ƃ��������܂��B

�V�����o�Ă���VRAM�y�ʉ��ł�����Ă���

�w�K�f�[�^��bad anatomy��bad hands�̃L���v�V�����̂����f�[�^�͑��݂��Ȃ��͂��Ȃ̂�

>>417 ���̂����苳���Ăق���

�E�g���Ă���GPU�iVRAM�ʂ��j�͂Ȃ�ł���?

�EForge�͂ǂ�����ăC���X�g�[�����܂�����? �����N���b�N�p�b�P�[�W�i7z���𓀁j���g�����ꍇ�Aupdate.bat�͎��s���܂�����?

>>418 > �w��g�̂̕��ʂ��ƂɎ������̂Ă͂߂Ă����Ĕj�]����͔̂������Ȃ��Ǝv���Ă�

�������悭�킩��Ȃ��B�ʂ̌��t�ł��������ڂ����������Ă݂Ă��炦�܂���?

>>417 �uwebui�v�t�H���_���ɂ���uwebui-user.bat�v�́uset COMMANDLINE_ARGS=�v�Ɂu--always-offload-from-vram�v��olwci�Ƃ����邩��

�uset COMMANDLINE_ARGS=--always-offload-from-vram�v�ɂ���Ƃ������Ƃ�

>>421 �́uolwci�Ɓv�́u�lj�����Ɓv������

forge, �g���Ă݂��B������Ə������ݗʂ����Ȃ����ȁB���ɔw�i���k�������Ȃ��B���f���̊�͗]��ς��Ȃ��C������B��VRAM���ȊO�͐ϋɓI�Ɏg���C�ɂ͂Ȃ�Ȃ��Ȃ�

>>421 �lj�������ǂݍ��߂܂����@���肪�Ƃ��������܂�

>>419 1070GTX�Ƃ������≻�ōׁX�Ƃ���Ă��ł����ǁA����܂�Fooocus�ł͂Ȃ�Ƃ�XL�������Ă��܂������ASD�ł���肽���Ǝv���Ă��傤��Forge�Ȃ���̂����ꂽ�̂Ŏ���������ł���B�C���X�g�[����Git����ł��ˁB�Ƃ肠�����N��bat�̃R�}���h���C���lj��ŏȃ��[�h�����삵�܂�����

forge�͏��������낦��ƌ덷���x�łقړ����G���o����

>>423 �̏������݂̓l�^���Ǝv���ď�����������ǃ}�W�Ō����Ă�̂��ˁH

A1111�ƊG���ς��Ȃ��̂ɑ����Ȃ違VRAM����ʂ����Ȃ����Ă̂�����Ȃ̂�

�l�̊��z�Ȃ������ł���

�Y��or�����͂��ꂼ��̎�ς���э���Ă�摜�̃��x���ɂ���Ă����E�����

>>423 ��majinai�ɂł��u�����k���ɂ��Ă݂�v���ďグ�āA

>>426 ���k���ɂ���majinai�ɏグ�Ԃ����炢��

LCM�Ř_���������������ňꔭ��������

�����ݒ�œ����G���o�Ă�����̂��Y����������������륥

���͂����낮�̕���M����B

>>426 twitter����ƁA����ς���ɔw�i�ɍ����o��Ƃ̈ӌ�������܂��B���������ł����Arola�g��Ȃ��Ƃ��͍����]��o�Ȃ��̂ŁArola�̊��x���Ⴄ�̂�������܂���B

���̒��AAIAI��

�L���l�Ƃ���AI�g���ĒE�����ꂭ���āE�E�E

https://catxing.com/nogizaka.1691588330.193 lora�̊��x���Ⴄ�̂��Ƃ�����FP8�ɂȂ��Ă��

����ł�

ADetailer���I�����f�t�H���g��ON�ɂ�����@���Ă���܂����H

>>436 ui-config.json

"customscript/!adetailer.py/txt2img/Enable ADetailer/value": true,

>>437 �o���܂����I���肪�Ƃ��������܂��I

>>435 ��N�Ă�webui1.5�ł��łɑΉ��ς�

https://github.com/AUTOMATIC1111/stable-diffusion-webui/releases/tag/v1.5.0 > Lora extension rework to include other types of networks (all that were previously handled by LyCORIS extension)

> Lora �g���@�\���ĉ��H���āA���̃^�C�v�̃l�b�g���[�N (�ȑO�� LyCORIS �g���@�\�ɂ���ď�������Ă������̂��ׂ�) ���܂߂�悤�ɂ��܂����B

Lora�t�H���_�ɑS���u�`����ł����Ă�������

>>439 ������������ł��ˁA���肪�Ƃ��������܂��I

���S����LORA�t�H���_�̈�ԉ��ɂ����Ղ�u�`���݂܂�

NAI��"pussyline"���S���o�܂���B

>>442 �����A�������̃X���m��܂���ł����A���肪�Ƃ��������܂��B

sd-webui-train-tools��URL����C���X�g�[�����悤�Ƃ��Ă��G���[�o���ł��������������킩��܂����H

>>446 �G���[�̓��e���킩��킩��l�����邩��

NegPiP�̈ꕔ���������Ȃ��Ƃ��������č����Ă��܂��B

http://2chb.net/r/cg/1703250505/717 �u���v��u�����v��傫����������Ƃ��̂悤�ȏǏo�₷���ł�

����Animagine�͏o�͂ł���𑜓x�����܂��Ă��܂��B�����̉摜�̏ꍇ1344�~768�A1536�~640�Ȃǂł�

����ȏ�ɑ傫�ȉ摜�ɂ������ꍇ�A�����̉𑜓x�ŏo�͂���Hires.fix��img2img�Ŋg�傷��Ƃ����ł��傤

http://2chb.net/r/cg/1703250505/720 [datetime<%Y-%m-%d-%H%M>]��2024-02-12-1200�̂悤�ɂ͂Ȃ�܂�

�������ʂ��ԍ��͕K���t�@�C�����̐擪�ɂ��܂��̂ŁA�u�N-��-��-����-�ʂ��ԍ��v�̂悤�ȃt�@�C���������邱�Ƃ͂ł��܂���

��ֈĂƂ��ẮA�u�ۑ����Ƀt�@�C�����ɔԍ���t������iAdd number to filename when saving�j�v���I�t�ɂ�����ŁA���̉��́uSaving the image to an existing file�v���uAdd number suffix�v�ɂ���A�t�@�C�������d�������Ƃ��t�@�C�����̖����ɔԍ����lj�����܂�

�Q�l�F���p�ł���J�X�^���t�@�C�����̈ꗗ

https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Custom-Images-Filename-Name-and-Subdirectory >>449 �ԍ�����ɂ͏o���Ȃ��悤�Ŏc�O�ł�

>>448 > �Ȃ�JNVA����241

> 748 �F���A�V������wiki���Ă�����O���X�Ίp(i) ��0.774�������� (ܯ��� 277b-rRCM)�F2023/07/28(��) 00:47:09.93 ID:LIB9XePS0.net

> negpip�̓v�����v�g��74�g�[�N���܂ł�OK�ŁA75�ɂȂ�Ɠr�[�Ɍ��ʂ��Ȃ��Ȃ���ۂ�

> 752 �F���A�V������wiki���Ă�����O���X�Ίp(i) ��0.774�������� (������ Sa2b-3fi9)�F2023/07/28(��) 01:22:23.03 ID:SY/DLQGta.net

>

>>748 > �X�V���Ƃ��

�Â����ǂ����炩�Ȃ��A752�̃��X�̐^�ӂ͕s��

������NegPIP��75token�������Đ����ȁE�E30���炢�A�˂Ă�́H

��҂���ɕ����Ă݂���ǂ����낤

>>451 ��肪�Ƃ��������܂�

�ז��Ȕw�i��ߕ��̃p�[�c�Ȃǂ���͂��Ă����瓞�B���Ă��܂��܂���

Prompts from file or textbox�����p���Ă��邽�߁A�e�s�ɌʂŃl�K�e�B�u�v�����v�g��K�p���Ă���Ȃ̂Łc

���N��12�����ɃC���X�g�[������AUTOMATIC 1111�������A�b�v�f�[�g������A�摜�������x���������ɗ������̂ł����A�����킩�����������Ⴂ�܂����H

git clone�ō�蒼����models�Eoutputs�Eextensions�Ȃ�Link shell extension�ŃT�N�b�ƃV���{���b�N�����N�\�蒼�������������Ǝv��

>>453 �悭�����Ԃ���[���Ȃ���Ƃ��ăT���v���[�̑I���~�X

DPM++ 2M Karras�������̂�DPM++ SDE Karras�ɂȂ��Ă�Ƃ��H

>>453 >>454 git clone�ō�蒼�����璼��܂����A�����������܂����B�B

�����I�Ȏ���Ő\����܂���

�������T���Ă܂�

�ǂ�����Ηǂ��ł����H

>>457 python��3.10.6����Ȃ���3.13�������Ă邩��G���[�ɂȂ��Ă�

��������Ȃ������Č����Ă�悤�Ɍ������

>>458 ���ꓖ�n�̃G���[����˂���

>>457 https://github.com/AUTOMATIC1111/stable-diffusion-webui > Install Python 3.10.6 (Newer version of Python does not support torch), checking "Add Python to PATH".

�u���[�J���œ����v��google�������Ĉ�ԏ�ɏo�Ă���T�C�g�����Ȃ���T�d�ɂ��܂��傤

SD1.5�̉摜�����Ŋ炪�h�A�b�v�ŕ\�������p�^�[��������������̂ł����A�����������������������悤�Ȑݒ�������̓l�K�e�B�u�v�����v�g���Ă���܂����H

�����T�C�Y�f�J�����Đg�̂̂ǂ̕����܂ŕ`�����w�肵���炢����

�l�K�őΏ�����Ȃ�close-up�Aface focus��������K�v�ȋC������

forge�����eagle��extensions���lj����Đݒ����������Ȃ��ǁAeagle�ɉ摜�������ė��Ȃ��B

>>462 >>463 ��肪�Ƃ��������܂��B

(fullbody:1.5)�Ȃǂ����Ă��\������x�̐g�̗v�f�{���(�r���ĕ����̐��̊�ʂȂǂ�)�h�A�b�v���o�ēr���ɕ��Ă��܂������A

��Ɋւ���v�����v�g�����߂ɓ���Ă�̂ł��̉e�����傫�����ł��B

�ꉞ�T�C�Y��768x512��������768x768�ł��B

>>464 �ǂ������m���̂�����

��������A1111�Ή���extension�Ȏ��_��forge�ł��̂܂ܓ����Ȃ��̂ł́H

>>458 ,460

���w�E�̒ʂ�Đݒ肵����o���܂���

���肪�Ƃ��������܂�

������܂���

>>466 FolderID�ݒ肵�ĂȂ������c�B�Ȃ�ŋC�t���Ȃ������̂���B���肪�Ƃ��������܂��B

���₳���ĉ�����

>>470 �ݒ��ADetailer��max models���Ă̂����邩�炻���ŕύX�ł����

>>471 ���������Ӂ@��ԕ�����₷�����ɂ���܂�����

���肪�Ƃ��������܂��I

Forge��pull���ł��w�E����Ă�����

forge��controlnet�������Ȃ��Ǝv������v���v���Z�b�T�͂��邯�ǃ��f��������ہH

Forge��Mac�ł��C���X�g�[���ł��܂����H

>>473 �ꕔ��LoRA���\������Ȃ����Ƃ���܂��ˁ[

���f�����ւ��Č��ɖ߂��ƕ\�������悤�ɂȂ邱�Ƃ�����܂����m���ł͂���܂���

���Ԃ�\������Ȃ���������ł͂Ȃ��Ǝv��

�\������Ȃ��Ă��v�����v�g�Ŏw�肵���Ⴆ�@�\�͂��܂�

>>474 Forge�ɂ�ControlNet���ŏ���������Ă��܂�

controlnet�p�̃��f���́A�ŏ��͎����œ�����Ȃ��������ȁB�͂邩�̂Ȃ̂ŖY�ꂽ

models/ControlNet�ɓ���Ă��悢�ł�

SDXL�p

https://huggingface.co/lllyasviel/sd_control_collection/tree/main 1.5�p

https://huggingface.co/lllyasviel/ControlNet-v1-1/tree/main git clone�R�}���h���g��������ɗ��Ƃ��܂�

>>475 git��python 3.10.6�i�ŐV��python�͕s�j��Mac�ɓ����Ă���A�^�[�~�i������

git clone

https://github.com/lllyasviel/stable-diffusion-webui-forge.git �ŃC���X�g�[���͂ł���͂�

>>478 ���肪�Ƃ��������܂�

�A�����玎���Ă݂܂�

CivitAI�Ō��J����Ă���LoRA�t�@�C������A�`���[�j���O�Ɏg��ꂽ�摜�����邱�Ƃ��Ăł��܂����H

>>480 �����ł�

�w�K���@�E�����E�摜�T�C�Y�Ecaption�̓��v���炢�͂킩�邯�ǂˁi�킴�Ə����ĂȂ��ꍇ�j

>>477 �ł��܂����B

���������Ώ������������痝�R���킩�炸���f�����_�E�����[�h���Ēu�����L��������܂����B

���肪�Ƃ��������܂����B

>>481 �����Ȃ�ł��ˁc���肪�Ƃ��������܂��I

ControlNet������т��������C�����Ă݂���ł�����

sd�̃R���g���[���l�b�g���Ĕ��у��C����F�����Ă���Ȃ�����

���тȂ玩���ŕ`��������������Ȃ������Ďv��

�P�[�X�o�C�P�[�X����

AI�G���C������悤�ȊG�`���̎d��������������v���肻������

>>491 �P�e�C�N500�~�ł��肢���܂�

>>491 ������������Ȋ�������Ȃ���������

�݂�ȃt�F���摜���Ăǂ�����č���Ă�́H

�G���n�͂��������ڂ����l�������ł�

�yStableDiffusion�zAI�ۉ摜������35

https://mercury.bbspink.com/test/read.cgi/erocg/1705477967/ �ߔNInstagram�Ō�������悤��

�w�i��������Ă�̂Ȃ�SD�Ŋy�ɍ���

>>498 �ǂ��������菇������܂����H

�����̌����_�̒m���ł́A�n�C�N�I���e�B�ȐÎ~�������Ƃ���܂ŗ��ꂽ�̂ł���

���̃N�I���e�B��ۂ����܂܁AInstagram�Ō�������悤�ȃN�I���e�B�̉�̎��̃A�j���[�V�����ɂ���Ƃ����̂��o�����Y��ł܂�

���܈�ԗ��z�Ȃ̂͊��ɐ����ς̐Î~���2�b�ł�����ۂ����܂ܓ��������炢���ȂƎv���Ă܂�

>>499 �O�O���Ď��������ʂ̎��s�Ȃ瓚�������Ǝv�����ǁA����Ɖ���������܂��O�O��H

�u�n�C�N�I���e�B�ȐÎ~��v�Ƃ����̂���ϓI�łǂ̒��x���s������

���ɂQ�b�Ȃ�webUI�ł��i�ʂ̍H�v�Ȃ��ł����ł܂��͎�����

>>499 �ǂ��������悪���z���킩��Ȃ����ǁA���̂����肩�����Ă݂�Ƃ�

Zuntan03/EasyPromptAnime: ���[�J�� PC �Ńv�����v�g����ȒP�ɓ�������܂��B

https://github.com/Zuntan03/EasyPromptAnime >>500 �Ղ����Ă��݂܂���

���܂��O�O���ĒH�蒅����

masterpiece��realistic�ȐÎ~��Ɠ����v�����v�g�œ�����masterpiece��realistic�ȃA�j���[�V������animatediff�ł������ł���Ƃ������Ƃł�낵���ł����H

>>501 ���肪�Ƃ��������܂� �`���Ă݂܂�

���ꂱ��ʓ|�����������i�������Ȃ��ǁj���A�j������Ă݂����~�A�A�A�̂܂܁A���ǐG�ꂸ���܂�

�ʓ|�Ȃ�Runway�ɐ��������Î~��𓊂����ނ����ł��y������

AI����Ȃ��ăT�C�o�[�p���N2077�̘^��Ƃ����I�`�������肵��

�Ȃ���1�N�A�|�[�Y�͂�����x���R�ɕς����悤�ɂȂ������炢�ŁA���܂�i�����Ă���悤�ȋC�����Ȃ��̉��������H

�w�̐��x���ς������掿���サ�Ă����傤���Ȃ��Ƃ�����

���҂��傫��������

�w�̓}�W�Ŗ��\������

pony�g���Ă݂����\�}���w���}�V�ɂȂ�����ۂ���

XL��Lora�쐬���ĂāALBW�����܂������܂��s����i�K�w��12�����Ȃ��āA�掿�Ɗ炪�����ł��Ȃ��j�̂�

���߂�LyCORIS�i�K�w��20����j�Ɏ���o�����Ƃ��Ă���ǁAkohya_ss�̑I����

�ŁA�Ȃɂ��Ȃ���A�Ă�����LyCORIS���Ă̂������̂���

����ǂꂪ�悭�g���Ă�z�Ȃ́H

�NjL

https://ai-joyful.com/lycoris/ ���������T�C�g�͌����ŏo�Ă��邯�ǁA�ǂ݂̂������킩��Ȃ�

��ʓI��LyCORIS����Ă�l�ɂ悭�g���Ă�̂��ǂꂩ�m�肽��

�K����DL����safetensor�o�C�i���ŊJ�������ǂǂꂩ�킩�����

automatic1111�ŃA�b�v�f�[�g���邽�ёf���ɏo�͂���Ȃ��Ȃ��Ă���

>>515 yahoo�m�b�ܕ��݊�

���߂ăV���v����1girl������lora�������ŗL�����f���f�[�^���g����pnginfo�L��摜�����J������A�������牽�������邩������H

���܂��

�M������̂̓N���[���C���X�g�[���݂̂�

�ĊOclipskip1�ɕς���Ă��Ƃ��A���������I�`�̉\��

�������\�}�Ƃ��͍����Ă���ǂȂN�I���e�B���Ⴂ�G�����o�͂���Ȃ��č����Ă�����embeddings�ɓ����Ă�EasyNegative�Ȃǂ̃t�@�C�������̊Ԃɂ������Ăē��꒼�����猳�ɖ߂���

Lora�w�K�����ɂ������������̉摜����L�������Č��ł���

>>515 ������Đ̍�����摜��pngInfo����ǂݍ����t2i�ɑ������̂��H

���̏ꍇ�Ȃω��������clipskip1�Ƃ�VAE�Ƃ����lj����ꂽ�����o�Ă��邼

515�����ǃ��f����lora�����ޔ����čăC���X�g�[�������瑽����������

nvidia�̂��A�œ��{���ߋ��ō��l�X�V�Ƃ�

�G���p���[�����E�o�ϓ������Ă�̂�ڂ̓�����ɂ���

�f��̃����V�[���ɃG������ꂽ��A

��������dreambooth�^�ulora�ɕύX������͂��߂Đ����������łɃ^�u�̏���������ւ���

Forge�������y���炵������v���Ԃ��paperspace�̖����g�����Ă݂邩�E�E�E

http://2chb.net/r/cg/1703250505/886 Settings�́u�摜/�O���b�h�摜�̕ۑ��v�iSaving images/grids�j�ɂ���

�uinpainting�ŁA�}�X�N���ꂽ�����ӏ���ۑ�����v�iFor inpainting, save a masked composite�j���I�t�ɂ��܂�

Stability Matrix�ŁAComfyUI Manager���C���X�g�[���������ǁA

>>532 �ăC���X�g�[�����ĉ�����😊

���݂܂������܂����B���ʂɃC���X�g�[����������Comfy�t�H���_�ɓ���Ă܂����c�B

ComfyUI�Ɏ���o�����Ǝv���Ă��ł���

���AComfyUI�}�l�[�W���[�ŒT����݂����ł���

�������U�����ꂽ�̂ł����A1���̃I���L���������G���畞���Ƃ����^�Ƃ��w�K�����ĐF��ȃ|�[�Y�Ƃ�3�ʐ}�Ƃ��S�g�}�Ƃ����܂����H

�摜����AI�T�[�r�X�ł������߂��m�肽���ł��B

�G���Ȃ�NAI�����Ǎŋߐ����T�[�r�X�����Ă��Ă悭�킩���

�S�N��ŏ��p���p�\�Ȃ�B

>>538 > 1���̃I���L���������G���畞���Ƃ����^�Ƃ��w�K�����ĐF��ȃ|�[�Y

����͂ł���iLoRA�쐬��ControlNet��Reference�ANovelAI��VibesTransfer�j

> 3�ʐ}�Ƃ��S�g�}�Ƃ����܂����H

�����Ƃ���3�ʐ}�͂ǂ����Ȃ��A������rerefence sheet�Ȃǂ̃v�����v�g�Ő��ʐ}������p���o�͂��邱�Ƃ͂ł���

>>541 �G���Ȃ����p���p�\����Midjourney

ChatGPT��DALL�EE�����p���p�ł����͂�

forge�Ńu���E�U�N������controlnet��܂肽���݂���Ă��Ȃ���Ԃɂ��邱�Ƃ͉\�ł��傤���H

>>543 ���肪�Ƃ��������܂��B

���łɕ����ƃG����NAI����l�C�ł����H

����MeinaHentai��inpaint�o�[�W�������ĉ��Ɏg����ł��H

>>548 inpaint�̂Ƃ��Ɏg���ƕi�����悭�Ȃ郂�f������Ȃ�����

��������Leonardo�͕]���ǂ��ȂH

>>539 MAC�m��Ȃ����ǁAM1MAC���ă��[�J���iwebui�j�������Ȃ��́H

���������炢���ς��o�Ă��邯�ǁAhomebrew���Ȃ�

>>551 �}�W�H�@�x���Ęb�ɂȂ��Ƃ�����ꂽ���烍�[�J���͒��߂����Ă��B

���Xa1111�g���Ă�ComfyUI�������Ă݂����A�掿�����������������́H

CLIP set last layer��2(-2)�ɂ��ĂȂ��Ƃ��H

>>552 �o����o���Ȃ��ł͂Ȃ��āA�x�����Ęb���S����

M1max�Ƃ������̂�����̂�

> M1 Max����MacBook Pro���ƁA�N���������قǑ����A512�~512�̉摜�Ȃ琔�b�ō쐬�ł��܂��ˁB

�Ƃ������č�������

������M1�͊m���Ɋ̐S�̐������Ԃ������ĂȂ��T�C�g�������ˁE�E���p�ɂȂ�Ȃ��̂�

>>553 �����͂�����Œf�O�����Ȃ�

webui���悪�����Ǝv���Ă���A�܂��X�^�[�g�n�_�ɗ��ĂȂ��Ƃ���

webui���Č��\���ł��ꂱ�����Ă���ĂȂ��čĔF��

�����y���̗��_�͂����������

>>555 �ł����@�����Ȃ玎���Ă݂悤����

�_���ۂ�������Midjourney��Leonardo

forge�A�y������K�`������ɂ͗ǂ���

���I���܂�

�����Y����B

����������Ă�����������Mac�Ń��[�J���������Ă�l���Ăǂꂭ�炢���܂��H

>>550 ��n�߂ɖ����ŗV�ԂԂ�ɂ͂��Ȃ�ǂ��A�����N���W�b�g���������ƖႦ�邵

���f����������x�����Ă邵�A

��ʐl���������ʂ̃��f���������łł��Ďg����i�o���͂��ꂱ���V�ƒn�����j

�����A���̃X�e�b�v�i�K�ɂ������Ƃ����ControlNet�@�\���s�\���������L���B

���ƔŌ��G�n�A�G���n�͓��R�����i���������L�����Ȋ����j

>>560 �������ɂ���͂킩���ł���

Twitter��Ȃ�JNVA���ɉ摜���グ�Ă�l�ł��������������l�͂قڂ��Ȃ���

���͂����������̐l��Mac���[�J���Ő������Ă����Ƃ��Ă��킩��Ȃ�

Mac������Ȃ�C���X�g�[���͂ł��邩��A������Forge��Fooocus����������Ă݂Ă�

>>560 iPhone/iPad��Draw Things�̌���Discord�ǂ�ł��M1Mac�œ������Ă�l��������������݂�������

�����Ή�������A�v���ƈꏏ�Ƀ����[�X����邵

>>560 Mac��Windows�C���X�g�[����������

>>561 �G���͗��ɖ������B

�Ō����o�Ȃ��̂͂�����������Ă�ȁB

>>562 >>563 ���A���݂܂���A���̃X�����ł��Č������Ƃ��Ă��B

>>564 �������ۂǃX�y�b�N�����Ȃ��ƃ_���Ȃ�I

�y��������������ł�M1�Ő������Ă�l�͂���悤������A����Ȃ�ɂ͓����͂���

�G���T���͕s�\���\�ɂ���c�I

>>566 CPU�ł��ł��邾�낤����

�x�����Ď�ŕ`�����ق�������

�@���푈�͒u���Ƃ��āA����������Windows�ŗǂ��������Ďv����}�W��

>>554 ���Xa1111��CLIP�̐ݒ肵�ĂȂ���������Comfy�ł����ĂȂ��������ǁA2�ɂ�����啪���P�����킠�肪�Ƃ��B

����ł��܂�a1111�̂��Y��Ȃ̂��c�O�����ǁB

>>555 �����悤�Ȑl���Ĉ��S�����B

a1111�͗��ʼn�����Ă邩�킩��Â炢�Ƃ��A���������ɂ���Ă���Ă�Ƃ�������킯��

>>571 ���[�[�[�[���ƌ��J����ROCm�҂��Ă�windows���f�g���ւ̋�M�͂�߂���

>>560 MacBookAir M2 16GB��A1111��Kohya_ss���点�Ă��

�w�ʋR��ʂƂ��w�ʑ��ʂƂ��ŏ��̓�����Ō��������Ė������L�X����݂����Ȃ̂��邶��Ȃ��ł���

���C�Ȃ�1.7�ɃA�v�f�����琶������3�{���炢������悤�ɂȂ���

>>568 ���A����ϖ������B

>>574 �Ǝv�����狏����B�ł�M2���BM1��M2���\�Ⴄ���������B

�F�X���肪�Ƃ��������܂��B

embeddings�Ƀt�@�C�������Ă����f����Ȃ����ǂȂ�ŁH

>>576 1.7�ł���ȏǏ�����呛���ɂȂ��ĂƂ����ɑΉ��I����Ă邾�낤����A�ݒ�܂߂����܊Ƃ����E�E

nvidia�̃h���C�o�A�b�v�f�[�g��VRAM�����C���������ő�p���Ă߂�����x���Ȃ�A���ł͂Ȃ���ˁH�������Ƃ��Ă�낤��

�e��extension���S���A�b�v�f�[�g�����Hsampling method��step�͑S�������H

>>579 �Ȃ�ăt�@�C���H

���f�Ƃ́HTI�ɏo�Ă��Ȃ��̂��摜���ς��Ȃ��̂��AXL��1.5�͂����Ă�H

webui�N�������܂܂���textual inversion��reflesh���Ȃ��Ɠ����Ȃ����Ƃ�����

�����Ȃ�g���鎞�������ď����s��

>>575 �G���n�͐��̃X���ɂ���Ҏ҂ɕ����Ă݂�Ƃ悢

�yStableDiffusion�zAI�ۉ摜������36

https://mercury.bbspink.com/test/read.cgi/erocg/1708774858/ >>581 575�ł�

���肪�Ƃ��������܂��I

>>580 TI�ɏo�Ă��Ȃ��A1.5����Ȃ��Ǝg���Ȃ��́H

>>583 ���₾����E�E

> �Ȃ�ăt�@�C���H

�g���q�܂�

�����珑���Ă���Ȃ��ƃG�X�p�[���悤���Ȃ�

>>584 �ǂ�ȃt�@�C������Ă��g���Ȃ��A�g���q��.pt

>>578 Mac Studio������M1��a1111�����[�J���œ������Ă�

��͂葬�x���C�ɂȂ���Windows�������C���ɂ�

�Ȃ��Ă邯�Ǔ������Ƃ͓�����

>>576 �����Ďv��������Ǐ�̑O��W���Ԃ��Ƃ��ăG�X�p�[���Ă݂�

�wlycoris�x�̊g���@�\���ɂ���Ǝ���

���Ďv�������ǁA

>>576 �̏Ǐ�̊����P��vRAM���Ă邾����...

>>576 ���[

�킢���Ȃ�����

�A�v�O������Ȃ��V�K�œ��꒼�����玡������

>>586 �����E�E

��̃��f����XL�I��ł�Ȃ�XL�p��TI�����\�������A1.5���܂�������

Lora�������������肷��

������ܯ�����ID�������Ȃ�ς�����A�Ȃ�ł���

����A��������������

>>592 �ƂĂ��킩��₷���A���肪�Ƃ�

�ʏ�̂�g���Ă���肾��������XL�������̂�

>>588 ���܂�A���ꂾ�����G�G�����ɖ߂������肪�Ƃ��I

���m�̖�肾�����A�����Ă��ꂽ�l���T���L���[�I�I

>>587 ���ɑ��x���l�b�N�����B�f���ɃT�[�r�X�T���܂��B

���肪�Ƃ��������܂��B

>>594 ���}������������

�����g���ĂȂ��g���@�\���낤����A���̃o�O�m���x���b�`���Ⴂ

���N�����獡�N��2���n�߂̍X�V�ŋ������������Ȃ��Ă�͂�

��̂̐l�͌����s���̃o�O�����Ŋ��P�����蒼���Ă�Ǝv��

>>569 ���ꂽ�炢���邯�lj������Ă�́H

>>570 CPU�Ƃ����Ă����Ԃ�O���{�����̓z������P�Ȃ�CPU���͑���

����CPU�I�����[���ǂ��x���ƌ����Ă���ŕ`�����͑���

>>598 >��ŕ`�����͑���

�ꔭ�Ŏv���ʂ�̊G���o��Ȃ炻��������

���s���낵����Ɍ��Ǎו��͗v�C���Ƃ�����

�P�[�X�ɂ���Ă͂������ɒx��

>>597 ���ꂾ������}�b�N�̃��j�b�N�X��ł����������������˂���

>>600 ���������b����Ȃ��̂킩���ĂȂ�����

>>600 ���Ƃ��łɂȂ�Ń��j�b�N�X��������������������������������

�����ƍl���Ă��珑����

>>602 ���������ƕn�R�ɂȂ��

���ʂ̃l�K�e�B�u�v�����v�g�ŃN�H���e�B�㏸�n�@Worst quality:1.4�@�Ƃ��ł���Ă��ł���

foge�����N���b�N�p�b�P�[�W���Ă���P�̂ŋN�������ł��Hupdate.bat�������Ȃ��āc

>>604 �N�I���e�B�n�́A�N���b�v�X�L�b�v�̒l��P��ɂ���Ă��Ⴄ����Œ�l��f�t�H�ŋ������ʂŎg���̂͂�߂���������

���1.4~1.5������ł͂��邪�A�N�I���e�B�㏸�n�̓v���X�̌��ʂ����Ŗ����ނ��눫��������P�[�X������B

�ǂ��L��\�}�ŒP���ȊG�Ȃ���Ȃ����A���̂ɂ���ẮA�N�I���e�B�n��t���Ȃ���Ε��ʂɕ`��ł�����̂�

����ƂقƂ�Ǖ`���Ȃ��Ȃ�A�������ėȌ��ʂɂȂ�o�����ߋ��Ɋ��x��������

�����ŏ��͔]��1.5��1.4�ł��Ă����lj��x�����������o�������̂ŁA�ŋ߂͂ނ���Œ��(�x�X�g�N�I���e�B1.1�Ƃ�)�ɂ��Ă����ď��X�ɒlj����Ă�

�łȂ��Ƃǂ��������̂�������Ȃ��ŁA���H�ɖ������ނ�

>>605 DL�E�𓀂��Ē���run.bat�ł��Ƃ肠�����͓����͂�

�A���ꕔ�K�v�t�@�C����DL������̂Ńl�b�g�ڑ����ĂȂ��X�^���h�A�����ł͓����Ȃ�����

update�������Ȃ����Ă̂��悭�킩��NjN������Ǝb���l�b�g�ւ̃A�N�Z�X�Ŏ~�܂��Ă�݂����ɂȂ邯��

���\�b���琔���ŏI��锤�����ǁA���������l�b�g�ڑ��͕K�{����

�Ƃ肠�����A�b�v�f�[�g�Ƃ�forge�ڍs�Ƃ������瓯���v�����v�g��ݒ��

>>0607

a1111��forge��r��������forge��a1111�̗łƂ�����ۂ����Ȃ�����

>>609 ���܂�1111�Ƃ��g���Ă��H

�n�[�h�E�F�A�\����nVidia��GPU�ς�ł�H

PyTorch����GPU�������ĂȂ����ăG���[������CUDA��Ή��Ƃ��Ȃ�G���[�ɏo�Ă�l�ɕʂ̃X�C�b�`�Őݒ肵�Ȃ��Ɠ����Ȃ���

>>0611

>>612 3070�Ȃ���ɖ��Ȃ����Ȃ��ǂ�

�𓀂����t�H���_���f�X�N�g�b�v�ɒu�����肵�ĂȂ���ˁH

�t�H���_���͂��̂܂܂Œ��̍\�����ς�����

c:\�Ƃ�d:\�Ƃ��Ɉړ����Ă݂���t�@�C������DL���ĉ𓀃\�t�g��ʂ̕��ɕς��ĉ𓀂��Ȃ�������

���̕ӎ����Ă݂銴������

>>612 d:\�̂PTSSD�ɓW�J���Ă܂��A�𓀃\�t�g�Ȃǂ������Ă݂܂�

>>614 �ꉞ�f�X�N�g�b�v�ɉ𓀂��Ă����삷��̂͊m�F�o��������ꏊ�͂���܂�C�ɂ��Ȃ��Ă���������������

webui_forge_cu121_torch21.7z���𓀂��Ē��̃t�H���_�isystem��webui�j��bat�t�@�C���i3�j��

�t�H���_�ɓ����Ă��Ԃł�������6GB�ʂ��ȁi����N�����Ƀ��f���t�@�C����DL���I����Ă���8GB�ʁj

ui-config.json��UI��ύX���Ă��ł����A

ui-config.json��UI��ύX���Ă��ł����A

>>610 ���������b�͋�̓I�ɉ摜���o���Ă�

forge�Ɉڍs�������Ǖʂɗ����Ǝv�����Ƃ͂Ȃ��Ȃ�

forge�͔w�i�Ƃ��ו����_���������Ăǂ����Ō������ǕʂɋC�ɂȂ�Ȃ���VRAM8�ɂ͂ƂĂ����肪�����B

>>609 update.bat��webui�t�H���_�����ŐV�ɂ��邾�������珉��ł����b��

���s����ɂ͉����L�[�������Ă������� . . .

�ŏI���̎��̂͐���

���̑O�̕��ɖ��炩�ȃG���[�̕\�����Ȃ���Ζ��Ȃ�

������������O���t�B�b�N�h���C�o���Â��̂�������Ȃ�

�c�[���̔�r������Ƃ��́u���������v�����v�g�ł��������g���@�\���g���āA���������ݒ�Ő�����������~�v���炢�����������Ő����摜��r�Y�t���Ă���Ȃ��ƁA�S�����ĂɂȂ�Ȃ��̂͂���

�ŋߋC�Â����̂����Aa1111��forge�œ�������ŊG�����ς���Ă��܂��Y��ł������Alora���ɂ����Ƃ���A�S������ɂȂ����B�܂�Alora�̃E�F�C�g�̊��x���Ⴄ�悤���B

>>623 ���w�E�̒ʂ�A�p�������Ȃ���O���t�B�b�N�h���C�o�̍X�V�̂��Ƃ������۔����Ă��܂���

�X�V��͂����Ɠ��삵�Ă���A���{�ꉻ�ƃ^�O�R���v���[�g���C���X�g�[���ł��Ă��܂�

���k�ɏ���Ă��������Ă��肪�Ƃ��������܂���

>>615 ���S�ɓ����ݒ�ŁE�E�E������Ȍ���

>>625 forge�͎����̊����Ɣ����ɂȂ�Ǝv���Ă��炻���������Ƃ�

���thx

lora�t���ł��قړ����G�ɂȂ邯�ǂ�

�Ƃ肠������������o�����Ă���r�炵����Ă�����

�Ώۋ敪�F�mURL�\�L�E�����N�E�r�炵�˗��n�D��폜����

�폜�ΏۃA�h���X�F

http://2chb.net/r/cg/1708834240/4 http://2chb.net/r/cg/1708834240/22 http://2chb.net/r/cg/1708834240/34 �폜���R�E�ڍׁE���̑��F

�O�X������U�����{�����X�����x���J��Ԃ��r�炳��Ă��܂��B

��낵�����肢���܂��B

���P�N���炢�O�̊G���������o���Ă݂����A������lola���g���Ă���Ƃ��ɑS����lola�������ɂȂ����悤�ȊG���o�邱�Ƃ������

�݂Ȃ̏O�A�Ⴆ�������������G�������A�b�v�X�P�[��������d�グ��Ƃ�����ǂ������菇�ł���Ă�́H�H

> �i��G���Ă����\�����L���������炷�܂�j

Hire.fix�ō��𑜓x���E�g�傷��Ɗ�͂��������ɕ���Ă����̂ɑ̂̕����߂��Ⴍ����ɂȂ��ō����Ă܂��B

>>634 Denoising strength����������Ƃ��ł͂Ȃ��H

0.4�`0.55���炢�Ȃ炻��ȕ���Ȃ��悤��

>>635 �L��������܂�

Denoising strength�͂O.7�ɂ��Ă��܂���

���l�������Ď����Ă݂܂�

t2t��640�~768���ǂ������Ȃ̂�i2i��Just reside��denois�������Ȃ���Resize to��2�{���炢�B

t2i�������Bt2t���ăe�L�X�g����Ăǁ[����w

animatediff��forge���g���ƁA�p���p���摜�����������Ȃ���ł���

>>639 forge���ƃp���p���ɂȂ���

�o���o���ɂȂ�Ȃ��͉̂����g���Ă���́H

>>641 >>640 �́u�p���p���摜���ǂ��������̂��킩���A�ǂ������摜�ɂȂ�̂���̓I�ɐ������Ăق����v�Ƃ����Ӗ��ł���

�o�Ă����摜��catbox������ɏグ�Ă݂Ă�

AnimagineXL�ɂ��Ď���ł�

���O����̂��C�ɓ���̉摜�t�H���_��������H

>>640-642 1111���Ɠ��R����ɂȂ邯�ǁAforge���ƃt���[�������̉摜����������邾���Ȃ�ł�

�Ȃ̂Ő�����̃v���r���[�ł��̉摜�������ŕ\������܂�

1111�ʼn��炩�̐ݒ���~�X�������ɂ������Ȃ��Ă�����ł���

�ǂ����Ă������������炸

forge��xformer�����肪�������C������̂ł����Axformer�O���ƋN�����Ȃ����Ȃ��Ă��܂�

�����܂���

>>645 AnimateDiff�̂ق��͂킩����

Forge�ł����̂Ȃɂ�������̂��˂�?

������Forge��xformers�����Ă������Ȃ�Ȃ���ɁA��x�����Ɓu--disable-xformers�v�����Ȃ��ƋN�����Ȃ��Ȃ�炵��

>>646 �ǂ�Ȋ��łȂɂ��g���Ă���̂��킩��ǁA�Ђ���Ƃ����>> 588�������肵��

����? �X�y�[�X����ꂿ�����

>>648 ��

>>588 ��

646�ł�

�����܂���

>>647 ���̐ݒ�m��܂���ł����T���N�X

�I�t�N���ł�����͕ς��Ȃ����������܊��Ȃ�

>>651 Settings�i�ݒ�j-System�i�V�X�e���ݒ�j-Automatically open webui in browser on startup

�Őݒ�ύX�ł��܂�

Disable�ɂ���Ǝ����N�����Ȃ��Ȃ�܂�

>>650 �}���`�|�X�g��ɂ͉����������ƂƁA�ǂ�����ĉ����������������Ă����Ƃ����ł���

forge����Ċe��A�b�v�f�[�g���ꂽ

forge��������

1�N�Ԃ肭�炢�ɐ���AI�ĊJ���܂���

�₯��PaparSpace�̃K�`�����˂��ȂƎv������

>>657 webui�Ȃ獶���checkpoint��XL��I�Ԃ����Ȃ�ŁA1.5���f�������������g���܂�

webui���̂��̂̃o�[�W������1�N�O���Ƃ��ԂΉ�������ŐV�ɏグ�Ă�

�������ɃK�����ƕς�邾�낤����V���ɕʃC���X�g�[������������

>>656 XL��Forge�Ƃ����y�����̂��ł����̂Ŏ����Ă݂���

���U�C�N�́@�Ƃ������@���U�C�N�@�ŃO�O���ďo�Ă���c�[�����֗�����

�����̐l�ɕ�����������ǁA�����Ăǂ��ŏW�߂Ă���H

�����������������Ǝv��Ȃ��������lj������ĂȂ��̂Ɉȉ��̃G���[���o��悤�ɂȂ�܂����c

>>661 5ch���Ȃ����ς�Ȃ�JNVA������Ȃ���

�i�݂��ُ�ɑ�������A�ŐV�̏�W�܂邵�V�Z�p�������Ă݂�l������

�Ȃ�JNVA����348

http://2chb.net/r/liveuranus/1709254709/ �G�����̂̃C���X�g�̘b��ɕ肪���ł͂��邯�ǂ�

>>663 ���肪�Ƃ�

�݂�ȉ������Ȃ��g���Ă������Ă̂����ł������q���g�ɂȂ�܂���

���_�Ƃ��Ă̓G���[���\������邾���Ő����摜���̂ɂ͖�薳��

�̍�����摜��Seed�Ƃ����X��v�������畁�ʂɓ����摜���o��

�v���O���X�o�[���i�ނ��тɃR���\�[���ɂ̓h�o�h�o�G���[�f���܂��邯�ǐ���ɓ����Ă�

�܂薳�����ď�����i�߂�ׂ������G���[�̏������O�ɏo�͂����Ⴄ�悤�ɊJ���҂���炩���Ă�

������678�`680�s�ڂ̏C�����e�����Ă邩�玩���Ɠ������G���[���C�ɂȂ�l�͋������ɖ߂��Ďg���Ă�������

https://github.com/Mikubill/sd-webui-controlnet/commit/44e08759563e6eb1cec15025ac6a1075621cb555#diff-8c8d004eed5a3078434f6fbde15c178e472565ebfcb3119f308f9292c8eb7514 >>666 ����ControlNet���ŐV�ɂ���ƃG���[���R���\�[���ɏo�܂���悤�ɂȂ�Ƃ�������?

>>667 ���낢��t�я����͂��邯�ǂ���

���̏����ɂ��Ă͐[�@�肵�ĂȂ�����킩��Ȃ�����

IP-Adapter�ȊO�ł��o�邩���m��Ȃ�

���� --medvram ���Ă�Ƃ������ʂ鏈���ȋC������@�Ƃ�����Ȋ���

���₳���Ă�������

�����Ɉ�̋��ɕ����o�Ă��܂��̂������鉽���ǂ����@�͂Ȃ��ł��傤��

>>670 hires��denoising strength�����ƂȂ肪��

�P�ɓ����Ȃ�lama cleaner�ŏ����̂���ԑ�������

>>671 lama cleaner�Ƃ����̂������ł���

�L��������܂�

denoising strength�������A������ŏC���������Ǝv���܂�

depth���Ă���Ȑ����������Ȃ��H

>>664 �F�X����ɓ����Ċy�����B

���肪�Ƃ��������܂��B

����ɂ��肪���ȃK�j�Ғ��Ղ݂����Ȃ̂���肽����ł����A���ՃA���O���Ō������ǂ��v�����v�g�͂���܂����H

�l�������l����ŗ����Ă�l�Ƃ��Ⴊ��ł�l�����݂����������ǂ��������Ȃł����H

4070Ti�̕⏕�d������8�s���g���̂�6+2���{�g���̂ǂ����������H

>>677 4070Ti�N���X�ŕ⏕�d����8pin 1�{�͍l������猾���Ă�Ӗ����C�}�C�`�s������